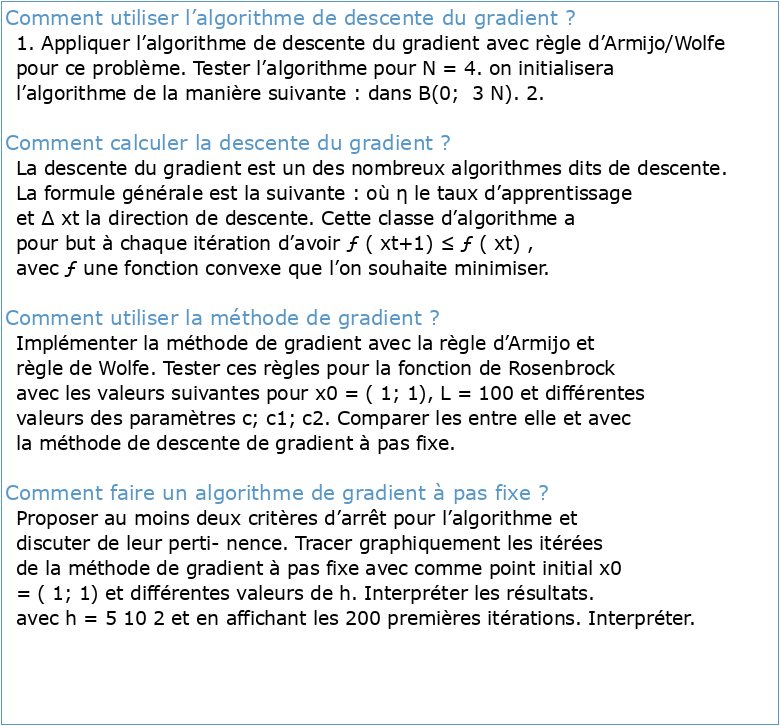

Comment utiliser l’algorithme de descente du gradient ?

1. Appliquer l’algorithme de descente du gradient avec règle d’Armijo/Wolfe pour ce problème. Tester l’algorithme pour N = 4. on initialisera l’algorithme de la manière suivante : dans B(0; 3 N). 2.

Comment calculer la descente du gradient ?

La descente du gradient est un des nombreux algorithmes dits de descente. La formule générale est la suivante : où η le taux d’apprentissage et ∆ xt la direction de descente. Cette classe d’algorithme a pour but à chaque itération d’avoir ƒ ( xt+1) ≤ ƒ ( xt) , avec ƒ une fonction convexe que l’on souhaite minimiser.

Comment utiliser la méthode de gradient ?

Implémenter la méthode de gradient avec la règle d’Armijo et règle de Wolfe. Tester ces règles pour la fonction de Rosenbrock avec les valeurs suivantes pour x0 = ( 1; 1), L = 100 et différentes valeurs des paramètres c; c1; c2. Comparer les entre elle et avec la méthode de descente de gradient à pas fixe.

Comment faire un algorithme de gradient à pas fixe ?

Proposer au moins deux critères d’arrêt pour l’algorithme et discuter de leur perti- nence. Tracer graphiquement les itérées de la méthode de gradient à pas fixe avec comme point initial x0 = ( 1; 1) et différentes valeurs de h. Interpréter les résultats. avec h = 5 10 2 et en affichant les 200 premières itérations. Interpréter.

Overview

In this tutorial, we’ll study the differences between two renowned methods for finding the minimum of a cost function. These methods are the gradient descent, well-used in machine learning, and Newton’s method, more common in numerical analysis. At the end of this tutorial, we’ll know under what conditions we can use one or the other for solving op

Gradient Descent

2.1. A Gradual Decrease In our article on the Java implementation of gradient descent, we studied how this algorithm helps us find the optimal parameters in a machine learning model. We also discussed how gradient descent, or its cousin gradient ascent, can iteratively approximate the local minimum of a function with an arbitrary degree of precision. We start with a continuous function that we want to minimize, and that’s differentiable in the interval of our interest. Then, we identify a starting point that is suff

Newton’s Method

3.1. Description of Newton’s Method Newton’s method works in a different manner. This is because it’s a method for finding the root of a function, rather than its maxima or minima. This means that, if the problem satisfies the constraints of Newton’s method, we can find for which . Not , as was the case for gradient descent. We, therefore, apply Newton’s method on the derivative of the cost function, not on the cost function itself. This is important because Newton’s method requires the analytical form of the derivative of any

The Primary Differences

The two methods aren’t equivalent, and as a general rule, we can’t replace one with the other. The first difference lies in the fact that gradient descent is parametric according to the learning rate . Newton’s method isn’t parametric, which means that we can apply it without worrying for hyperparameter optimization. A parametric version of Newton’

Conclusion

In this article, we compared gradient descent and Newton’s method for finding the minima in a cost function. See full list on baeldung.com

LE DROIT DE SAVOIR

GUIDE D'HÉMOSTASE

Intérêt de l'étude de l'hémostase délocalisée par thrombo

Master finance islamique Réalisé par : Encadré par: Azbida imane

La Gestion des Risques concepts et méthodes

Gestion des risques

Outils de gestion du « risque fournisseur » : méthodes et modèles

L’Internet et les droits de l’Homme

Le droit international privé à l'épreuve de l'internet

# 2/4 Méthode de Descente de Gradient :Principe Générale son Algorithme avec illustration Graphique

DESCENTE DE GRADIENT (GRADIENT DESCENT)