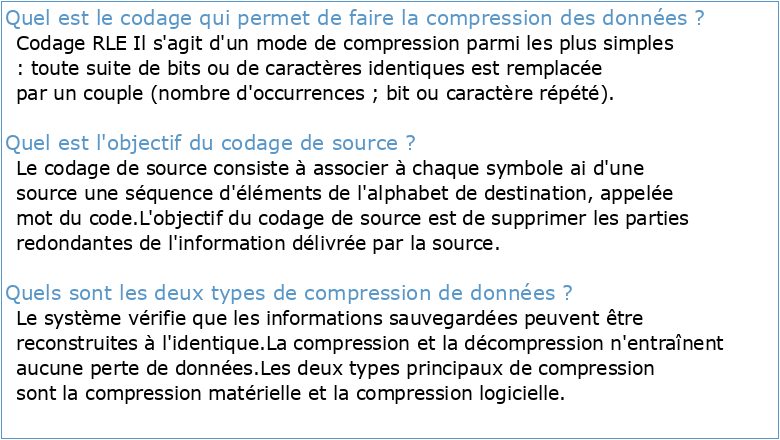

Quel est le codage qui permet de faire la compression des données ?

Codage RLE

Il s'agit d'un mode de compression parmi les plus simples : toute suite de bits ou de caractères identiques est remplacée par un couple (nombre d'occurrences ; bit ou caractère répété).Quel est l'objectif du codage de source ?

Le codage de source consiste à associer à chaque symbole ai d'une source une séquence d'éléments de l'alphabet de destination, appelée mot du code.

L'objectif du codage de source est de supprimer les parties redondantes de l'information délivrée par la source.Quels sont les deux types de compression de données ?

Le système vérifie que les informations sauvegardées peuvent être reconstruites à l'identique.

La compression et la décompression n'entraînent aucune perte de données.

Les deux types principaux de compression sont la compression matérielle et la compression logicielle.- Un des plus célèbres formats compressés, le ZIP utilise le plus souvent l'algorithme DEFLATE.

Les entrepôts de données et lanalyse de données

Entrepôt de Données et Fouille de Données Un Modèle Binaire et

Développement dune nouvelle technique de compression pour les

MEMOIRE DE MASTER DEVELOPPEMENT ET EVALUATION DES

21st Century Learning and the 4Cs

The 4 Cs

Demonstrating Competency in the 21st Century Skills (4 Cs)

Content and Language Integrated Learning: The Four Cs of CLIL

The 4 Cs to 21st Century Skills

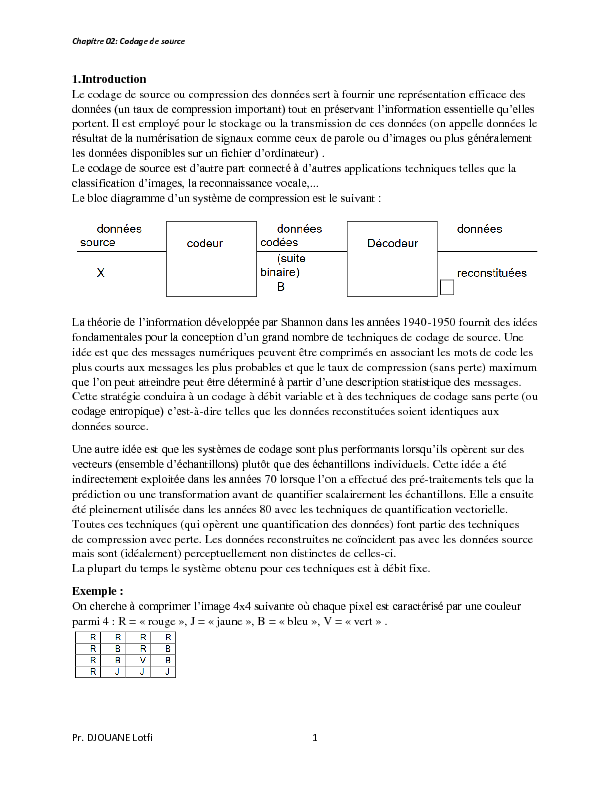

DJOUANE Lotfi 1 1.Introduction Le codage de source ou compression des données sert à fournir une représentation efficace des portent.

Il est employé pour le stockage ou la transmission de ces données (on appelle données le applications techniques telles que la -1950 fournit des idées fond techniques de codage de source.

Une idée est que des messages numériques peuvent être comprimés en associant les mots de code les plus courts aux messages les plus probables et que le taux de compression (sans perte) maximum messages.

Cette stratégie conduira à un codage à débit variable et à des techniques de codage sans perte (ou -à-dire telles que les données reconstituées soient identiques aux données source. opèrent sur des individuels.

Cette idée a été in a effectué des pré-traitements tels que la prédiction ou une transformation avant de quantifier scalairement les échantillons.

Elle a ensuite été pleinement utilisée dans les années 80 avec les techniques de quantification vectorielle.

Toutes ces techniques (qui opèrent une quantification des données) font partie des techniques de compression avec perte.

Les données reconstruites ne coïncident pas avec les données source mais sont (idéalement) perceptuellement non distinctes de celles-ci.

La plupart du temps le système obtenu pour ces techniques est à débit fixe.Exemple : parmi 4 : R = " rouge », J = " jaune », B = " bleu », V = " vert » . Chapitre 02: Codage de source Pr.

DJOUANE Lotfi 2 -Codage sans perte La méthode triviale pour transmettre cette information sous forme binaire est de code sur 2 bits à chaque couleur.

Ex : R = " 00 » B = " 01 » V = " 10 » J = " 11 » bas et de gauche à droite : 00 00 00 00, 00 01 00 01, 00 01 10 01, 00 11 11 11 Une méthode plus efficace tiendra compte des probabilités de chaque couleur en opérant différente à chaque couleur R = " 1 » B = " 01 » J = " 001 » V = " 000 » 1.

2) Le codage de Huffman est un algorithme de compression de données sans perte.Le codage de Huffman utilise un code à longueur variable pour représenter un symbole de la source (par exemple un caractère dans un fichier).

Le code est déterminé à partir d'une estimation des probabilités d'apparition des symboles de source, un code court étant associé aux symboles de source les plus fréquents. Un code de Huffman est optimal au sens de la plus courte longueur pour un codage par symbole, et une distribution de probabilité connue.

Il a été inventé par David Albert Huffman, et publié en 1952. 1.2.1) Principe Le principe du codage de Huffman repose sur la création d'une structure d'arbre composée de Supposons que la phrase à coder est " this is an example of a huffman tree ».

On recherche tout d'abord le nombre d'occurrences de chaque caractère. Dans l'exemple précédent, la phrase contient 2 fois le caractère h et 7 espaces.Chaque caractère constitue une des feuilles de l'arbre à laquelle on associe un poids égal à son nombre d'occurrences. Occurrence de chaque caractère, trié du plus fréquent au moins fréquent : L'arbre est créé de la manière suivante, on a d et tavec l et o. Chapitre 02: Codage de source Pr.

DJOUANE Lotfi 3 Quatriè-r et l-o de poids total 4 : Et cette table de codage binaire : Caractère Code binaire e 000 p 00100 r 00101 l 00110 o 00111 a 010 f 01100 h 01101 i 01110 m 01111 10 n 1100 s 1101 t 1110 u 11110 x 11111 Pour obtenir le code binaire de chaque caractère, on remonte l'arbre à partir de la racine jusqu'aux feuilles en rajoutant à chaque fois au code un 0 ou un 1 selon la branche suivie.

Il est nécessaire de partir de la racine pour obtenir les codes binaires car sinon lors de la décompression, partir des feuilles peut entraîner une confusion lors du décodage. La phrase " this is an example of a huffman tree » se code alors sur 137 bits au lieu de 288 bits (si le codage initial des caractères tient sur 8 bits). Il existe trois variantes de l'algorithme de Huffman, chacune d'elles définissant une méthode pour la création de l'arbre : a. statique Chaque octet a un code prédéfini par le logiciel.

L'arbre n'a pas besoin d'être transmis (ex. : un texte en français, où les fréquences d'apparition du 'e' sont énormes ; celui-ci aura donc un code très court). b. semi-adaptatif Le fichier est d'abord lu, de manière à calculer les occurrences de chaque octet, puis l'arbre est construit à partir des poids de chaque octet. Cet arbre restera le même jusqu'à la fin de la compression.

Cette compression occasionnera un gain de bits supérieur ou égal au codage de Chapitre 02: Codage de source Pr.

DJOUANE Lotfi 4 Huffman statique mais il sera nécessaire, pour la décompression, de transmettre l'arbre, ce qui annulera généralement le gain obtenu. c. adaptatif C'est la méthode qui offre a priori les meilleurs taux de compression car il utilise un arbre connu (et ainsi non transmis) qui sera ensuite modifié de manière dynamique au fur et à mesure de la compression du flux selon les symboles précédemment rencontrés.

Cette méthode représente cependant le gros désavantage de devoir modifier souvent l'arbre, ce qui implique un temps d'exécution plus long.

Par contre, la compression est toujours optimale et il n'est pas nécessaire que le fichier soit connu avant de compresser.

En particulier, l'algorithme est capable de travailler sur des flux de données, car il n'est pas nécessaire de connaître les symboles à venir. 1.2.

2) Performance de codage de Huffman Prenons par exemple, un cas ou les probabilités suivantes sont associées à des éléments : On commence par calculer H, la moyenne par symbole : Maintenant nous allons passer à la détermination du code de chaque symbole. On doit additionner les probabilités pour arriver à 1. on lui associe le nombre 1, et quand une branche reste au même niveau, on lui associe le nombre 0.

Ensuite, pour la lecture du code, on part du résultat total de la somme ( notre 1 final ), et on Exemple : Ici le code du symbole de probabilité a1 sera égal à 00, car il y a deux zéros entre le 1 final et la probabilité a1.

Pour a4, ça Voici le tableau final trouvé : Chapitre 02: Codage de source Pr.DJOUANE Lotfi 5 Si est le nom de la probabilité associée au symbole transmis. Pi . Code le code binaire qui représente le symbole.