COLINÉARITÉ ET RÉGRESSION LINÉAIRE Thierry FOUCART1 1

COLINÉARITÉ ET RÉGRESSION LINÉAIRE Thierry FOUCART1 1

variables explicatives Xj et la variable expliquée Y. Le vecteur b = (b1 b2

Variables explicatives indépendantes

Variables explicatives indépendantes

Que faire des variables explicatives très corrélées ? Il va sans dire que choisir une méthode statistique de prédiction nécessite dans la plupart des cas une

La résolution dun problème de multicolinéarité au sein des études

La résolution dun problème de multicolinéarité au sein des études

25 avr. 2012 l'une des variables explicatives parmi celles qui sont parfaitement corrélées entre elles. ... variable explicative par variable explicative ...

MODELES LINEAIRES

MODELES LINEAIRES

Cette situation se produit lorsque les variables explicatives sont très corrélées entre-elles. en faisant la régression de chaque variable explicative sur les ...

Les liaisons fallacieuses : quasi-colinéarité et « suppresseur

Les liaisons fallacieuses : quasi-colinéarité et « suppresseur

DEUX VARIABLES EXPLICATIVES PEU CORRÉLÉES AVEC LA. VARIABLE DÉPENDANTE ET TRÈS CORRÉLÉES ENTRE ELLES. La régression simple estime une relation linéaire entre

Les liaisons fallacieuses: quasi-colinéarité et suppresseur

Les liaisons fallacieuses: quasi-colinéarité et suppresseur

24 févr. 2012 Cet article montre qu'une régression multiple avec deux variables explicatives très corrélées entre elles et dont les corrélations simples ...

Comment bien régresser: La statistique peut-elle se passer d

Comment bien régresser: La statistique peut-elle se passer d

28 nov. 2011 transformant des variables corrélées en variables non corrélées. ... tout est corrélé dans les variables explicatives et on va quand même essayer.

Correlation et importance des variables dans les forêts aléatoires

Correlation et importance des variables dans les forêts aléatoires

La sélection de variables dans un contexte de grande dimension est une tache difficile en particulier lorsque les variables explicatives sont corrélées. L

Régression linéaire multiple : lecture en pratique

Régression linéaire multiple : lecture en pratique

Variables Xi très corrélées (multicolinéarité). => pouvoir prédictif OK mais explicatives « ajusté » sur les autres variables explicatives. ▫ Prédiction ...

COLINÉARITÉ ET RÉGRESSION LINÉAIRE Thierry FOUCART1 1

COLINÉARITÉ ET RÉGRESSION LINÉAIRE Thierry FOUCART1 1

Le facteur d'inflation fj est donc d'autant plus grand que la variable Xj est corrélée à une combinaison linéaire des autres variables explicatives.

CorReg : Préselection de variables en régression linéaire avec

CorReg : Préselection de variables en régression linéaire avec

La régression linéaire est pénalisée par l'usage de variables explicatives corrélées situation fréquente pour les bases de données d'origine industrielle

La régression logistique

La régression logistique

Régression logistique : variable explicative qualitative Régression logistique : variables explicatives mixtes ... corrélées ou non-corrélées).

Correlation et importance des variables dans les forêts aléatoires

Correlation et importance des variables dans les forêts aléatoires

tache difficile en particulier lorsque les variables explicatives sont corrélées. L'algorithme des forêts aléatoires est une méthode tr`es compétitive pour

Comment bien régresser: La statistique peut-elle se passer d

Comment bien régresser: La statistique peut-elle se passer d

28 nov. 2011 autres variables qui sont en revanche très corrélées entre elles. ... la dispersion de la variable explicative (variance expliquée par le ...

La résolution dun problème de multicolinéarité au sein des études

La résolution dun problème de multicolinéarité au sein des études

25 avr. 2012 l'une des variables explicatives parmi celles qui sont parfaitement corrélées entre elles. Ce. 3 Cet article étant prioritairement consacré ...

Introduction à la régression multiple

Introduction à la régression multiple

variables explicatives est grand comparativement au nombre d'observations dans le cas particulier de deux variables X1 et X2 très corrélées

Variables explicatives indépendantes

Variables explicatives indépendantes

Que faire des variables explicatives très corrélées ? Il va sans dire que choisir une méthode statistique de prédiction nécessite dans la plupart des cas une

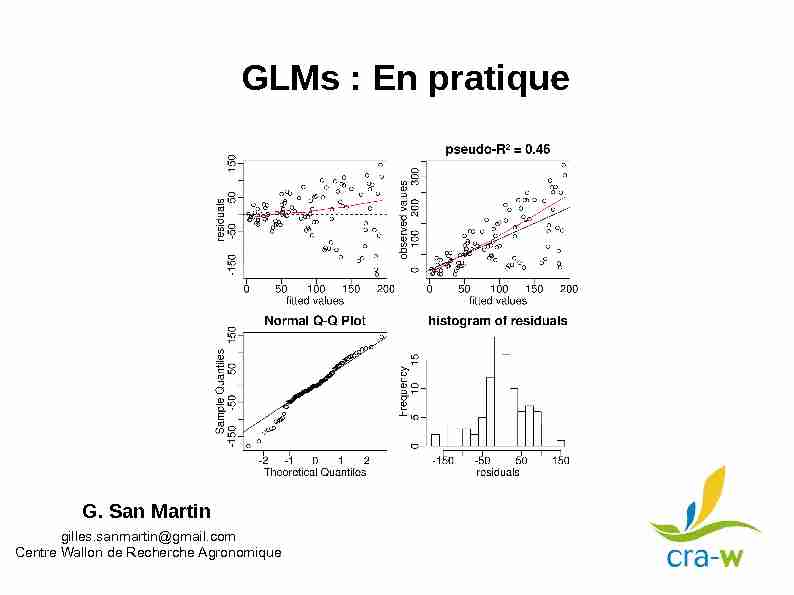

GLMs : En pratique

GLMs : En pratique

qu'on a enlevé l'effet des autres variables avec lesquelles elle sont corrélées. Multicolinéarité entre variables explicatives

Sélection de modèle en régression linéaire

Sélection de modèle en régression linéaire

variables explicatives c'est le coefficient de corrélation usuel entre Y et sa sur d'autres coefficients car leurs estimateurs sont corrélés.

[PDF] MODELES LINEAIRES

[PDF] MODELES LINEAIRES

Cette situation se produit lorsque les variables explicatives sont très corrélées entre-elles On parle alors de multi-colinéarité et cela conduit à des

[PDF] Variables explicatives indépendantes - Université Lyon 1

[PDF] Variables explicatives indépendantes - Université Lyon 1

Que faire des variables explicatives très corrélées ? Il va sans dire que choisir une méthode statistique de prédiction nécessite dans la plupart des cas une

[PDF] Chapitre 3 Etude de la liaison entre deux variables Analyse

[PDF] Chapitre 3 Etude de la liaison entre deux variables Analyse

Deux variables quantitatives sont corrélées si elles tendent à varier l'une en fonction de l'autre On parle de corrélation positive si elles tendent à

[PDF] Chapitre 4 : Régression linéaire

[PDF] Chapitre 4 : Régression linéaire

La variable X : variable âge; c'est la variable explicative appelée également régresseur les variables X et Y ne sont pas corrélées linéairement

[PDF] Chapitre 7 MODÈLE LINÉAIRE - Free

[PDF] Chapitre 7 MODÈLE LINÉAIRE - Free

MODÈLE DE RÉGRESSION SIMPLE 1 1 Variable explicative et variable expliquée On étudie en régression deux variables quantitatives dont l'une appelée variable

[PDF] Introduction `a léconométrie Notes sur la Régression Multiple

[PDF] Introduction `a léconométrie Notes sur la Régression Multiple

omise qui est incluse dans le terme d'erreur du mod`ele est corrélée avec la variable explicative du mod`ele X Autrement dit l'hypoth`ese

[PDF] COLINÉARITÉ ET RÉGRESSION LINÉAIRE Thierry FOUCART1

[PDF] COLINÉARITÉ ET RÉGRESSION LINÉAIRE Thierry FOUCART1

Les conséquences de la colinéarité statistique entre les variables explicatives sont les suivantes : - les coefficients de régression estimés peuvent être

[PDF] Lanalyse en composantes explicatives - Numdam

[PDF] Lanalyse en composantes explicatives - Numdam

De nombreuses méthodes d'analyse de données ont pour objet l'étude des relations entre un groupe de variables dites explicatives et un autre groupe de

[PDF] 243 Le coefficient de corrélation multiple (ou coefficient de

[PDF] 243 Le coefficient de corrélation multiple (ou coefficient de

Quand les variables explicatives sont aussi sujettes à erreur les coefficients estimés par régression sont biaisés Les choses deviennent beaucoup plus

Multicolinéarité dans la régression

Multicolinéarité dans la régression

Si des variables colinéaires sont de facto fortement corrélées entre elles deux variables corrélées ne sont pas forcément colinéaires En termes non

Quelles sont les variables explicatives ?

Que signifie Variable explicative ? On parle d'une variable explicative lorsque la variable explique la variable expliquée, la variable expliquée étant une variable qu'une théorie cherche à expliquer. Les économistes évaluent la capacité de la variable explicative à expliquer une situation.Comment identifier les variables explicatives ?

Les variables explicatives sont généralement représentées sur l'axe des abscisses.Comment savoir si deux variables sont corrélés ?

Deux variables quantitatives sont corrélées si elles tendent à varier l'une en fonction de l'autre. On parle de corrélation positive si elles tendent à varier dans le même sens, de corrélation négative si elles tendent à varier en sens contraire.- Une variable expliquée est souvent appelée variable endogène et représente une variable qui est expliquée par la théorie ou le modèle que l'on étudie. Elle est provoquée par une ou plusieurs forces internes au système considéré.

GLMs : En pratique

G. San Martin

gilles.sanmartin@gmail.comCentre Wallon de Recherche Agronomique

2Conditions d'application des modèlesConditions d'application des modèlesConditions d'application des modèlesConditions d'application des modèles

Les présupposés des GLMs"model assumptions"

Par ordre d'importance (selon Gelman & Hill)

1) adéquation/validité

2) linéarité - additivité

3) indépendance des résidus

4) hypothèses sur la variance des résidus

5) hypothèses sur distribution des résidus

+ l'erreur de mesure des X doit être négligeableAutres problèmes à garder en tête :

- Outliers : influence des données extrêmes (outliers) - Multicolinéarité : indépendance des variables explicatives - Overfitting : sélection de modèle nécessaire ? - Faut-il centrer ou standardiser les données ? - Quel type de tests (type I, II, III, ...), simulations, permutations,... ?3Conditions d'application des modèlesConditions d'application des modèlesConditions d'application des modèlesConditions d'application des modèles

Les présupposés des GLMs"model assumptions"

Par ordre d'importance (selon Gelman & Hill)

1) adéquation/validité

2) linéarité - additivité

3) indépendance des résidus

4) hypothèses sur la variance des résidus

5) hypothèses sur distribution des résidus

+ l'erreur de mesure des X doit être négligeableAutres problèmes à garder en tête :

- Outliers : influence des données extrêmes (outliers) - Multicolinéarité : indépendance des variables explicatives - Overfitting : sélection de modèle nécessaire ? - Faut-il centrer ou standardiser les données ? - Quel type de tests (type I, II, III, ...), simulations, permutations,... ? Les sources les plus fréquentes de problèmesà diagnostiquer

et solutionner4Conditions d'application des modèlesConditions d'application des modèlesConditions d'application des modèlesConditions d'application des modèles

Pour chaque type de présupposé/problème on va tenter de :1) Expliquer quelle est la nature du problème

2) Montrer comment on peut diagnostiquer/détecter les problèmes

3) Proposer quelques pistes de solutions

Le diagnostique se fera le plus souvent sur base de graphiques des résidus (nuages de points, QQ-Plots, histogrammes) et par le calcul de statistiques descriptives (VIFs, coefficient de surdispersion,...) Les graphiques de résidus sont particulièrement utiles. Ils permettent de détecter de nombreux problèmes différents mais il est parfois difficile de connaître la cause exacte du problème5Conditions d'application des modèlesConditions d'application des modèlesConditions d'application des modèlesConditions d'application des modèles

Il est impossible de donner une procédure linéaire pour examiner les problèmes ni de recettes automatiques pour les solutionner... L'ordre présenté ci-après est donc assez arbitraire et n'est certainement pas à appliquer tel quel. Certains diagnostiques se font avant d'estimer le premier modèle lors de la phase d'exploration des données (SPLOMs, histogrammes, matrices de corrélation,...) D'autres se font après avoir estimé un premier modèle (VIFs, surdispersion, résidus) Il faut régler tous ces problèmes avant de regarder les inférences ! Il s'agit d'un processus itératif qui permet d'améliorer progressivement le modèle en regardant les données. Cette approche est pratiquement inévitable mais le danger est d'adapter complètement lemodèle au jeu de données et que le résultat ne soit pas extrapolable à d'autres données

(overfitting / data dredging). Idéalement il faudrait un jeu de données indépendant pour tester/valider le modèle (pex via Cross-Validation)6Valeurs extrêmesValeurs extrêmesValeurs extrêmesValeurs extrêmes

7Conditions d'application des modèlesConditions d'application des modèlesConditions d'application des modèlesConditions d'application des modèles

Les présupposés des GLMs

("model assumptions")par ordre d'importance (selon Gelman & Hill)1) adéquation/validité

2) linéarité - additivité

3) indépendance des résidus

4) hypothèses sur la variance des résidus

5) hypothèses sur distribution des résidus

+ l'erreur de mesure des X doit être négligeableAutres problèmes à garder en tête :

- Outliers : influence des données extrêmes - Multicolinéarité : indépendance des variables explicatives - Overfitting : sélection de modèle nécessaire ? - Faut-il centrer ou standardiser les données ? - Quel type de tests (type I, II, III, ...), simulations, permutations,... ?8> set.seed(1)

> x <- c(rnorm(20,2,1),20) > set.seed(12) > y <- c(1 -0.5*x[1:20] + rnorm(20,0,0.5),2.5) > plot(y~x) > abline(lm(y~x)) > summary(lm(y~x))Coefficients:

Estimate Std. Error t value Pr(>|t|)

(Intercept) -0.50004 0.20273 -2.467 0.02333 * x 0.12198 0.04106 2.970 0.00786 ** Residual standard error: 0.7322 on 19 degrees of freedom Multiple R-squared: 0.3171,Adjusted R-squared: 0.2812 F-statistic: 8.823 on 1 and 19 DF, p-value: 0.00786Le problème Les résultats du GLM peuvent être très fortement influencées par une ou plusieurs valeurs beaucoup plus grandes que les autres dans les variables explicatives.Dans l'exemple suivant, on a une relation significativement positive...Valeurs extrêmesValeurs extrêmesValeurs extrêmesValeurs extrêmes

9> plot(y[1:20]~x[1:20])

> abline(lm(y[1:20]~x[1:20])) > summary(lm(y[1:20]~x[1:20]))Coefficients:

Estimate Std. Error t value Pr(>|t|)

(Intercept) 0.8518 0.2645 3.221 0.004742 ** x[1:20] -0.5079 0.1119 -4.541 0.000253 *** Residual standard error: 0.4453 on 18 degrees of freedom Multiple R-squared: 0.5339,Adjusted R-squared: 0.508 F-statistic: 20.62 on 1 and 18 DF, p-value: 0.00025Le problème Après élimination de la valeur extrême on a une relation significativement négative ... Cette relation est valide pour la gamme de valeurs de x entre 0 et 4 mais pas au delà...Valeurs extrêmesValeurs extrêmesValeurs extrêmesValeurs extrêmes10pairs2(d)

diagplot2(m)Diagnostique Toujours faire une représentation graphique des données !!SPLOM de y et des x (pairs2)

Histogrammes des x (diagonale de pairs2)

Graphiques des résidus vs variables explicatives (diagplot2)Valeurs extrêmesValeurs extrêmesValeurs extrêmesValeurs extrêmes

11Diagnostique

Il existe des statistiques descriptives des valeurs extrêmesLes principales statistiques sont :

hat values : mesurent le leverage c.à d. à quel point une valeur de x est loin des autres (idéalement h < 2 * k/n ou h < 3*k/n pour petits n) dfbetas : mesurent la différence de la valeur de chaque coefficient entre un modèle avec toutes les données et un modèle où on a enlevé une observations (les x sont standardisés)idéalement dfbetas < |1| Cook's distance : mesure plus synthétique de la précédente de l'effet dela suppression d'une observation sur l'ensemble des coefficients. idéalement Cook.dist D < 4/(n-k-1) ou pf(D, k, n - k) < 0.5

n = nombre d'observations - k = nombre de coefficients du modèle Si il y a deux valeurs extrêmes au même endroit, dfbetas et Cook ne peuvent les détecter Dans R : fonctions hatvalues(m), dfbetas(m), cooks.distance(m) summary(influence.measures(m))Dans mytoolbox.R, graphiques : influence.plot(m), dfbetas.plot(m)Valeurs extrêmesValeurs extrêmesValeurs extrêmesValeurs extrêmes

12DiagnostiqueValeurs extrêmesValeurs extrêmesValeurs extrêmesValeurs extrêmes

m <- lm(sr ~ pop15 + pop75 + dpi + ddpi, data = LifeCycleSavings) pairs2(LifeCycleSavings) diagplot2(m)13DiagnostiqueValeurs extrêmesValeurs extrêmesValeurs extrêmesValeurs extrêmes

m <- lm(sr ~ pop15 + pop75 + dpi + ddpi, data = LifeCycleSavings) pairs2(LifeCycleSavings) diagplot2(m)14DiagnostiqueValeurs extrêmesValeurs extrêmesValeurs extrêmesValeurs extrêmes

> infl <- influence.measures(m) > summary(infl)Potentially influential observations of

lm(formula = sr ~ pop15 + pop75 + dpi + ddpi, data = LifeCycleSavings) : dfb.1_ dfb.pp15 dfb.pp75 dfb.dpi dfb.ddpi dffit cov.r cook.d hat Chile -0.20 0.13 0.22 -0.02 0.12 -0.46 0.65_* 0.04 0.04 United States 0.07 -0.07 0.04 -0.23 -0.03 -0.25 1.66_* 0.01 0.33_* Zambia 0.16 -0.08 -0.34 0.09 0.23 0.75 0.51_* 0.10 0.06 Libya 0.55 -0.48 -0.38 -0.02 -1.02_* -1.16_* 2.09_* 0.27 0.53_* > inflInfluence measures of

lm(formula = sr ~ pop15 + pop75 + dpi + ddpi, data = LifeCycleSavings) : dfb.1_ dfb.pp15 dfb.pp75 dfb.dpi dfb.ddpi dffit cov.r cook.d hat inf Australia 0.01232 -0.01044 -0.02653 0.04534 -0.000159 0.0627 1.193 0.0008036 0.0677 Chile -0.19941 0.13265 0.21979 -0.01998 0.120007 -0.4554 0.655 0.0378132 0.0373 * China 0.02112 -0.00573 -0.08311 0.05180 0.110627 0.2008 1.150 0.0081570 0.0780 United Kingdom 0.04671 -0.03584 -0.17129 0.12554 0.100314 -0.2722 1.189 0.0149663 0.1165 United States 0.06910 -0.07289 0.03745 -0.23312 -0.032729 -0.2510 1.655 0.0128448 0.3337 * Venezuela -0.05083 0.10080 -0.03366 0.11366 -0.124486 0.3071 1.095 0.0188614 0.0863 Zambia 0.16361 -0.07917 -0.33899 0.09406 0.228232 0.7482 0.512 0.0966328 0.0643 * Jamaica 0.10958 -0.10022 -0.05722 -0.00703 -0.295461 -0.3456 1.200 0.0240268 0.1408 Uruguay -0.13403 0.12880 0.02953 0.13132 0.099591 -0.2051 1.187 0.0085323 0.0979 Libya 0.55074 -0.48324 -0.37974 -0.01937 -1.024477 -1.1601 2.091 0.2680704 0.5315 * Malaysia 0.03684 -0.06113 0.03235 -0.04956 -0.072294 -0.2126 1.113 0.0091134 0.065215DiagnostiqueValeurs extrêmesValeurs extrêmesValeurs extrêmesValeurs extrêmes

influence.plot(m) dfbetas.plot(m) > df <- dfbetas(m) > row.names(df)[which.min(df[, "pop75"])] [1] "Japan" JapanSeule la Lybie a un effet

important sur le coefficient ddpiNB : il y a une deuxième ligne pointillée horizontale hors du graphiqueQuantile de la Loi de Fischer.

United States : leverage important

mais malgré tout, effet limité sur les coefficients cfr Cook's D. faibleEn rouge :Les valeurs potentiellement

influentes selon summary(infl)16Solutions ?

Essayer d'éviter les "trous" dans les valeurs de x Vérifier si les valeurs extrêmes ne sont pas des erreurs d'encodage ou de mesure --> si oui : les éliminer/corriger --> si non : Transformer les x pour réduire l'influence des grandes valeurs (log, sqrt). Attention aux conséquences sur la linéarité ! Faire l'analyse avec et sans les valeurs extrêmes et discuter les résultats Utiliser des méthodes robustes aux valeurs extrêmes (robust regression pex)Valeurs extrêmesValeurs extrêmesValeurs extrêmesValeurs extrêmes17Solutions ?Valeurs extrêmesValeurs extrêmesValeurs extrêmesValeurs extrêmes

d <- LifeCycleSavings d$sqrt_ddpi <- sqrt(d$ddpi) d <- d[,-5] m <- lm(sr ~ pop15 + pop75 + dpi + sqrt_ddpi, data = d) pairs2(d) diagplot2(m)Transformation racine carrée18Solutions ?Valeurs extrêmesValeurs extrêmesValeurs extrêmesValeurs extrêmes

d <- LifeCycleSavings d$sqrt_ddpi <- sqrt(d$ddpi) d <- d[,-5] m <- lm(sr ~ pop15 + pop75 + dpi + sqrt_ddpi, data = d) pairs2(d) diagplot2(m)19Solutions ?Valeurs extrêmesValeurs extrêmesValeurs extrêmesValeurs extrêmes

> infl <- influence.measures(m) > summary(infl)Potentially influential observations of

lm(formula = sr ~ pop15 + pop75 + dpi + sqrt_ddpi, data = d) : dfb.1_ dfb.pp15 dfb.pp75 dfb.dpi dfb.sqr_ dffit cov.r cook.d hat Chile -0.20 0.14 0.23 -0.03 0.09 -0.46 0.64_* 0.04 0.04 United States 0.07 -0.07 0.03 -0.22 -0.03 -0.24 1.65_* 0.01 0.33_* Zambia 0.08 -0.04 -0.32 0.11 0.32 0.77 0.54_* 0.10 0.07 Libya 0.35 -0.29 -0.24 0.03 -0.45 -0.54 1.71_* 0.06 0.38_*20Solutions ?Valeurs extrêmesValeurs extrêmesValeurs extrêmesValeurs extrêmes

influence.plot(m) dfbetas.plot(m)21Éliminer une valeur extrême n'est pas anodin !

Prudence et honnêteté !Valeurs extrêmesValeurs extrêmesValeurs extrêmesValeurs extrêmes

22Multicolinéarité entre variables explicativesMulticolinéarité entre variables explicativesMulticolinéarité entre variables explicativesMulticolinéarité entre variables explicatives

23Conditions d'application des modèlesConditions d'application des modèlesConditions d'application des modèlesConditions d'application des modèles

Les présupposés des GLMs"model assumptions"

Par ordre d'importance (selon Gelman & Hill)

1) adéquation/validité

2) linéarité - additivité

3) indépendance des résidus

4) hypothèses sur la variance des résidus

5) hypothèses sur distribution des résidus

+ l'erreur de mesure des X doit être négligeableAutres problèmes à garder en tête :

- Outliers : influence des données extrêmes (outliers) - Multicolinéarité : indépendance des variables explicatives - Overfitting : sélection de modèle nécessaire ? - Faut-il centrer ou standardiser les données ? - Quel type de tests (type I, II, III, ...), simulations, permutations,... ?24Le problème

En régression multiple, on estime se qui se passe pour y quand x1 augmente d'une unité et que les autres variables explicatives restent inchangées. Ceci est difficile voire impossible quand ces variables sont corrélées entre elles. On parle de colinéarité lorsque deux variables sont corrélées. On parle de multicolinéarité lorsqu'une variable est corrélée avecun ensemble d'autres variables.Multicolinéarité entre variables explicativesMulticolinéarité entre variables explicativesMulticolinéarité entre variables explicativesMulticolinéarité entre variables explicatives

25Le problème

Lorsque les variables explicatives sont corrélées entre elles, on rencontre plusieurs problèmes concrets :1) les erreurs standard des paramètres augmentent

La précision des estimations est donc moindre et les p-valeurs augmentent (la puissance statistique diminue)2) on peut conclure que certaines variables n'ont pas d'effet alors

qu'elles ont un effet prises individuellement mais pas une fois qu'on a enlevé l'effet des autres variables avec lesquelles elle sontcorréléesMulticolinéarité entre variables explicativesMulticolinéarité entre variables explicativesMulticolinéarité entre variables explicativesMulticolinéarité entre variables explicatives

26Le problème

Tant qu'elle n'est pas excessive, le fait que la corrélation entre variables explicatives soit un problème ou pas va dépendre de la question posée et de l'interprétation que l'on veut faire des données. On peut par exemple utiliser la décomposition de la variance pour montrer la proportion de la variance expliquée par chaque (groupe de) variable(s) individuellement ou encommunMulticolinéarité entre variables explicativesMulticolinéarité entre variables explicativesMulticolinéarité entre variables explicativesMulticolinéarité entre variables explicatives

27> x1 <- 1:30

> x2 <- x1 + rnorm(30,0,1) > cor(x1,x2) [1] 0.9944307 > y <- 3 * x1 + rnorm(30,0,5) > summary(lm(y ~ x1))Estimate Std. Error t value Pr(>|t|)

(Intercept) -3.44910 1.56648 -2.202 0.0361 * x1 2.17374 0.08824 24.635 <2e-16 *** > summary(lm(y ~ x2))Estimate Std. Error t value Pr(>|t|)

(Intercept) -3.33677 1.71456 -1.946 0.0617 . x2 2.14809 0.09579 22.426 <2e-16 *** > summary(lm(y ~ x1 + x2))Estimate Std. Error t value Pr(>|t|)

(Intercept) -3.4381 1.5967 -2.153 0.0404 * x1 2.3094 1.0023 2.304 0.0291 * x2 -0.1352 0.9949 -0.136 0.8929 Prises individuellement, la longueur du bras gauche et du bras droit sont évidemment fortement liées à la hauteur du corpsLe problème Exemple fictif : On évalue la relation entre la hauteur d'une personne et la longueur de son bras droit et de son bras gauche... Ces 2 variables explicatives ont une corrélation de 0.994Si on les met dans le même

modèle : les erreurs standard sont multipliées par 10 et on serait tenté de dire que la hauteur du corps est liée à la longueur du bras gauche mais pas du bras droit, ce qui estfaux !Multicolinéarité entre variables explicativesMulticolinéarité entre variables explicativesMulticolinéarité entre variables explicativesMulticolinéarité entre variables explicatives

quotesdbs_dbs30.pdfusesText_36[PDF] multicolinéarité économétrie

[PDF] comment résoudre le problème de multicolinéarité

[PDF] multicolinéarité vif

[PDF] multicolinéarité spss

[PDF] fonction vif r

[PDF] facteur dinflation de la variance

[PDF] epicerie solidaire marseille

[PDF] bordereau colissimo imprimer

[PDF] tarif colissimo

[PDF] colissimo international

[PDF] suivi colissimo

[PDF] pédagogie travail collaboratif

[PDF] relation de travail entre collègues

[PDF] collaboration interprofessionnelle infirmière