Introduction à lapprentissage par renforcement

Introduction à lapprentissage par renforcement

20 juil. 2022 L'apprentissage par renforcement (reinforcement learning RL) est une méthode ... Depuis l'état s (s comme state) de l'environnement l'agent ...

Introduction à lapprentissage par renforcement

Introduction à lapprentissage par renforcement

20 juil. 2022 L'apprentissage par renforcement (reinforcement learning RL) est une méthode ... Depuis l'état s (s comme state) de l'environnement l'agent ...

LE PIÉTON ET SON ENVIRONNEMENT QUELLES INTERACTIONS

LE PIÉTON ET SON ENVIRONNEMENT QUELLES INTERACTIONS

4 juil. 2014 cavaliers et les voitures tirées par des chevaux ont cependant ... canaliser les piétons à l'écart de la circulation motorisée et de leur ...

Accessoires pour la nouvelle Golf.

Accessoires pour la nouvelle Golf.

04 Housse. (non illustrée). Épargnez la peinture de votre véhicule des effets nocifs de l'environnement grâce à cette housse spécialement adaptée à votre Golf.

Bilan de laccidentalité de lannée 2019

Bilan de laccidentalité de lannée 2019

12 août 2019 Centre d'études et d'expertise sur les risques l'environnement

Déclaration de performance extra-financière

Déclaration de performance extra-financière

respectent l'environnement les impératifs sanitaires et appliquent les règles d'équité. 6

La théorie dAlbert BANDURA : synthèse

La théorie dAlbert BANDURA : synthèse

Extraits et notes de lecture issues de : COLLECTIF 2004

Étude de localisation des stations de vélos en libre service

Étude de localisation des stations de vélos en libre service

Par contre les. Lyonnais utilisent à 53 % leur voiture particulière pour leur déplacement

Évaluation du dispositif « reconnu garant de lenvironnement » (RGE)

Évaluation du dispositif « reconnu garant de lenvironnement » (RGE)

Les particuliers insuffisamment accompagnés dans un environnement peu 04/02/2015 ... numériques (e-learning MOOC32 immersion en chantier virtuel)

Tome 1 pollution (15 juillet)

Tome 1 pollution (15 juillet)

15 juil. 2022 des véhicules à essence : « selon l'Agence de l'environnement et de la maîtrise de l'énergie l'écart entre les deux types s'est fortement ...

Learning by Ear - Africa's Environment - 04 - Cars and Bicycles

Learning by Ear - Africa's Environment - 04 - Cars and Bicycles

Learning by Ear - Africa's Environment - 04 - Cars and Bicycles doc 6/12 34 Moses: But look at all the exhaust our buses throw out 35 Gladys: It’s true the old engines are dirty and big

Environment 04 voitures et vélos - staticdwcom

Environment 04 voitures et vélos - staticdwcom

Environment - 04 OK- Cars and Bicycles_frz doc 1/8 Learning by Ear – Environnement 06 – voitures et vélos Texte : Richard Lough Rédaction et idée: Johannes Beck Introduction Bienvenue dans notre série d’émissions Learning by Ear consacrée à l’environnement Notre sujet aujourd’hui : La voiture une des principales

1 renforcement

1 renforcement Anthony JUTON Valentin NOËL Rida LALI

Édité le

20/07/2022

Cette ressource est issue Revue 3EI de juillet 2022 et fait partie du " Dossier Intelligence Artificielle » [11] -Saclay, Valentin Noëlest doctorant en imagerie médicale au Laboratoire SATIE, et Rida Lali est étudiant au DER

-Saclay.à des problèmes pour lesquels il est possible de simuler le comportement du système dans son

environnement (jeux vidéo, conduite autonome, asservissement de systèmes mécaniques...). Les

données étant générées par l'interaction entre le système et son environnement, il n'est pas

nécessaire de disposer d'un jeu de données comme pour l'apprentissage supervisé. algorithmes : le Q-Learning et le Deep Q- ne demande pas des connaissances en python très importantes. Les codes commentés sont fournis sur Culture Sciences de et sont un bon support1 Introduction

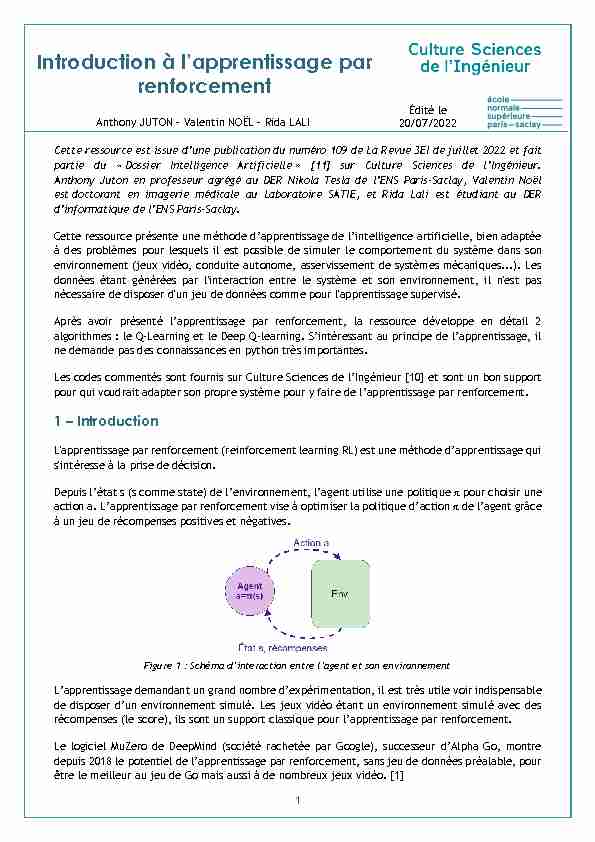

L'apprentissage

s'intéresse à la prise de décision.ʌ pour choisir une

à un jeu de récompenses positives et négatives.Figure 1

mentation, il est très utile voir indispensableLe logiciel MuZero de

être le meilleur au jeu de Go mais aussi à de nombreux jeux vidéo. [1] 2Cette ressource, non exhaustive

-learning. Enfin, nous introduirons -learning.Trois autres articles du " Dossier Intelligence Artificielle » [11] fournissent des applications pour

" » [12] utilise Matlab ; " Introductionrenforcement » [13] utilise python et les très populaires bibliothèques gym et stable

baselines. " sur AirSim » [14] utilise python, gym, stable baselines et le simulateur de voitures autonomes réaliste AirSim. 2 orcement pour sa résolution. environnement état st. agent effectue une action at qui va avoir un impa t+1 récompense rt t t+1 at est nommée fonction de transition. Figure 2 : Principe de l'apprentissage par renforcement 3 e fois cet2.1 Le processus de décision markovien

écision markovien

action a exécutée dans un état s, les proba distribution de probabilité doit être indépendante des actions et état précédents. Ainsi, le processus est modélisé par le quadruplet {S, A, T, R} . ensemble (continu ou discret) des , discret ou continu ; une , indiquant la récompense obtenue lors du passage Notons que dans un environnement déterministe, la fonction de transition est simplifiée : elle2.2 onnement

2.2.1 Le pendule inversé

Figure 3 :

4 esɽ, de la vitesse angulaire ʘ, de la positionLes actions corresp

transition peut être mclassique. En présence de frottement sec et si on considère de plus larges déplacements angulaires

du pendule, le problème est beaucoup plus complexe, mais reste déterministe. On pourrait alors écrire la fonction de transition, non linéaire.Pour la fonction de récompense

que fait le pendule avec la verticale et une récompense négative en cas de chute du pendule (angle

supérieur à 45° par exemple)La ressource " »

[12] propose un exemple de séances de travaux pratiques autour de ce problème avec Matlab et un

passage de la simulation à la réalité avec le système ControlX. La ressource " Introduction aux

bibliothèques » [13] propose a2.2.2 Corps articulé

Figure 4

Image extraite de la documentation de Gym

Gym propose plusieurs problèmes alliant robotique, biomécanique et environnement 3D. Le but de celui présenté enErreur ! Source du renvoi introuvable. un squelette mécanique debout et de le faire se déplacer sans le déséquilibrer. ble des couples appliqués à chaque articulation. 5 La fonction de transition peut prendre en compte les frottements secs de chaque articulation etdonc être non linéaire. Elle peut aussi prendre en compte du bruit sur les commandes ou sur certains

paramètres et des glissements stochastiques. Elle devient donc probabiliste.La récompense est donnée par la combinaison des deux objectifsௗ: être debout et se déplacer vers

lavant.Un système physique réel étant infiniment complexe, pour passer du système réel au système

appliquer la politique apprise en simulation sur le système réel ensuite.les jeux vidéo (ou les jeux ayant une variante vidéo) sont particulièrement propices au

ssage par renforcement.2.2.3 Jeux vidéo Atari

Les jeux vidéo

par renforcement.Les états les actions sont les

actions possibles pour le joueur, la fonction de transition les récompenses sont les variations de score à chaque action (ou non action).On pourrait imaginer des états de plus haut niveau (position de la balle, des briques et de raquettes

pour un la casse-brique breakout par exemple).Figure 5 : Jeux Atari Alien et Breakout

Images extraites de la documentation de Gym

62.2.4 Jeux à deux joueurs (

Les jeux à deux joueurs, notamment les échecs et le go, demandent de simuler un adversaire pour

: DeepBlue vainquit la champion Gary Kasparov aux échecs en 1997 et AlphaGo battit Lee Sedol au Go en 2017. Aucun systèmes toujours plus performants.Figure 6 : Jeu de go

DeepBlue, sans réseau de neurones, reposait sur le parcours dans un les données de nombreuses parties. eut être modélisé par un simple arbre depossibilité. En 2017, AlphaGo utilisait un réseau de neurones pour trouver un chemin dans cet arbre.

Le réseau de neurones était entraîné au début pour imiter les meilleurs joueurs de go, à partir de

leurs parties e renforcement prenait alors la suite. Depuis 2018, AlphaGo Zero, renommé AlphaZero, puis MuZero apprennent avec succès les jeux deGo, Echecs, Shogi, Atari, sans aucune donnée préalable, avec des algorithmes issus de

eux-mêmes.On peut alors imaginer le problème posé de la manière suivanteௗ: les états sont donnés par la

position de toutes les pièces du jeu, lafonction de transition est évidente, donnée par la règle du jeu, et la récompense est positive

Par exemple, il est possible en travaux pratiques avec des étudiants de modéliser un jeu de morpion

(Tic-Tac-Toe en anglais). Ce jeu, bien plus simple que les jeux de Go ou d'échec, permettra de développer les premières intuitions concernant l'apprentissage à deux joueurs.Figure 7 : jeu de morpion

7Les états sont le contenu des 9 cases (soit 39= 19683 états possibles, sans a priori ni

simplification),Les 9 actions possibles sont la case jouée.

La fonction de transition

La fonction de récompense peut donner 0,1 point négatif pour une action interdite (action sur une case déjà jouée), 1 point pour une victoire et -1 pour une défaite. Ces exemples de problèmes présentés, intéressons- 3 le plus possible de la politique optimale notée ʌ*.Nous étudierons ici deux méthodes en détail, avec des exemples simples codés sans usage de

framework, " from scratch » (les codes sont donnés sur [10]). La première, une méthode tabulaire

nommée Q-learning, relativement simple, permettra de bien comprendre les principes de fond ressourc renforcement.4 Apprentissage tabulaire Q-Learning

sse ici au problème très classique du lac gelé (frozen lake un esquimau cherche àrejoindre un igloo sur un lac gelé en évitant le trou), légèrement revisité pour tenir compte du

changement climatique : un lapin cherche à rejoindre une carotte sur un pré glissant en évitant le

renard. -learning utilisable pour les problèmes ayant un nombre limité problème " markovienFigure 8 : Environnement Frozen Lake revisité

8 Le projet comporte 2 fichiers, disponibles sur le dépôt indiqué en [10] : FrozenLake_2022_fenetre.py contient la description des fenêtres, des affichages et des reprend le for Game comprend un lapin qui, à partir de la case départ, doitatteindre la carotte sans sortir de la grille et en évitant le renard. Les blocs ne peuvent être

Une fois la grille créée, les bloc, carotte et renard sont fixes. limite donc à la position du lapin. Les actions sont les commandes de déplacement e : Haut, Gauche,Droite, Bas.

La fonction de transition renvoie la nouvelle position du lapin si le déplacement était possible et

: si la commande est Haut, le lapin va à la case du dessus, sauf éatoire, le lapin glisse parfois et exécute alors une action proche de celle souhaitée.La fonction de récompense attribue :

On pénalise ainsi les déplacements inutiles. -10 si la case de destination est occupée par un renard. +10 si la case de destination est occupée par une carotte.Il est évidemment possible de développer une autre fonction de récompense, en ne

pénalisant pas par exemple les déplacements inutiles.La fonction move, appelée pour chaque action, comprend à la fois la fonction de transition (elle

9 On notera que la classe Game comprend également une fonction generate_game pour générer un environnement de manière aléatoire (position des blocs, renard, carotte) et une fonction reset pour remettre le lapin à sa position initiale. et ainsi au lapin de trouver son chemin vers la carotte.4.1 Principe du Q-Learning

4.1.1 La Q-Table

ction ʌ par une table de qualité (Q-table) associant à chaque couple état-action une valeur de " qualité ».Figure 9 : Exemple de Q-table

10Chaque case Q[s,a] représente la récompense totale (nommée aussi gain) espérée par l'agent si

il démarre à l'état s, effectue l'action a, gain espéré est maximal : a = ʌ(s) = max Q[s,:]4.1.2 issage

-learning proposé par Sutton et Barto [2] est alors relativement livre de Sutton et Barto ajoutera le formalisme mathématique pour les curieux.Initialiser Q[s,a]

Répéter un nombre N de fois

initialiser l'état s répéter exécuter l'action a observer la récompense r et l'état s' mettre à jour Q :Q[ĮȖa'Q(s', a') - Q(s, a)]

s := s' jusqu'à ce que s soit l'état terminal ou pour un nombre de boucles maxInitialiser Q[s,a]

La Q-table créée est alors remplie de 0. Il peut être intéressant de remplir la table avec des valeurs

aléatoires faibles, pour éviter de privilégier un comportement (celui des actions de faible indice)

Répéter un nombre N de fois

jeu (carotte ou renard atteint). r 11Initialiser l'état s

La fonction game.reset() remet le lapin à sa position initiale. e boucles max Choisir action a depuis s en utilisant Q et un peu solutions) ou depuis la Q-table (exploitation des valeurs de la table déjà obtenues). -table. -paramètres xploration risque de limiter Q à des premières solutions non optimales (minimum local).Exécuter l'action a

Observer la récompense r et l'état s'

transition), la récompense (reward) et indique si le jeu est terminé (carotte ou renard atteint).

Mettre à jour Q :

Q[s, a] := Q[s, a] + Ş[r + Š maxa'Q(s', a') - Q(s, a)] s := s' -learning est ici, dans la prise en compte de la nouvelle récompense pour améliorer 12 trouve donc la récompense obtenue en exécutant a (r) et la récompense totale maximal a'Q(s', a')). -paramètres : ɲ͕ nommé lr dans le code (pour learning rate) et , nommé y dans le code.La nouvelle valeur de Q[s,a] est une somme de :

ɲ ou lr) est élevé, plus on prend en compte la istant. la récompense (reward) obtenue en exécutant cette action. Elle est multipliée par le taux ɲ ou lr), positif et strictement inférieur à 1. par ou y) ɲ permet de propager les récompenses importantes vers les états permettant de les atteindre. ence. -table. Sur la Erreur ! Source du renvoi introuvable. est représentée la Q-quotesdbs_dbs30.pdfusesText_36[PDF] environnement - Camping la Venise Verte - France

[PDF] Environnement - Chambre d`Agriculture de la Loire

[PDF] ENVIRONNEMENT - Cheuvreux Notaires

[PDF] Environnement - Collectif La Maison

[PDF] environnement - DREAL Aquitaine

[PDF] Environnement - la main dans le sac

[PDF] ENVIRONNEMENT - L`ADEME Basse

[PDF] ENVIRONNEMENT - mes fiches pratiques - Ordinateur

[PDF] Environnement - Région Grand Est

[PDF] environnement - Réseau ©archi.fr - Hindouisme

[PDF] Environnement - Saint Malo Agglomération - France

[PDF] Environnement - urbanisme - patrimoine - Anciens Et Réunions

[PDF] Environnement 1 - Anciens Et Réunions

[PDF] ENVIRONNEMENT : EAU ET CLIMAT