Principes et Méthodes Statistiques

Principes et Méthodes Statistiques

[PDF] Principes et Méthodes Statistiques ljk imag membres Olivier Gaudoin PMS pdf

Méthodes d estimation 1 Méthode des moments - Université de Nantes

Méthodes d estimation 1 Méthode des moments - Université de Nantes

[PDF] Méthodes d 'estimation Méthode des moments Université de Nantes math sciences univ nantes ~lavancie TD Stat inf pdf

Estimation paramétrique

Estimation paramétrique

[PDF] Estimation paramétrique math univ toulouse ~besse Wikistat pdf st m inf esti pdf

Corrigé du TD no 1

Corrigé du TD no 1

[PDF] Corrigé du TD no wintenberger cours TDM corrige pdf

Statistiques - Quelques méthodes d estimation - Julian Tugaut

Statistiques - Quelques méthodes d estimation - Julian Tugaut

[PDF] Statistiques Quelques méthodes d 'estimation Julian Tugauttugaut perso math cnrs pdf enseignement SFI CM pdf

TD1 : méthode des moments et maximum de vraisemblance

TD1 : méthode des moments et maximum de vraisemblance

[PDF] TD méthode des moments et maximum de vraisemblancemath unice ~rubentha td l mass stats pdf

Statistiques: estimation ponctuelle - IECL - Université de Lorraine

Statistiques: estimation ponctuelle - IECL - Université de Lorraine

[PDF] Statistiques estimation ponctuelle IECL Université de Lorraine iecl univ lorraine ~Samy Tindel estim ponctuelle pdf

Autour de la méthode des moments

Autour de la méthode des moments

[PDF] Autour de la méthode des moments math ens enseignement telecharger fichier php?

Correction de l examen de Statistique du Mardi 7 décembre 2010

Correction de l examen de Statistique du Mardi 7 décembre 2010

[PDF] Correction de l 'examen de Statistique du Mardi décembre tourneret perso enseeiht Statistics correctionstat pdf

(ESA) Macro-Econométrie Méthodes de Moments - Université d

(ESA) Macro-Econométrie Méthodes de Moments - Université d

janv méthodes de moments et plus spécifiquement les GMM Par exemple, dans la théorie des anticipations pures de la structure par terme des taux

[PDF] methode des moments exercices corrigés

[PDF] comment construire un diagramme triangulaire

[PDF] mariage mixte au maroc pièces a fournir

[PDF] mariage mixte marocaine francais

[PDF] mariage mixte au maroc 2017

[PDF] le mariage mixte au maroc pdf

[PDF] témoignage d'un survivant d'auschwitz

[PDF] comment calculer le qaly

[PDF] introduction ? l optimisation

[PDF] optimisation numérique aspects théoriques et pratiques

[PDF] fonction coercive

[PDF] les causes de l'avortement

[PDF] livre d optimisation pdf

[PDF] pdf avortement spontané

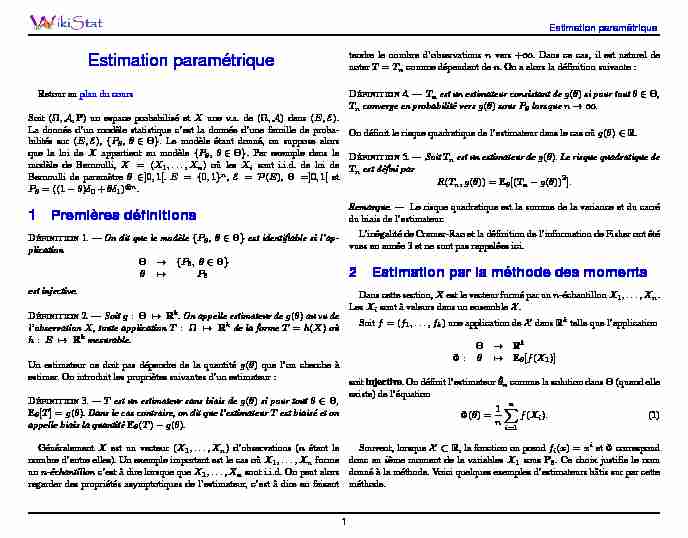

Estimation paramétrique

Estimation paramétrique

Retour au

plan du cours Soit( ;A;P)un espace probabilisé etXune v.a. de( ;A)dans(E;E). La donnée d"un modèle statistique c"est la donnée d"une famille de proba- bilités sur(E;E),fP; 2g. Le modèle étant donné, on suppose alors que la loi deXappartient au modèlefP; 2g. Par exemple dans le modèle de Bernoulli,X= (X1;:::;Xn)où lesXisont i.i.d. de loi de Bernoulli de paramètre2]0;1[.E=f0;1gn,E=P(E), =]0;1[et P = ((1)0+1) n.1 Premières définitions

DÉFINITION1. - On dit que le modèlefP; 2gest identifiable si l"ap- plication ! fP; 2g 7!P est injective. DÉFINITION2. - Soitg: 7!Rk. On appelle estimateur deg()au vu de l"observationX, toute applicationT:7!Rkde la formeT=h(X)où

h:E7!Rkmesurable. Un estimateur ne doit pas dépendre de la quantitég()que l"on cherche à estimer. On introduit les propriètes suivantes d"un estimateur : DÉFINITION3. -Test un estimateur sans biais deg()si pour tout2, E [T] =g(). Dans le cas contraire, on dit que l"estimateurTest biaisé et on appelle biais la quantitéE(T)g(). GénéralementXest un vecteur(X1;:::;Xn)d"observations (nétant le nombre d"entre elles). Un exemple important est le cas oùX1;:::;Xnforme unn-échantillonc"est à dire lorsque queX1;:::;Xnsont i.i.d. On peut alorsregarder des propriétés asymptotiques de l"estimateur, c"est à dire en faisanttendre le nombre d"observationsnvers+1. Dans ce cas, il est naturel de

noterT=Tncomme dépendant den. On a alors la définition suivante : DÉFINITION4. -Tnest un estimateur consistant deg()si pour tout2, T nconverge en probabilité versg()sousPlorsquen! 1. On définit le risque quadratique de l"estimateur dans le cas oùg()2R. DÉFINITION5. - SoitTnest un estimateur deg(). Le risque quadratique de T nest défini parR(Tn;g()) =E[(Tng())2]:

Remarque. -Le risque quadratique est la somme de la variance et du carré du biais de l"estimateur. L"inégalité de Cramer-Rao et la définition de l"information de Fisher ont été vues en année 3 et ne sont pas rappelées ici.2 Estimation par la méthode des moments

Dans cette section,Xest le vecteur formé par unn-échantillonX1;:::;Xn.LesXisont à valeurs dans un ensembleX.

Soitf= (f1;:::;fk)une application deXdansRktelle que l"application !Rk :7!E[f(X1)] soitinjective. On définit l"estimateur^ncomme la solution dans(quand elle existe) de l"équation () =1n n X i=1f(Xi):(1) Souvent, lorsqueX R, la fonction on prendfi(x) =xietcorrespond donc auième moment de la variablesX1sousP. Ce choix justifie le nom donné à la méthode. Voici quelques exemples d"estimateurs bâtis sur par cette méthode.1Estimation paramétrique

2.1 Loi exponentielle

Icik= 1,Q=E()pour2R+. Comme pour tout,E[X1] = 1=

on prend() = 1=etf=Id:R+!R+. L"estimateur obtenu par la méthode des moments est n=1X noùX n=1n n X i=1X i: Par continuité de l"applicationx!1=x,^nest un estimateur consistant de.Remarquons queX

n>0p.s. ce qui justifie l"égalité ci-dessus.2.2 Loi uniforme

Icik= 1,Qest la loi uniforme sur[0;]avec >0. On a que pour tout,E[X1] ==2, on peut donc prendre par exemple() ==2et f=Id:R!R. L"estimateur obtenu par la méthode des moments est alors^n= 2X n. Cet estimateur est sans bias et consistant.2.3 Loi gaussienne

Icik= 2, on prend= (m;)2RR+,Q=N(m;). Pour tout

= (m;),E[X1] =metE[X21] =m2+. On peut donc prendre, par exemple,f1(x) =xetf2(x) =x2ce qui donne(m;) = (m;m2+). L"estimateur obtenus par la méthode des moments vérifie ^mn=X net ^m2n+ ^n=1n n X i=1X 2i: c"est a dire n= X n;1n n X i=1 XiX n 2! L"estimateur est consistant mais l"estimateur de la variance est biaisé.2.4 Propriétés asymptotiques

Notons() =E(1n

P n i=1f(Xi)). Supposons queX1;:::;Xnsont i.i.d.de loiP0. Les résultats de consistance précédents étaient obtenus grâce au faitque d"une part,

1n n X i=1f(Xi)p:s:!(0); et donc, comme1existe et est continue au voisinage de(0), on en déduit que ^nexiste et vérifie np:s:!1(0) =0:Mais que peut-on dire de la distance de

^nà0? Sous l"hypothèse que E0[kfk2]<+1on a grâce au théorème central limite que

pn 1n n X i=1f(Xi)(0)!Loi! Nk(0;(0));

où(0)la matrice covariance def(X1)sousP0. Elle est définie pouri;j2 f1;:::;kg i;j(0) =Cov0[fi(X1)fj(X1)]:La Delta méthode (cf Proposition

16 ) va nous permettre de déduire un résultat similaire pour^n: THÉORÈME6. - Supposons quesoit de classeC1dedansRket que02, et queD0 :Rk!Rksoit inversible. Supposons de plus que

E0[kf(X1)k2]<+1et notons(0)la matrice covariance def(X1)sous

P0. Alors sousP0:

^nexiste avec une probabilité tendant vers 1 on a la con vergenceen loi pn ^n0Loi! N

0;(D0)1(0)

(D0)10 Démonstration. -CommeD0est inversible,Dreste inversible dans un voisinage de0et donc, d"après le théorème de l"inversion locale,réalise un difféomorphisme d"un voisinageUde0dansVun voisinage de(0). Par la2Estimation paramétrique

loi des grands nombres, ^Yn=n1Pn i=1f(Xi)converge en probabilité (car p.s.) vers(0)et donc^Ynappartient àVavec une probabilité tendant vers 1 quandntend vers+1. Sur cet événement, l"équation (1) admet une uniquesolution^ndans(par injectivité de) et cette solution vérifie^n2Uet^n= 1(^Yn)où1est définie deVdansU. On a par ailleurs,

pn ^n0 =pn ^n1^Yn=2V+pn ^n1^Yn2V0 pn ^n1^Yn=2V+pn[~1^Yn ~1((0))](2) où ~1(y) = 1(y)1y2V. Orpn ^n1^Yn=2Vconverge vers 0 en probabilité car pour tout" >0, P 0[apn ^n1^Yn=2V> "]P0[^Yn62V]!n!+10: D"après le lemme de Slutsky, il suffit donc de montrer que le second terme du membre de droite de ( 2 ) converge en loi vers la limite annoncée. Or par théoreme centrale limite vectoriel pn ^Yn(0)