Module 7 - Arbres de décisions Exercices - Corrigé

Module 7 - Arbres de décisions Exercices - Corrigé

Page 1. Module 7 - Arbres de décisions. Exercices - Corrigé. Exercice 2. L'entropie peut être calculée selon : Individu. Taille. Couleur. Class.

Chapitre 9 Arbres de décision Solutions

Chapitre 9 Arbres de décision Solutions

Arbres de décision. Solutions. 1. Pour classifier un nouvel exemple on traverse l'arbre depuis la racine jusqu'`a une feuille. Pour chaque nœud interne

Apprentissage de r`egles et arbres de décision

Apprentissage de r`egles et arbres de décision

Un arbre de décision A représente une fonction hA : S→Y définie de la mani`ere Exercices. Question 1.1 Lequel de ces trois attributs semble le mieux pour.

Exercice arbres de décision Problème de la compression/ dilation

Exercice arbres de décision Problème de la compression/ dilation

Exercice arbres de décision. ▫ Construire l'arbre de décision à partir des données suivantes en utilisant l'algorithme ID3. ▫ Rappel: 2. Présence.

Corrigé

Corrigé

Exercice 2 (10 points) : Le tableau suivant contient des données sur les Nous avons donc deux arbres de décision possibles : Bien. Mention ? Admis. 8.

Apprentissage artificiel: Arbre de décisions

Apprentissage artificiel: Arbre de décisions

Exercice. Sachant que le premier attribut sélectionné est type continuer la construction de l'arbre de décision correspondant à cette base en utilisant l

Arbres de décision

Arbres de décision

tiré de Bratko exercice 18.2. Une maladie M est présente dans 25% des cas incorrectes produites par l'arbre de décision

Exercices corrigés sur probl`emes NP-complets

Exercices corrigés sur probl`emes NP-complets

12 sept. 2018 ENONC´ES DES EXERCICES. I) Probl`eme de décisions a) Graphe eulérien ... Probl`eme k-Arbre-coloration. Données : Un arbre T = (VE) et un entier k ...

Examen

Examen

10 janv. 2016 Calculer les r`egles solides correspondant `a un seuil de confidence = 0.9. 4. En déduire un mod`ele de décision. B. Arbre de décision (4 pts :3 ...

Synthèse de cours exercices corrigés

Synthèse de cours exercices corrigés

Arbre binomial. 2 périodes avec les probabilités risque neutre associées à chaque ... décision d'investissement ainsi que l'utilisation des options réelles ...

Module 7 - Arbres de décisions Exercices - Corrigé

Module 7 - Arbres de décisions Exercices - Corrigé

Page 1. Module 7 - Arbres de décisions. Exercices - Corrigé. Exercice 2. L'entropie peut être calculée selon : Individu. Taille. Couleur. Class.

Arbres de décision

Arbres de décision

Arbres de décision. François Paradis. Décembre 2005 Construction d'un arbre. • à chaque noeud choisir l'attribut de ... tiré de Bratko

Chapitre 9 Arbres de décision Solutions

Chapitre 9 Arbres de décision Solutions

Arbres de décision. Solutions. 1. Pour classifier un nouvel exemple on traverse l'arbre depuis la racine jusqu'`a une feuille.

Apprentissage de r`egles et arbres de décision

Apprentissage de r`egles et arbres de décision

R`egles et arbres de décision : Arbres. Un arbre de décision pour X1

Exercice arbres de décision Problème de la compression/ dilation

Exercice arbres de décision Problème de la compression/ dilation

Hidden Markov Model. (HMM). 1. Exercice arbres de décision. ? Construire l'arbre de décision à partir des données suivantes en utilisant l'algorithme ID3.

Exercices corrigés Arbre de décision

Exercices corrigés Arbre de décision

Exercices corrigés. Arbre de décision. Les arbres de décisions permettent de caractériser une classe d'algorithmes de tris : les algos de tris par.

Corrigé type (contrôle S5)

Corrigé type (contrôle S5)

4 févr. 2021 Construction du plus petit arbre de décision possible. Exercice 1 (4.5pts) : soit la matrice de décision suivante :.

Exercices corrigés sur probl`emes NP-complets

Exercices corrigés sur probl`emes NP-complets

12 sept. 2018 Ecrire le probl`eme de décision qui lui est associé et donner la taille de l'instance. Question 1.2. Trouver un algorithme polynomial qui ...

Chapitre 9 – Solutions des exercices de révision

Chapitre 9 – Solutions des exercices de révision

Le détail des calculs des trois exercices de cette section ainsi que des Un arbre de décision représentant le problème de l'expert est donné ci-dessous.

Corrigé type (contrôle S5)

Corrigé type (contrôle S5)

13 janv. 2019 Construction du plus petit arbre de décision possible. Exercice 1 (4.5pts) : soit la matrice de décision suivante :.

Module 7 - Arbres de décisions Exercices - Corrigé

Module 7 - Arbres de décisions Exercices - Corrigé

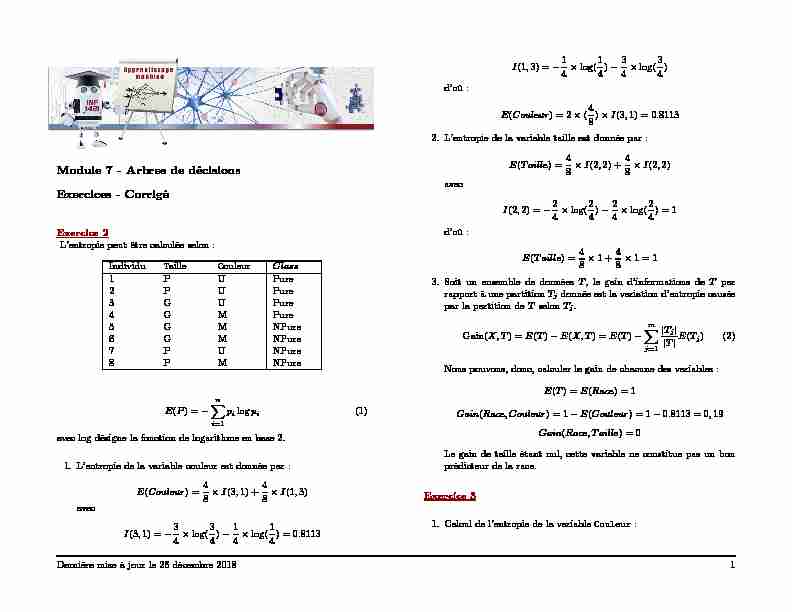

Module 7 - Arbres de décisions Exercices - Corrigé Exercice 2 L’entropiepeutêtrecalculéeselon: Individu Taille Couleur Class 1 P U Pure 2 P U Pure 3 G U Pure 4 G M Pure 5 G M NPure 6 G M NPure 7 P U NPure 8 P M NPure E(P) = Xn i=1 p i logp i (1) aveclog désignelafonctiondelogarithmeenbase2 1 L’entropiedelavariablecouleurestdonnéepar

Les arbres de décision (decision trees) - Paris Descartes

Les arbres de décision (decision trees) - Paris Descartes

LINF2275 Arbre de Décision 6 • Phase de construction d'un arbre (parallèle aux axes): 2 étapes à chaque nœud d'un arbre en construction (processus récursif): 1 Production d'une série de tests relatifs aux différentes variables (qualitatives ou quantitatives): – pour les variables quantitatives (discrète ou continue): tests

Searches related to arbre de décision exercices corrigés PDF

Searches related to arbre de décision exercices corrigés PDF

Après avoir détaillé les points clés de la construction d’un arbre de décision à partir d’un petit exemple nous présentons la méthode CHAID qui permet de répondre de manière cohérente à ces spécifications Nous la mettons alors en œuvre en utilisant un logiciel gratuit téléchargeable sur Internet

Quels sont les caractéristiques d'un arbre de décision ?

Les avantages et les inconvénients. Premièrement, les arbres de décision prennent très peu de temps pour traiter les données par rapport aux autres algorithmes. Les étapes de préparation de données comme par exemple la normalisation, la transformation et la mise à l'échelle des données ne sont pas nécessaires.

Comment dessiner un arbre de décision ?

Pour dessiner un arbre de décision, choisissez d'abord un support. Vous pouvez le dessiner à main levée sur du papier ou sur un tableau blanc, ou vous pouvez utiliser un logiciel d'arbres de décision spécialisé. Dans tous les cas, voici les étapes à suivre : 1. Commencez par la décision principale.

Comment coder un arbre de décision ?

Pour coder un arbre de de?cision associe? a? un certain algorithme de tri sur T, on utilise un type Noeud avec un champ boole?en EstFeuille indiquant si le nœud est une feuille ou non. En Ada (voir figure 3), on fait de ce champ un discriminant.

Qu'est-ce que l'apprentissage par arbre de décision ?

Cette méthode, appelée « apprentissage par arbre de décision », s'appuie sur les observations relatives à un élément pour prédire la valeur de cet élément. Dans ces arbres de décision, les nœuds représentent les données plutôt que les décisions. Ce type d'arbre est aussi appelé arbre de classification.

Module 7 - Arbres de décisions

Exercices - Corrigé

Exercice 2L"entropie peut être calculée selon :IndividuTailleCouleurClass

1 P UPure

2 P UPure

3 G UPure

4 G MPure

5 G MNPure

6 G MNPure

7 P UNPure

8 P MNPure

E(P) =nX

i=1p ilogpi(1) aveclogdésigne la fonction de logarithme en base 2. 1. L"en tropiede la v ariablecouleur est donnée par :E(Couleur) =48

I(3;1) +48

I(1;3)

avecI(3;1) =34

log(34 )14 log(14 ) = 0:8113I(1;3) =14 log(14 )34 log(34 d"où :E(Couleur) = 2(48

)I(3;1) = 0:8113 2. L"en tropiede la v ariabletaille est donné epar :E(Taille) =48

I(2;2) +48

I(2;2)

avecI(2;2) =24

log(24 )24 log(24 ) = 1 d"où :E(Taille) =48

1 +48 1 = 1 3. Soit un ensem blede donnée sT, le gain d"informations deTpar rapport à une partitionTjdonnée est la variation d"entropie causée par la partition deTselonTj.Gain(X;T) =E(T)E(X;T) =E(T)mX

j=1jTjjjTjE(Tj)(2) Nous pouvons, donc, calculer le gain de chacune des variables :E(T) =E(Race) = 1

Gain(Race;Couleur) = 1E(Couleur) = 10:8113 = 0;19

Gain(Race;Taille) = 0

Le gain de taille étant nul, cette variable ne constitue pas un bon prédicteur de la race.Exercice 31.Calcul de l"en tropiede la v ariableCouleur:Dernière mise à jour le 26 décembre 20181

1i n s t a l l. p ackages( "DescTools")2library( "DescTools")3Data nrow =8, n col =4,b yrow=T) 4#E ntropied el av ariableC ouleur5EntrCouleur=Entropy(Data [ ,3] , Data [ ,4] , base=2)16View( EntrCouleur )7#E ntropied el av ariablec lasse8EntrClasse=Entropy(Data [ ,4] , base=2)19View( EntrClasse )10#C alculd uG aind el av ariableC ouleur11GainCouleur=EntrClasseEntrCouleur12View( GainCouleur )L"entropie de la variableCouleurest 0,8113

2. Calcul de l"en tropiede la v ariableTaille:1#E ntropied el av ariablec lasse2EntrClasse=Entropy(Data [ ,4] , base=2)13View( EntrClasse )4#C alculd uG aind el av ariableT aille5GainTaille=EntrClasseEntrTaille6View( GainTaille )L"entropie de la variableTailleest 1

3. Le gain qui est defini par : 1#C alculd ug aind el av ariable" T aille" 2I 5}6Entropie< (4/8)?log( 4/8)(4/8)?log( 4/8)7GTaille tor" :1#I nstallerl ab ibliotheque" FSelector"2i n s t a l l. p ackages( "FSelector")3 4#C hargerl ab ibliotheque5library( F Selector) 6

7weights< information . gain (Data$Class~Data$T aille+ D ata$Couleur, D ata, u nit= " log2")

Donc, puisque la fonction Gain égale à zéro, alors, la variable Taille ne constitue pas un bon prédicteur de la race. Exercice 41.Installer et c hargerles bibliothè quesrpartetFSelector:1i n s t a l l. p ackages( "rpart", d ep=TRUE)2library( r part) 3i n s t a l l. p ackages( "FSelector")4library( F Selector) 2.Imp ortationdes deux base de données : irisetkyphosis1#I mporterl ab ased ed onnees" i r i s " 2data( i r i s ) 3

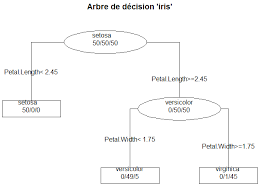

4#I mporterl ab ased ed onnees" kyphosis"5data( k yphosis) 3.Les arbres de décisions des ensem blesde données son t:

1#A rbred ed ecisiond el ab ased ed onnees" i r i s " 2dev. new()3arbreIris = rpart ( i r i s$ Species~ . , m ethod="c lass" , minsplit =20, xval=81,d ata=ir i s )

4plot( a rbreIris, u niform=TRUE,m argin=0.1, m ain="Arbred edecision" i ris" " )

5text( a rbreIris, f ancy=TRUE,u se. n=TRUE,p retty=0,a ll=TRUE)

6#A rbred ed ecisiond el ab ased ed onnees" Kyphosis"7dev. new()8arbreKyphosis = rpart ( Kyphosis~ . , m ethod="c lass" , minsplit =20, xval=81,d ata=k yphosis)

9plot( a rbreKyphosis, u niform=TRUE,m argin=0.1, m ain="Arbreded ecision" k yphosis" " )

10text( a rbreKyphosis, f ancy=TRUE,u se. n=TRUE,p retty=0,a ll=TRUE)

Dernière mise à jour le 26 décembre 20182 4.Rapp ortde gain et gain p ourc haqueattribut : 1#C alculG ainr atione tG ainp ourl esa ttributs2print( "I r i s D atabase")3information . gain ( Species~., d ata=iris, u nit= " log2")4gain . ratio ( Species~ ., d ata=iris, u nit= " log2")5

6print( "kyphosisD atabase")7information . gain ( Kyphosis~., d ata=kyphosis, u nit= " log2")

8gain . ratio ( Kyphosis~ ., d ata=kyphosis, u nit= " log2")5.Les attributs qui on tplus d"imp ortancep ourla base de données

"iris" sont : P etal.Length

P etal.With

L"attribut qui a plus d"importance pour la base de données "kyphosis" est :Dernière mise à jour le 26 décembre 20183 -Start 6. Après élimin ationdes attributs non imp ortants,nous obtenons les arbres suivants :1#A rbred ed ecisiond el ab ased ed onnees" i r i s " 2dev. new()3arbre = rpart ( i r i s$ Species~ P etal. L ength+ Petal. Width, method="c lass" , m insplit= 20,x val=81,d ata=ir i s )

4plot( a rbre, u niform=TRUE,m argin=0.1, m ain="Arbred edecision" i ris" " )

5text( a rbre, f ancy=TRUE,u se. n=TRUE,p retty=0,a ll=TRUE)6

7#A rbred ed ecisiond el ab ased ed onnees" Kyphosis"8dev. new()9arbre = rpart ( Kyphosis~ S tart, m ethod="c lass" , m insplit=20, xval=81,d ata=k yphosis)

10plot( a rbre, u niform=TRUE,m argin=0.1, m ain="Arbred edecision" k yphosis" " )

11text( a rbre, f ancy=TRUE,u se. n=TRUE,p retty=0,a ll=TRUE)Exercice 4

1. Chargemen tda la base de données "CreditData.txt" en utilisan tR : 1#C hargerl ab ased ed onnees2Data TRUE, sep =

2. Divisez la base de données en base d"appren tissageet en base de test :1#Based " e ntrainenemt2Train Algorithmes CAR T: 1#A rbred ed ecisionC ART2library( r part) 3i n s t a l l. p ackages( "rpart. p lot")4library( r part. p lot) 5dev. new()6Arbre1= rpart ( Train$C reditability~. , d ata=T rain) 7prp(Arbre1 , extra=1)8t i t l e( "Arbred ed ecisionC artbased " e ntrainement")

Dernière mise à jour le 26 décembre 20184 -Algorithmes C5.0 : 1i n s t a l l. p ackages( "C50")2library( C50)3Train 14Arbre2< C5.0( x = ( kyphosis [ ,1]) , y = kyphosis$Kyphosis )

15summary(Arbre2)16plot( Arbre2)17

18dev. new()19data( c hurn) 20treeModel< C5.0( x = Train [ ,1], y = Train$Creditability )

21

22plot( t reeModel) # toc ompareo utputi23

24dev. new()25data( c hurn) 26treeModel< C5.0( x = churnTrain [ ,20], y =churnTrain$churn)

27

28plot( t reeModel) # toc ompareo utputi4.Prédiction de la v ariableCreditabilitysur la base de test :

Algorithmes CAR T: 1#P redirel esd onneesd el ab aset este nu tilisantl "a rbreC ART 2result 5#M atriced ec onfusion6table( r esult, T est[ , 1])7

8#T auxd ep rediction9mean(r esult==Test[ , 1])-Algorithmes C5.0 :

1#P redirel esd onneesd el ab aset este nu tilisantl "a rbreC 5.0

2result2 5#M atriced ec onfusion6table( r esult2, T est[ , 1])7

8#T auxd ep rediction9mean(r esult2==Test[ , 1])?100Dernière mise à jour le 26 décembre 20185

quotesdbs_dbs2.pdfusesText_2

4#E ntropied el av ariableC ouleur5EntrCouleur=Entropy(Data [ ,3] , Data [ ,4] , base=2)16View( EntrCouleur )7#E ntropied el av ariablec lasse8EntrClasse=Entropy(Data [ ,4] , base=2)19View( EntrClasse )10#C alculd uG aind el av ariableC ouleur11GainCouleur=EntrClasseEntrCouleur12View( GainCouleur )L"entropie de la variableCouleurest 0,8113

2.Calcul de l"en tropiede la v ariableTaille:1#E ntropied el av ariablec lasse2EntrClasse=Entropy(Data [ ,4] , base=2)13View( EntrClasse )4#C alculd uG aind el av ariableT aille5GainTaille=EntrClasseEntrTaille6View( GainTaille )L"entropie de la variableTailleest 1

3.Le gain qui est defini par : 1#C alculd ug aind el av ariable" T aille" 2I Exercice 41.Installer et c hargerles bibliothè quesrpartetFSelector:1i n s t a l l. p ackages( "rpart", d ep=TRUE)2library( r part) 3i n s t a l l. p ackages( "FSelector")4library( F Selector) 2.Imp ortationdes deux base de données : irisetkyphosis1#I mporterl ab ased ed onnees" i r i s " 2data( i r i s ) 3 arbres suivants :1#A rbred ed ecisiond el ab ased ed onnees" i r i s " 2dev. new()3arbre = rpart ( i r i s$ Species~ P etal. L ength+ Petal. Width, method="c lass" , m insplit= 20,x val=81,d ata=ir i s ) test :1#Based " e ntrainenemt2Train Algorithmes CAR T: 1#A rbred ed ecisionC ART2library( r part) 3i n s t a l l. p ackages( "rpart. p lot")4library( r part. p lot) 5dev. new()6Arbre1= rpart ( Train$C reditability~. , d ata=T rain) 7prp(Arbre1 , extra=1)8t i t l e( "Arbred ed ecisionC artbased " e ntrainement")5}6Entropie< (4/8)?log( 4/8)(4/8)?log( 4/8)7GTaille

4#C hargerl ab ibliotheque5library( F Selector) 6

7weights< information . gain (Data$Class~Data$T aille+ D ata$Couleur, D ata, u nit= " log2")

Donc, puisque la fonction Gain égale à zéro, alors, la variable Taille ne constitue pas un bon prédicteur de la race. 4#I mporterl ab ased ed onnees" kyphosis"5data( k yphosis) 3.Les arbres de décisions des ensem blesde données son t:

1#A rbred ed ecisiond el ab ased ed onnees" i r i s " 2dev. new()3arbreIris = rpart ( i r i s$ Species~ . , m ethod="c lass" , minsplit =20, xval=81,d ata=ir i s )

4plot( a rbreIris, u niform=TRUE,m argin=0.1, m ain="Arbred edecision" i ris" " )

5text( a rbreIris, f ancy=TRUE,u se. n=TRUE,p retty=0,a ll=TRUE)

6#A rbred ed ecisiond el ab ased ed onnees" Kyphosis"7dev. new()8arbreKyphosis = rpart ( Kyphosis~ . , m ethod="c lass" , minsplit =20, xval=81,d ata=k yphosis)

9plot( a rbreKyphosis, u niform=TRUE,m argin=0.1, m ain="Arbreded ecision" k yphosis" " )

10text( a rbreKyphosis, f ancy=TRUE,u se. n=TRUE,p retty=0,a ll=TRUE)

Dernière mise à jour le 26 décembre 20182 4.Rapp ortde gain et gain p ourc haqueattribut : 1#C alculG ainr atione tG ainp ourl esa ttributs2print( "I r i s D atabase")3information . gain ( Species~., d ata=iris, u nit= " log2")4gain . ratio ( Species~ ., d ata=iris, u nit= " log2")5

6print( "kyphosisD atabase")7information . gain ( Kyphosis~., d ata=kyphosis, u nit= " log2")

8gain . ratio ( Kyphosis~ ., d ata=kyphosis, u nit= " log2")5.Les attributs qui on tplus d"imp ortancep ourla base de données

"iris" sont : P etal.Length

P etal.With

L"attribut qui a plus d"importance pour la base de données "kyphosis" est :Dernière mise à jour le 26 décembre 20183 -Start 6. Après élimin ationdes attributs non imp ortants,nous obtenons les 4plot( a rbre, u niform=TRUE,m argin=0.1, m ain="Arbred edecision" i ris" " )

5text( a rbre, f ancy=TRUE,u se. n=TRUE,p retty=0,a ll=TRUE)6

7#A rbred ed ecisiond el ab ased ed onnees" Kyphosis"8dev. new()9arbre = rpart ( Kyphosis~ S tart, m ethod="c lass" , m insplit=20, xval=81,d ata=k yphosis)

10plot( a rbre, u niform=TRUE,m argin=0.1, m ain="Arbred edecision" k yphosis" " )

11text( a rbre, f ancy=TRUE,u se. n=TRUE,p retty=0,a ll=TRUE)Exercice 4

1. Chargemen tda la base de données "CreditData.txt" en utilisan tR : 1#C hargerl ab ased ed onnees2Data

TRUE, sep =

2. Divisez la base de données en base d"appren tissageet en base de 1i n s t a l l. p ackages( "C50")2library( C50)3Train

14Arbre2< C5.0( x = ( kyphosis [ ,1]) , y = kyphosis$Kyphosis )

15summary(Arbre2)16plot( Arbre2)17

18dev. new()19data( c hurn) 20treeModel< C5.0( x = Train [ ,1], y = Train$Creditability )

21

22plot( t reeModel) # toc ompareo utputi23

24dev. new()25data( c hurn) 26treeModel< C5.0( x = churnTrain [ ,20], y =churnTrain$churn)

27

28plot( t reeModel) # toc ompareo utputi4.Prédiction de la v ariableCreditabilitysur la base de test :

Algorithmes CAR T: 1#P redirel esd onneesd el ab aset este nu tilisantl "a rbreC ART 2result

5#M atriced ec onfusion6table( r esult, T est[ , 1])7

8#T auxd ep rediction9mean(r esult==Test[ , 1])-Algorithmes C5.0 :

1#P redirel esd onneesd el ab aset este nu tilisantl "a rbreC 5.0

2result2

5#M atriced ec onfusion6table( r esult2, T est[ , 1])7

8#T auxd ep rediction9mean(r esult2==Test[ , 1])?100Dernière mise à jour le 26 décembre 20185

quotesdbs_dbs2.pdfusesText_2

[PDF] cours arbre de décision

[PDF] classification par arbre de décision

[PDF] arbre de décision exemple

[PDF] arbre de décision cart

[PDF] construire un arbre de décision

[PDF] arbre de décision définition

[PDF] dénombrement cours 1ere s

[PDF] apollon et daphné résumé

[PDF] apollon et daphné leur histoire

[PDF] expression etre nature

[PDF] tp mise en évidence d'une réaction d'oxydoréduction

[PDF] apollon et daphné peinture

[PDF] apollon et daphné le bernin

[PDF] tp chimie réaction d oxydoréduction