CHAÎNES DE MARKOV

CHAÎNES DE MARKOV

Les chaînes de Markov constituent un des exemples les plus Soit P la matrice d'une chaîne de Markov à espace d'états finis irréductible et apériodique.

Chaînes de Markov

Chaînes de Markov

Exemple. La marche aléatoire sur Z/NZ est récurrente irréductible. Plus généra- lement toute chaîne de Markov finie dont le graphe orienté est connexe est

Chapitre 2 - Chaines de Markov : compléments

Chapitre 2 - Chaines de Markov : compléments

Ainsi l'exemple de la chaıne {h

Chapitre I - Introduction aux chaines de Markov

Chapitre I - Introduction aux chaines de Markov

Montrer que Y = (Ynn ∈ N∗) est une chaıne de Markov `a valeurs dans E2. Donner sa matrice de transition

Cours de Tronc Commun Scientifique Recherche Opérationnelle

Cours de Tronc Commun Scientifique Recherche Opérationnelle

Exemple : π0 = (. 1 0. ) π1 = (. 0

Chaînes de Markov (et applications)

Chaînes de Markov (et applications)

Feb 22 2021 Mesure d'occupation a) Donner un exemple de graphe non-apériodique. b) On suppose le graphe apériodique. Soit x un point du graphe. Montrer ...

Chaînes de Markov : théorie et applications

Chaînes de Markov : théorie et applications

loi initiale de la chaîne de Markov (par exemple δx1 ) on a. C. ∑ i=1. Vxi Une chaîne de Markov irréductible est dite apériodique si sa période est h = 1 ...

chaines-Markov.pdf

chaines-Markov.pdf

Ici tous les états communiquent. La chaˆıne est irréductible. Exemple. P =

Classification des états dune chaîne de Markov

Classification des états dune chaîne de Markov

Par exemple s'il existe un état absorbant (fermé)

3 Mesures invariantes

3 Mesures invariantes

positive (on le savait : chaîne finie irréductible) et par exemple

Chapitre 2 - Chaines de Markov : compléments

Chapitre 2 - Chaines de Markov : compléments

Ainsi l'exemple de la cha?ne {h

IFT-3655 Modèles Stochastiques orange Chaînes de Markov en

IFT-3655 Modèles Stochastiques orange Chaînes de Markov en

Ici tous les états communiquent. La chaˆ?ne est irréductible. Exemple. P =

Chaînes de Markov et Processus markoviens de sauts. Applications

Chaînes de Markov et Processus markoviens de sauts. Applications

Exemple 2 (Modèle de diffusion d'Ehrenfest) On réparti N particules dans deux com- Définition 7 Une chaîne de Markov est dite irréductible si E est ...

CHAÎNES DE MARKOV

CHAÎNES DE MARKOV

Exemple 0. La marche aléatoire sur Z est irréductible (tous les états communiquent). Exemple 1. Considérons la chaîne de Markov dont l'ensemble des états

Chaînes de Markov.

Chaînes de Markov.

Soit (Xn)n?N une chaîne de Markov de matrice de transition P irréductible récurrente. Alors il existe une mesure ? strictement positive invariante

Classification des états de la Chaîne de Markov Classification des

Classification des états de la Chaîne de Markov Classification des

Classification des états de la Chaîne de. Markov. Exemple: Le processus est irréductible est ergodique et donc il admet une distribution stationnaire.

Cours de Tronc Commun Scientifique Recherche Opérationnelle

Cours de Tronc Commun Scientifique Recherche Opérationnelle

valuation de l'arête i ? j : pij . Une cha?ne de Markov peut être vue comme une marche aleatoire sur G

Chaînes de Markov

Chaînes de Markov

irréductible récurrente la mesure empirique et la loi marginale du pro- Exemple. On représente usuellement une chaîne de Markov d'espace d'états X par.

Chapitre I - Introduction aux chaines de Markov

Chapitre I - Introduction aux chaines de Markov

de Wright-Fisher voir l'exemple I.1.35 n'est pas irréductible. Exercice I.3. Soit X = (Xn

3 Mesures invariantes

3 Mesures invariantes

En particulier une chaîne de Markov finie irréductible admet toujours une mesure exemple

[PDF] Chaines de Markov : compléments

[PDF] Chaines de Markov : compléments

Une cha?ne de Markov est dite irréductible lorsque tous ses états communiquent c'est-`a-dire lorsque pour toute paire d'états (xixj) la probabilité d'aller

[PDF] CHAÎNES DE MARKOV - Institut de Mathématiques de Bordeaux

[PDF] CHAÎNES DE MARKOV - Institut de Mathématiques de Bordeaux

Les chaînes de Markov constituent un des exemples les plus simples de suites de La marche aléatoire sur Z est irréductible (tous les états communiquent)

[PDF] CHAÎNES DE MARKOV - ceremade

[PDF] CHAÎNES DE MARKOV - ceremade

5 3 4 Graphe associé à une chaîne de Markov homogène Le but de la théorie des probabilités est de fournir un modèle mathématique pour décrire les

[PDF] Chaînes de Markov

[PDF] Chaînes de Markov

Exemple La marche aléatoire sur Z/NZ est récurrente irréductible Plus généra- lement toute chaîne de Markov finie dont le graphe orienté est connexe est

[PDF] Chapitre 8 Chaˆ?nes de Markov - DI ENS

[PDF] Chapitre 8 Chaˆ?nes de Markov - DI ENS

Définition 8 1 6 S'il n'y a qu'une seule classe de communication la cha?ne sa matrice de transition et son graphe de transition sont dits irréductibles Page

[PDF] Chaînes de Markov (et applications)

[PDF] Chaînes de Markov (et applications)

22 fév 2021 · Exemples et définitions Idée : Une chaîne de Markov est une suite de variables aléatoires dans le temps ou conditionnel-

[PDF] Les cha?nes de Markov - Loria

[PDF] Les cha?nes de Markov - Loria

Une cha?ne de Markov est irréductible si chaque état est accessible `a partir de chaque autre état Autrement dit G est fortement connexe Sinon elle est dite

[PDF] Introduction aux chaines de Markov - CERMICS

[PDF] Introduction aux chaines de Markov - CERMICS

1 4 et la cha?ne de Markov de l'urne d'Ehrenfest de l'exemple I 1 38 sont irréductibles Une cha?ne possédant des états absorbants n'est pas irréductible (sauf

[PDF] chaines-Markovpdf - Université de Montréal

[PDF] chaines-Markovpdf - Université de Montréal

La chaˆ?ne est irreductible si tous les états communiquent (une seule classe d'équivalence) On peut représenter une chaˆ?ne de Markov `a espace d'états

[PDF] Chaînes de Markov - Institut Camille Jordan

[PDF] Chaînes de Markov - Institut Camille Jordan

Un exemple canonique de marche aléatoire sur un groupe est la marche aléatoire On peut donc parler d'une chaîne de Markov irréductible sur un ensemble S

Comment montrer qu'une chaîne de Markov est irréductible ?

Une chaîne de Markov est dite irréductible si K(x, y) > 0 pour tout couple x, y. Dans ce cas, soit la chaîne consiste en une seule classe d'états récurrents, soit la chaîne consiste seulement en états tous transitoires.Comment calculer la période d'une chaîne de Markov ?

Cela conduit au calcul suivant : P(X2 = s/X0 = m) = P(X2 = s/X1 = m) · P(X1 = m/X0 = m) + P(X2 = s/X1 = s) · P(X1 = s/X0 = m) = 0,15 · 0,0,55 + 0,15 · 0,1=0,0975. La cha?ne n'est pas périodique comme on peut le voir facilement sur son diagramme en points et fl`eches.Comment montrer qu'une suite est une chaîne de Markov ?

= P(Xn+1 = yXn = xn). Cette preuve permet de montrer rigoureusement que la marche aléatoire sur Zd est bien une chaîne de Markov. Dans le monde déterministe, cela revient à étudier les suites (xn)n?0 définies par ré- currence de la manière suivante : xn+1 = f(xn,n).- est indépendant de l'état de départ. Pour les chaînes ergodiques, on demande simplement que tout état soit atteignable depuis tout autre, mais le nombre de pas n'est pas nécessairement fixé.

1 16

1 16 Classification des états de la Chaîne de

Markov

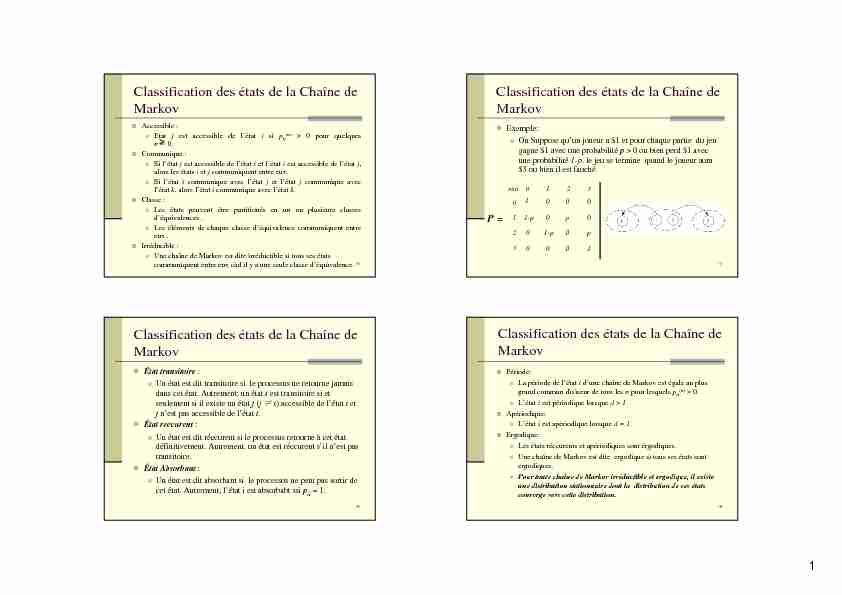

Accessible :

Etatjest accessible de l'étatisip

ij(n) > 0 pour quelques n˻0.Communique :

Si l'étatjest accessible de l'étatiet l'étatiest accessible de l'étatj, alors les étatsiet jcommuniquent entre eux. Si l'étaticommunique avec l'étatjet l'étatjcommunique avec l'étatk, alors l'étaticommunique avec l'étatk.Classe :

Les états peuvent être partitionés en un ou plusieurs classes d'équivalences . Les éléments de chaque classe d'équivalence communiquent entre eux .Irréducible :

Une chaîne de Markov est dite irréductible si tous ses états communiquent entre eux càd il y a une seule classe d'équivalence. 17Classification des états de la Chaîne de

Markov

Exemple:

On Suppose qu'un joueur a $1 et pour chaque partie du jeu gagne $1 avec une probabilitép> 0 ou bien perd $1 avec une probabilité1-p. le jeu se termine quand le joueur aura $3 ou bien il est fauché. P = 100 01-p 0 p 0

01-p0 p

000 1état0123

0 1 2 3 18Classification des états de la Chaîne de

Markov

État transitoire:

Un état est dit transitoire si le processus ne retourne jamais dans cet état. Autrement; un étatiest transitoire si et seulement si il existe un étatj(j i) accessible de l'étatiet jn'est pas accessible de l'étati.État reccurent:

Un état est dit réccurent si le processus retourne à cet état définitivement. Autrement, un état est réccurent s'il n'est pas transitoire.État Absorbant:

Un état est dit absorbant si le processus ne peut pas sortir de cet état. Autrement, l'état i est absorbabt ssip ii = 1.19Classification des états de la Chaîne de

Markov

Période:

La période de l'état id'une chaîne de Markov est égale au plus grand commun diviseur de tous les npour lesquels p ii(n) > 0.L'état iest périodique lorsque d> 1.

Apériodique:

L'état iest apériodique lorsque d = 1.

Ergodique:

Les états réccurents et apériodiques sont érgodiques. Une chaîne de Markov est dite ergodique si tous ses états sont ergodiques. Pour toute chaîne de Markov irréductible et ergodique, il existe une distribution stationnaire dont la distribution de ses états converge vers cette distribution. 2 20Classification des états de la Chaîne de

MarkovExemple:

Le processus est irréductible est ergodique et donc il admet une distribution stationnaireP =0.080 0.184 0.368 0.368

0.632 0.368 0.000 0.000

0.264 0.368 0.368 0.000

0.080 0.184 0.368 0.368état

01230 1 2 3 21

Premier temps de passage

Premier temps de passage :

Le premier temps de passage de l'étatiàl'étatjest le nombre de transitions effectuées par le processus en allant de l'étatiàl'étatjpour la première fois.Temps de réccurence:

Quandj = i, Le premier temps de retour à l'étati.Example :

X 0 = 3, X 1 = 2, X 2 = 1, X 3 = 0, X 4 = 3, X 5 = 1 Le premier temps de passage de l'état 3 à l'état 1 est 2 semaines. Le temps de réccurence de l'état 3 est 4 semaines. 22Premier temps de passage

: La probabilité du premier temps de passage de l'étatiàl'étatjen nétapes.Relations réccurentes :

()n ij f (2) (1) ij ik kj kj f pf (1) (1) ij ij ij f pp () ( 1)nn ij ik kj kj fpf 23Premier temps de passage

Retour à l'exemple:

f 30(1)= p 30

= 0.080 f 30(2)

= p 31

f 10(1) + p 32

f 20(1) + p 33

f 30(1)

= 0.184 (0.632) + 0.368 (0.264) + 0.368 (0.080) = 0.243

Somme :

Temps moyen de premier passage :

1 1 n ij n f d 1 11 si 1 si 1 n ij n ij nn ij ij nn f m nf f f 3 24() (1) (2) () () 11 2 ... nnn ij ij ij ij ij ij nTnT mnfff f f 1 nn ij ik kj nT k j nT f pf 21

nn ij ik kj

TnT kj TnT

f pf 1n ij ij ik kj nkj mf pmPremier temps de passage

25Premier temps de passage

Exemple

m 30= 1 + p 31

m 10 + p 32

m 20 + p 33

m 30

m 20 = 1 + p 21

m 10 + p 22

m 20 + p 23

m 30

m 10 = 1 + p 11 m 10 + p 12 m 20 + p 13 m 30

m 10 = 1.58 weeks, m 20 = 2.51 weeks, m 30

= 3.50 weeks 1 ij ik kj kj mpm 26

Les États Absorbants

Les états absorbants :

Un étatkest dit un état absorbant sip

kk = 1, càd si la chaîne visite l'étatkelle y restera.Exemple :

On suppose que deux joueurs (A et B), chacun a $2, se mette d'accord pour que le le jeu se termine lorsquequotesdbs_dbs29.pdfusesText_35[PDF] chaine énergétique barrage hydraulique

[PDF] chaine énergétique d'une éolienne

[PDF] exercice corrigé centrale hydraulique

[PDF] chaine énergétique centrale thermique

[PDF] chaine énergétique pile

[PDF] chaine énergétique exercices

[PDF] chaine énergétique éolienne

[PDF] chaine énergétique panneau solaire

[PDF] chaine energetique definition

[PDF] chaine énergétique exemple

[PDF] cours de logistique de distribution pdf

[PDF] introduction logistique

[PDF] cours management de la chaine logistique pdf

[PDF] logistique et supply chain management