Quelle est la « bonne » formule de lécart-type

Quelle est la « bonne » formule de lécart-type

Par définition l'écart-type est la moyenne quadratique des écarts à la moyenne x . Le biais est plus simple à exprimer dans le cas de la variance.

Première ES - Statistiques descriptives - Variance et écart type

Première ES - Statistiques descriptives - Variance et écart type

Variance et écart type. I) Rappel : la moyenne (caractéristique de position ). 1) Définition. Soit la série statistique définie dans le tableau suivant :.

Document Cofrac SH GTA 04

Document Cofrac SH GTA 04

11.2 Processus simple – méthode qualitative : détermination des groupes étant égale au triple de l'écart-type obtenu à partir du signal correspondant à ...

MODELES LINEAIRES

MODELES LINEAIRES

5.1.2 Le modèle de régression linéaire simple . 8.2.3 Variance empirique et écart-type empirique . ... Une autre définition de.

Régression linéaire simple

Régression linéaire simple

(4) écart-type de ? ?1 : sb1. 3.2 Qualité d'ajustement. Il est d'usage de décomposer les sommes de carrés des écarts à la moyenne.

MESURES ET INCERTITUDES

MESURES ET INCERTITUDES

On distingue deux types d'erreurs de mesures. L'incertitude associée est une incertitude de répétabilité dite de type A. ... l'écart-type.

Cours de statistique descriptive - Archive ouverte HAL

Cours de statistique descriptive - Archive ouverte HAL

2 août 2016 à calculer des caractéristiques de dispersion (écart-type ... C'est la plus simple et la communément utilisée et ce

Guide de validation des méthodes danalyses

Guide de validation des méthodes danalyses

28 oct. 2015 Note 1 : Le biais absolu l'écart-type de répétabilité

Première S - Statistiques descriptives - Variance et écart type

Première S - Statistiques descriptives - Variance et écart type

Autre formule pour calculer la variance : V = ?. ?. Exemple : Démonstration : En reprenant la formule de définition : V = ?.

LES TESTS DHYPOTHÈSE

LES TESTS DHYPOTHÈSE

DÉFINITION DES CONCEPTS UTILES A L'ÉLABORATION DES. TESTS D'HYPOTHÈSE. Hypothèse statistique X1 suit alors une loi normale de moyenne m1 et d'écart-type.

Quelle est la définition de l'écart type?

En mathématiques, l’ écart type (aussi orthographié écart-type) est une mesure de la dispersion des valeurs d'un échantillon statistique ou d'une distribution de probabilité. Il est défini comme la racine carrée de la variance ou, de manière équivalente, comme la moyenne quadratique des écarts par rapport à la moyenne.

Comment calculer un écart type ?

diviser la somme des carrés par l'effectif total de l'échantillon moins 1 (n - 1). Enfin, le calcul de la racine carrée de la variance de l'échantillon va permettre d'obtenir l'écart type. Cela consiste donc à prendre la valeur de la variance et de calculer sa racine carrée. Voici un exemple pour bien comprendre comme calculer un écart type.

Quelle est la limite de l'écart type?

Les écarts par rapport à la moyenne sont maintenant de 0 m, 0,20 m, 0,20 m et 0 m, respectivement. Ainsi l'écart type est la moyenne quadratique de ces écarts, c'est-à-dire , qui vaut environ 0,14 m .

Comment calculer la variance et l’écart type ?

La variance et l’écart type permettent de mesurer la « dispersion » des valeurs de la série autour de la moyenne. Si les valeurs de la série possèdent une unité, l’écart type s’exprime dans la même unité. Autre formule pour calculer la variance : V =. Ú bz.

Past day

Régression linéaire simple

Régression linéaire simple

Résumé

Ce chapitre introduit la notion de modèle linéaire par la version la plus élémentaire : expliquerYpar une fonction affine deX. Après avoir expliciter les hypothèses nécessaires et les termes du modèle, les notions d"estimation des paramètres du modèle, de prévision par intervalle de confiance, la signification des tests d"hypothèse sont discutées. Enfin une attention particulière est faite aux outils de diagnostics disponibles : valeurs influentes, et surtout graphe des résidus.Retour au

plan du cour s1 Introduction

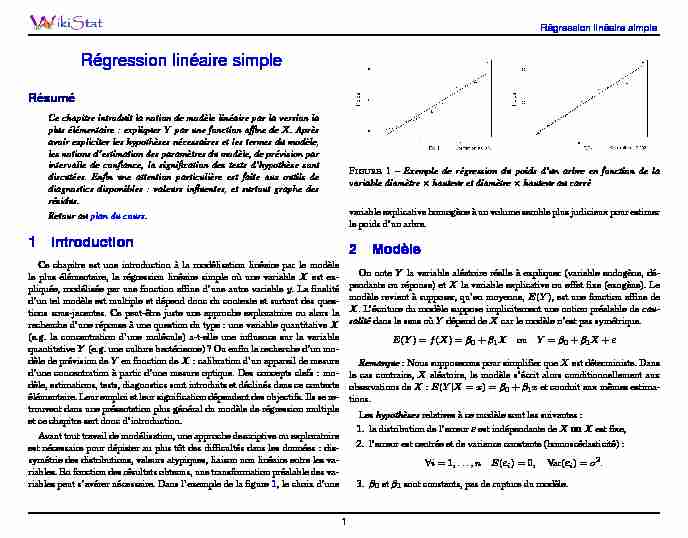

Ce chapitre est une introduction à la modélisation linéaire par le modèle le plus élémentaire, la régression linéaire simple où une variableXest ex- pliquée, modélisée par une fonction affine d"une autre variabley. La finalité d"un tel modèle est multiple et dépend donc du contexte et surtout des ques- tions sous-jacentes. Ce peut-être juste une approche exploratoire ou alors la recherche d"une réponse à une question du type : une variable quantitativeX (e.g. la concentration d"une molécule) a-t-elle une influence sur la variable quantitativeY(e.g. une culture bactérienne)? Ou enfin la recherche d"un mo- dèle de prévision deYen fonction deX: calibration d"un appareil de mesure d"une concentration à partir d"une mesure optique. Des concepts clefs : mo- dèle, estimations, tests, diagnostics sont introduits et déclinés dans ce contexte élémentaire. Leur emploi et leur signification dépendent des objectifs. Ils se re- trouvent dans une présentation plus général du modèle de régression multiple et ce chapitre sert donc d"introduction. Avant tout travail de modélisation, une approche descriptive ou exploratoire est nécessaire pour dépister au plus tôt des difficultés dans les données : dis- symétrie des distributions, valeurs atypiques, liaison non linéaire entre les va- riables. En fonction des résultats obtenus, une transformation préalable des va- riables peut s"avérer nécessaire. Dans l"exemple de la figure 1 , le choix d"uneFIGURE1 -Exemple de régression du poids d"un arbre en fonction de la variable diamètrehauteur et diamètrehauteur au carré variable explicative homogène à un volume semble plus judicieux pour estimer le poids d"un arbre.2 Modèle

On noteYla variable aléatoire réelle à expliquer (variable endogène, dé- pendante ou réponse) etXla variable explicative ou effet fixe (exogène). Le modèle revient à supposer, qu"en moyenne,E(Y), est une fonction affine de X. L"écriture du modèle suppose implicitement une notion préalable decau- salitédans le sens oùYdépend deXcar le modèle n"est pas symétrique.E(Y) =f(X) =0+1XouY=0+1X+"

Remarque: Nous supposerons pour simplifier queXest déterministe. Dans le cas contraire,Xaléatoire, le modèle s"écrit alors conditionnellement aux observations deX:E(YjX=x) =0+1xet conduit aux mêmes estima- tions. Leshypothèsesrelatives à ce modèle sont les suivantes : 1. la distrib utionde l"erreur "est indépendante deXouXest fixe, 2. l"erreur est centrée et de v arianceconstante (homoscédasticité) :8i= 1;:::;n E("i) = 0;Var("i) =2:

3.0et1sont constants, pas de rupture du modèle.1

Régression linéaire simple

4. Hypothèse complémentaire pour les inférences : " N(0;2).3 Estimation

3.1 Paramètres

L"estimation des paramètres0;1;2est obtenue en maximisant la vrai- semblance, sous l"hypothèse que les erreurs sont gaussiennes, ou encore par minimisation de la somme des carrés des écarts entre observations et modèle (moindres carrés). Les deux approches conduisent aux mêmes estimation tan- dis que le maximum de vraisemblance induit de meilleure propriétés des es- timateurs. Pour une séquence d"observationsf(xi;yi)i= 1:::;ng, le critère des moindres carrés s"écrit : min 0;1n X i=1(yi01xi)2:On pose :

x=1n n X i=1x i;y=1n n X i=1y i; s2x=1n1n

X i=1(xix)2; s2y=1n1n X i=1(yiy)2; s xy=1n1n X i=1(xix)(yiy); r=sxys xsy;Les moindres carrés sont minimisés par :

b1=sxys

2x; b0= yb1x

qui sont les réalisations des estimateurs c0etc1. On montre que ces estima- teurs sans biais et de variance minimum parmi les estimateurs fonctions li- néaires desyi(resp. parmi tous les estimateurs dans le cas gaussien). À chaque valeur deXcorrespond la valeurestiméeou ajustée deY: byi=b0+b1xi;lesrésiduscalculés ou estimés sont : e i=yibyi: La variance2est estimée par la variation résiduelle : s2=1n2n

X i=1e 2i: Exemple : Analyse de régression : Poids en fonction de D2xHL"équation de régression est

Poids = 0,0200 + 0,00829 D2xH

Régresseur Coef Er-T coef T P

Constante 0,01999(1) 0,01365(3) 1,46 0,160

D2xH 0,0082897(2) 0,0002390(4) 34,68 0,000(1)b0

(2)b1 (3) écart-type de c0:sb0 (4) écart-type dec1:sb13.2 Qualité d"ajustement Il est d"usage de décomposer les sommes de carrés des écarts à la moyenne sous la forme ci-dessous; les notations sont celles de la plupart des logiciels :Total sum of squaresSST= (n1)s2y;

Regression sum of squaresSSR= (n1)s2

xys 2x;Error sum of squaresSSE= (n2)s2;

et on vérifie : SST=SSR+SSE. On appellecoefficient de déterminationla quantité R2=r2=s2xys

2xs2y= 1n2n1s

2s2y=SSRSST

qui exprime le rapport entre la variance expliquée par le modèle et la variance totale.2Régression linéaire simple

Exemple : Analyse de régression : Poids en fonction de D2xHAnalyse de variance

Source DL SC CM F P

Régression 1(1) 1,8108(2) 1,8108(5) 1202,89 0,000Erreur résid 18 0,0271(3) 0,0015(6)

Total 19 1,8379(4)

S = 0,03880(7) R-carré = 98,5%(8) R-carré (ajust) = 98,4%(1) degrés de liberté de la loi de Fisher du test global (H0:1= 0)

(2) SSR (3) SSE ou déviance (4) SST=SSE+SSR (5) SSR/DF (6)s2=MSE=SSE/DF est l"estimation de2" (7)s=racine de MSE (8) Coefficient de déterminationR2ou carré du coefficient de corrélation.4 Inférence4.1 Loi des paramètres

Les estimateurs

c0etc1sont des variables aléatoires réelles de matrice de covariance : 2"1n +x2(n1)s2xx(n1)s2xx(n1)s2x1(n1)s2x# qui est estimée en remplaçant2par son estimations2. Sous l"hypothèse que les résidus sont gaussiens, on montre que (n2)S222(n2)

et donc que les statistiques c00), s1n +x2(n1)s2x 1=2 et(c11), s1(n1)s2x 1=2 suivent des lois de Student à(n2)degrés de liberté. Ceci permet de tes-ter l"hypothèse de nullité d"un de ces paramètres ainsi que de construire lesintervalles de confiance :

b0t=2;(n2)s1n

+x2(n1)s2x 1=2 b1t=2;(n2)s1(n1)s2x

1=2 Attention: une inférence conjointe sur0et1ne peut être obtenue en consi- dérant séparément les intervalles de confiance. La région de confiance est en effet une ellipse d"équation : n(b00)2+2(b00)(b11)nX i=1x i+(b11)2nX i=1x2i= 2s2F;2;(n2)

qui est inclue dans le rectangle défini par les intervalles. Un grande part des valeurs du couple(0;1)est donc exclue de la région de confiance et ce d"autant plus queb0etb1sont corrélés.Sous l"hypothèse :1= 0, la statistique

(n2)R21R2= (n2)SSRSSE suit une distribution de FisherF1;(n2). Cette statistique est le carré de la sta- tistique de Student correspondant à la même hypothèse.4.2 Prévision par intervalle de confiance

Connaissant une valeurx0, on définit deuxintervalles de confiance de pré- visionà partir de la valeur préditeby0=b0+b1x0. Le premier encadreE(Y) sachantX=x0; le deuxième, qui encadreby0est plus grand car il tient compte de la variance totale :2+Var(by0): by0t=2;(n2)s1n +(x0x)2(n1)s2x 1=2 by0t=2;(n2)s 1 +1n +(x0x)2(n1)s2x 1=2 Les logiciels proposent également unebande de confianceentre deux arcs d"hyperboles pour la droite de régression. À chaque point(b0;b1)de l"ellipse3Régression linéaire simple

ces droites sont comprises entre les bornes : bysqF1;(n2)1n

+(xx)2(n1)s2x 1=2 Ceci signifie que cette bande recouvre la "vraie" ligne avec une probabilité1. Elle est plus grande que celle associée aux intervalles de confiance des

E(Y). Attention: la prévision par intervalle n"est justifiée que pour des observa- tions appartenant à la population échantillonnée et à condition que les hypo- thèses : linéarité, erreurs i.i.d., (normalité), homoscédasticité, soient valides.Éviter les extrapolations.

4.3 Tests d"hypothèse

Les tests précédents prennent une signification particulière avec un objectif "explicatif";désigne le niveau des tests, souvent= 5%. Comme pour tous les tests usuels de comparaison d"échantillon, les logiciels fournissent les probabilités critiques ouP-valeurs qui, en pratique, sont comparées avec le seuil prédéterminé. Le test de Fisher s"intéresse à la significativité globale d"un modèle. Dans le cas de la régression simple, seul le paramètre1est concerné :F= (n2)R21R2= (n2)SSRSSE

suit une loi de Fisher à(1;n2)degrés de liberté. L"hypothèseH0:1= 0, est rejetée siF > f1;n2;1=2ou si laP-valeur associée est inférieure à. Plus précisément, l"hypothèseH0:1= 0répond aussi à la question de l"influence deXsurY. La réponse est négative siH0est acceptée : la pente de la droite de régression est nulle, le nuage de point est réparti sans structure linéaire significative. La réponse est positive lorsque le test est significatif et donc l"hypothèse rejetée. Ce paramètre suit une loi de Student etH0rejetée lorsquet1=jb1js b1> tn2;1=2ou si laP-valeur associée est inférieure à. Ce test est strictement équivalent au test de Fisher précédent, il conduit à la mêmeP-valeur.Enfin, le test de l"hypothèseH0:0= 0qui signifie : "la droite passe par l"origine", a un intérêt limité à des situations très particulières comme la calibration du "zéro" d"un appareil de mesure. Elle est rejetée sit0=jb0js b0> t n2;1=25 Influence

tribution gaussienne douteuse, est très sensible à des observations atypiques, hors "norme" (outliers) c"est-à-dire qui présentent des valeurs trop singulières. L"étude descriptive initiale permet sans doute déjà d"en repérer mais c"est in- suffisant. Un diagnostic doit être établi dans le cadre spécifique du modèle recherché afin d"identifier les observationsinfluentesc"est-à-dire celles dont une faible variation du couple(xi;yi)induisent une modification importante des caractéristiques du modèle. Ces observations repérées, il n"y a pas de remède universel : supprimer un valeur aberrante, corriger une erreur de mesure, construire une estimation ro- buste (en normeL1), ne rien faire..., cela dépend du contexte et doit être négocié avec le commanditaire de l"étude.5.1 Effet levier

Une première indication est donnée par l"éloignement dexipar rapport à la des observations : byi=b0+b1xi=nX j=1h ijyjavechij=1n +(xix)(xjx)P n j=1(xjx)2; en notantHla matrice (hat matrix) deshijceci s"exprime encore matricielle- ment : b y=Hy: Les éléments diagonauxhiide cette matrice mesurent ainsi l"impact ou l"im- portance du rôle que joueyidans l"estimation debyi.5.2 Résidus et PRESS

Différents types de résidus sont définis afin d"affiner leurs propriétés. 4Régression linéaire simple

Résidus :ei=yibyi

Résidus

(i):e(i)i=yidy(i)i=ei1hiioùdy(i)iest la prévision deyicalculée sans laième observation(xi;yi).

Ce type de résidu conduit à la définition du PRESS (predicted residual sum of squares) dit de Allen :PRESS=1n

n X i=1e2(i)i=1n

n X i=1 ei1hii 2 C"est une estimation sans biais de la qualité de prévision d"un modèle car une même observation n"est pas utilisée, à la fois, pour estimer le mo- dèle et l"erreur de prévision. Le PRESS est très utile pour comparer les qualités prédictives de plusieurs modèles. Ce point important sera déve- loppé dans le cas du modèle linéaire multiple : le coefficientR2permet de comparer les qualités d"ajustement mais la meilleure prévision n"est pas nécessairement fournie par un modèle deR2maximum. Le PRESS encore appeléleave one out cross validation (loo CV)est plus pertinent pour atteindre cet objectif.Remarquerque dans le cas particulier du mo- et des termes diagonauxhiide la matriceH. Pour d"autres modèles, le calcul du PRESS nécessite l"estimation, éventuellement coûteuse, den modèles. Résidus standardisés :Même si l"hypothèse d"homoscédasticité est vérifiée, ceux-ci n"ont pas la même variance :E(ei) = 0et Var(ei) =2(1hii). Il est donc d"usage d"en calculer des versionsstandardiséesafin de les rendre comparables : r i=eis p1hii: Résidus studentisés :La standardisation ("interne") dépend deeidans le cal- cul desestimation de Var(ei). Une estimation non biaisée de cette va- riance est basée sur s 2(i)= (n2)s2e2i1hii =(n3) qui ne tient pas compte de laième observation. On définit alors les résidus studentiséspar : t i=eis (i)p1hii:Sous hypothèse de normalité, on montre que ces résidus suivent une loi de Student à(n3)degrés de liberté. Il est ainsi possible de construire un test afin tester la présence d"uneobser- vation atypique ou de plusieurs en utilisant l"inégalité de Bonferroni. Plus concrètement, en pratique, les résidus studentisés sont comparés aux bornes 2.6 Diagnostics

6.1 Distance de Cook

Les deux critères précédents contribuent à déceler des observations poten- tiellement influentes par leur éloignement àxou la taille des résidus. Ces in- formations sont synthétisées dans des critères évaluant directement l"influence d"une observation sur certains paramètres : les prévisionsbyi, les paramètres b0;b1, le déterminant de la matrice de covariance des estimateurs. Tous ces

indicateurs proposent de comparer un paramètre estimé sans lai-ème observa- tion et ce même paramètre estimé avec toutes les observations. Le plus couramment utilisé est la distance de Cook : D i=P n j=1(dy(i)jbyj)22s2=hii2(1hii)r2ipouri= 1;:::;n qui mesure donc l"influence d"une observation sur l"ensemble des prévisions en prenant en compte effet levier et importance des résidus. La stratégie de détection consiste le plus souvent à repérer les points aty- piques en comparant les distances de Cook avec la valeur1puis à expliquer cette influence en considérant, pour ces observations, leur résidu ainsi que leur effet levier.6.2 Graphe des résidus

Attention: la présentation "pédagogique" des concepts de la régression li- néaire ne doit pas faire négliger l"étape de diagnostic des résidus. Concrète- ment, le graphe des résidus est la première chose à consulter après l"estima- tion d"un modèle linéaire. L"appréciation de sa forme, même si celle-ci reste "subjective", renseigne précisément sur la validité des hypothèses implicites 5Régression linéaire simple

FIGURE2 -Les résidus (à gauche) de la régression du poids en fonction du produit (diamètrehauteur) montre clairement un problème de linéarité. La transformation de la variable diamètre (carré) améliore ce diagnostic mais soulève (à droite) une problème d"hétéroscédasticité du modèle dont surtout celle de linéarité et celle d"homoscédasticité. Dans le cas contraire, toutes les décisions issues de tests et les intervalles de confiances n"ont plus de légitimité. Si certaines des hypothèses ne sont pas vérifiées, des mesures s"imposent comme la recherche de transformation des variables. L"homoscédasticité et la linéarité du modèle sont évalués par un graphique des résidus studentisés ou non :(xi;ti)qui doit se disperser "normalement" de part et d"autre de l"axey= 0: symétriquement et sans forme particulière. Des formes d""entonnoir", ou de "diabolo" du nuage font suspecter une hété- roscédasticité des résidus, celle d"une "banane" indique une possible relation non linéaire entreYetX. Même si cette hypothèse est moins sensible, le modèle est robuste surtout en cas de grand échantillon, il est sage de vérifier la normalité des résidus en étudiant leur distribution par exemple par une simple droite de Henri. Enfin l"auto-corrélation des résidus dans le cas par exemple où la variable explicative est le temps pose également des problèmes. Une modélisation de type série chronologique (ARMA, SARIMA) des résidus serait à tester.7 ExemplesFIGURE3 - Distribution des variables revenus et nombre d"appartementsFIGURE4 -Les résidus de la régression du revenu sur le nombre d"apparte-

ments (à gauche) met nettement en évidence un problème d"hétéroscédasticité; problème résolu (à droite) par des transformations des variables.7.1 Revenu fonction du nombre d"appartements

La variableYest le revenu d"un immeuble exprimé en fonction de la va- riablex, nombre d"appartement;47observations sont disponibles. L"erreur naïve consiste à se précipiter sur le premier modèle venu. Les résultats numé- riques ci-dessous sont satisfaisants, le modèle est significatif avec une qualité correcte d"ajustement (R2proche de 0,8). Maisle graphique des résidus (figure4 ) est nettement moins sympathique. Le statisticien amateur est allé trop vite, il a sauté l"étape descriptive des va- riables. Les diagrammes boites (figure 3 )montrent des distributions très dis- symétriques, une transformation par la fonction logarithme dégrade certes un peu l"ajustement mais améliore considérable la dispersion des résidus. Atten- tion, leR2n"est surtout pas le premier critère à regarder pour comparer des modèles. 6Régression linéaire simple

Regression Analysis: Revenu versus Nb_appart

The regression equation is

Revenu = - 4872 + 2351 Nb_appart

Predictor Coef SE Coef T P

Constant -4872 10655 -0,46 0,650

Nb_appart 2350,7 183,8 12,79 0,000

S = 51240,8 R-Sq = 78,4% R-Sq(adj) = 77,9%

Analysis of Variance

Source DF SS MS F P

Regression 1 4,29512E+11 4,29512E+11 163,59 0,000

Residual Error 45 1,18153E+11 2625616822

Total 46 5,47665E+11

Regression Analysis: LRevenu versus LNb_appart

The regression equation is

LRevenu = 6,87 + 1,19 LNb_appart

Predictor Coef SE Coef T P

Constant 6,8678 0,3332 20,61 0,000

LNb_appart 1,18863 0,09593 12,39 0,000

S = 0,496742 R-Sq = 77,3% R-Sq(adj) = 76,8%

Analysis of Variance

Source DF SS MS F P

Regression 1 37,886 37,886 153,54 0,000

quotesdbs_dbs31.pdfusesText_37[PDF] que mesure l'écart type en statistique descriptive

[PDF] de l arbre en pour sa hauteur

[PDF] fabriquer un dendrometre

[PDF] propriété bissectrice

[PDF] fonctions du monologue

[PDF] rôle des médias en démocratie

[PDF] comment fabriquer une imprimante 3d

[PDF] l'impression 3d pour les nuls

[PDF] imprimante 3d ? fabriquer soi-même

[PDF] fabriquer imprimante 3d arduino

[PDF] média et opinion publique en france depuis l'affaire dreyfus

[PDF] medias et opinion publique en france depuis l affaire dreyfus conclusion

[PDF] phrase d accroche media et opinion publique

[PDF] socialisme communisme et syndicalisme en allemagne depuis 1875