3 Mesures invariantes

3 Mesures invariantes

Une chaîne de. Markov réversible a même loi sous la probabilité stationnaire

1 Définition

1 Définition

Si (Xn)n est une chaîne de Markov de loi initiale µ et de matrice de transition P alors Markov réversible a même loi

Chapitre 8 Chaˆ?nes de Markov

Chapitre 8 Chaˆ?nes de Markov

Définition 8.1.3 On appelle réversible toute cha?ne de Markov de distribution initiale ? (une distribution stationnaire) positive telle que pour tout i

Modèles et algorithmes de réseaux Chaînes de Markov – reversibilité

Modèles et algorithmes de réseaux Chaînes de Markov – reversibilité

Soit 1Xtlt?0 une cha?ne de Markov avec l'espace d'états S et la matrice de transition P et la distribution stationnaire ? reversible. Si X0 ? ? alors pour

THÉOR`EMES LIMITES Master MIMSE Bordeaux On consid`ere Xn

THÉOR`EMES LIMITES Master MIMSE Bordeaux On consid`ere Xn

Une cha?ne de Markov n'admet pas forcément de mesure reversible mais si c'est le cas il est facile de trouver les mesures reversible pour une chaine de. Markov

Chaînes de Markov.

Chaînes de Markov.

Une chaîne de Markov de distribution initiale ? et matrice de transition Soit (Xn)n?N chaîne de Markov (µ

Chaˆ?nes de Markov

Chaˆ?nes de Markov

2 janv. 2010 2.6 Cha?nes de Markov réversibles . ... de taille N. Une cha?ne de Markov sur X de matrice de transition P est une suite. (X0X1

Chapitre I - Introduction aux chaines de Markov

Chapitre I - Introduction aux chaines de Markov

Définition I.1.11. On dit qu'une cha?ne de Markov de matrice de transition P ou plus simplement la matrice P

Chapitre 4 Chaˆ?nes de Markov finies.

Chapitre 4 Chaˆ?nes de Markov finies.

7 mai 2004 Ceci redémontre l'existence d'un vecteur propre `a coefficients positifs. 2.2 Matrice adjointe chaˆ?nes réversibles. Nous avons déj`a introduit ...

Feuille dexercices 3

Feuille dexercices 3

Mesures réversibles I. Soit P la matrice de transition d'une chaîne de Markov sur un espace d'états fini ou dénombrable. Une mesure positive ? est dite

[PDF] Chaˆ?nes de Markov – reversibilité - DI ENS

[PDF] Chaˆ?nes de Markov – reversibilité - DI ENS

Soit 1Xtlt?0 une cha?ne de Markov avec l'espace d'états S et la matrice de transition P et la distribution stationnaire ? reversible Si X0 ? ? alors pour

[PDF] Chapitre 8 Chaˆ?nes de Markov - DI ENS

[PDF] Chapitre 8 Chaˆ?nes de Markov - DI ENS

Définition 8 1 3 On appelle réversible toute cha?ne de Markov de distribution initiale ? (une distribution stationnaire) positive telle que pour tout i

[PDF] CHAÎNES DE MARKOV - ceremade

[PDF] CHAÎNES DE MARKOV - ceremade

5 3 4 Graphe associé à une chaîne de Markov homogène 8 1 Mesures stationnaires et réversibles large/proba09/ENSmarkov pdf 2009

[PDF] 1 Définition

[PDF] 1 Définition

Une chaîne de Markov réversible a même loi sous la probabilité stationnaire lorsque l'on retourne le temps Des parallèles avec l'étude des réseaux

[PDF] Chaînes de Markov : théorie et applications

[PDF] Chaînes de Markov : théorie et applications

matrice stochastique sur X Une chaîne de Markov de matrice de transition P est une trajectoire probabilité réversible pour cette chaîne de Markov

[PDF] Chaînes de Markov

[PDF] Chaînes de Markov

Une chaîne de Markov est un processus aléatoire (Xn)n2N réversible donc invariante sur N pour la matrice de transition de (Xn)n2N qui sera de

[PDF] Chaînes de Markov - Institut Camille Jordan

[PDF] Chaînes de Markov - Institut Camille Jordan

5 6 3 Le cas réversible On dit alors que (Xn)n?0 est une chaîne de Markov de loi initiale ? et de famille de noyaux de transition (pn(··))n?0

[PDF] Partie III: chaînes de Markov - Université Lyon 1

[PDF] Partie III: chaînes de Markov - Université Lyon 1

4 mai 2020 · (Xn)n?0 est une chaîne de Markov (noté CM) de matrice de est une probabilité réversible (donc invariante) ~jflegall/IPPA2 pdf

[PDF] Introduction aux chaines de Markov - CERMICS

[PDF] Introduction aux chaines de Markov - CERMICS

Définition I 1 11 On dit qu'une cha?ne de Markov de matrice de transition P ou plus simplement la matrice P est réversible par rapport `a la probabilité

[PDF] Chaînes de Markov (et applications)

[PDF] Chaînes de Markov (et applications)

22 fév 2021 · Soit Q la matrice de transition d'une chaîne de Markov homogène plus µ est une distribution la chaîne de Markov est dite “réversible”

TH

TH EOREMES LIMITES

MICHEL BONNEFONT

Master MIMSE Bordeaux

On considereXnune cha^ne de Markov homogene sur un espace d'etatsEdenombrable et de matrice de transitionP. Pourx2E, siX0=x, on notex= inffp1 : X p=xgle temps de retour enx.1.Mesures invariantes

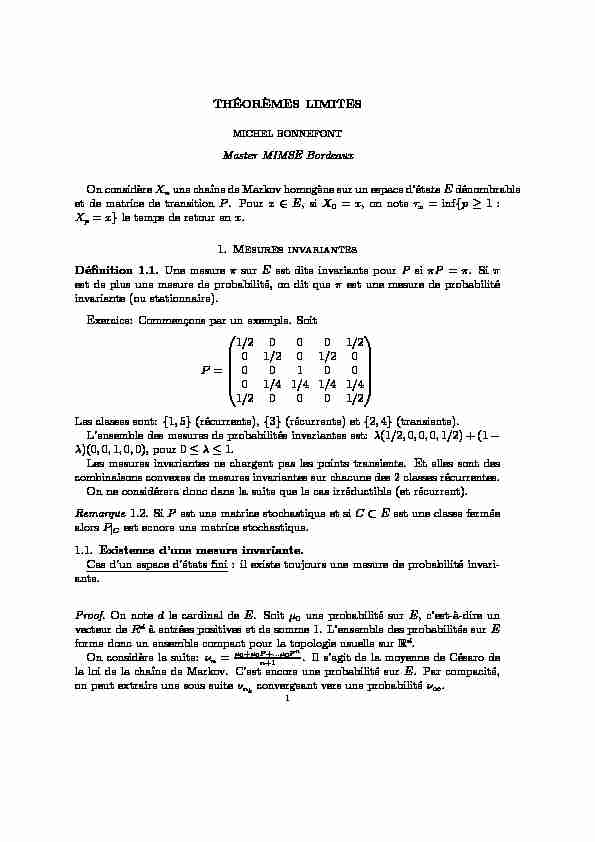

Denition 1.1.Une mesuresurEest dite invariante pourPsiP=. Si est de plus une mesure de probabilite, on dit queest une mesure de probabilite invariante (ou stationnaire).Exercice: Commencons par un exemple. Soit

P=0 BBBB@1=2 0 0 0 1=2

0 1=2 0 1=2 0

0 0 1 0 0

0 1=4 1=4 1=4 1=4

1=2 0 0 0 1=21

C CCCA Les classes sont:f1;5g(recurrente),f3g(recurrente) etf2;4g(transiente). L'ensemble des mesures de probabilites invariantes est:(1=2;0;0;0;1=2) + (1 )(0;0;1;0;0), pour 01. Les mesures invariantes ne chargent pas les points transients. Et elles sont des combinaisons convexes de mesures invariantes sur chacune des 2 classes recurrentes. On ne considerera donc dans la suite que le cas irreductible (et recurrent). Remarque1.2.SiPest une matrice stochastique et siCEest une classe fermee alorsPjCest ecnore une matrice stochastique.1.1.Existence d'une mesure invariante.

Cas d'un espace d'etats ni: il existe toujours une mesure de probabilite invari- ante. Proof.On notedle cardinal deE. Soit0une probabilite surE, c'est-a-dire un vecteur deRda entrees positives et de somme 1. L'ensemble des probabilites surE forme donc un ensemble compact pour la topologie usuelle surRd. On considere la suite:n=0+0P+:::0Pnn+1. Il s'agit de la moyenne de Cesaro de la loi de la cha^ne de Markov. C'est encore une probabilite surE. Par compacite, on peut extraire une sous suitenkconvergeant vers une probabilite1. 12 MICHEL BONNEFONT

On ankP=nk+0Pn+10n+1. Puisque0Pn+1reste borne;nk!+1donne: 1P=1. Cas d'un espace d'etats denombrable: il n'existe pas necessairement de mesure de probabilite invariante a la marche aleatoire simple surZ, mais la mesure uniforme surZest invariante.1.2.Unicite de la mesure invariante.

Theoreme 1.3.SoitXnune cha^ne de Markov irreductible et recurrente. Alors il existe une mesure positive invariante. De plus, cette mesure est unique a multipli- cation pres par une constante.Proof.Pour chaquex2E, on pose:

(1.1)x(y) =Ex x1X k=01 fXk=yg! Cette quantite designe le nombre moyen de passage enyentre 2 passages enx.On a clairement:

(1.2)x(x) = 1 La cha^ne etant recurrente, on a quePx(fx<+1g) = 1 et queXx=x, on peut donc remarquer que (1.3)x(y) =Ex xX k=11 fXk=yg!Maintenant,

x(y) =Ex xX k=11 fXk=yg! =Ex +1X k=01 fxkg1fXk=yg! +1X k=0P x(fxkg;fXk=yg) X z2E+1X k=0P x(fxkg;fXk=yg;fXk1=zg) (1.4) Orfxkg=fxk1gc2(X0;X1;:::;Xk1), donc est independant de l'evenementfXk=ygconditionnellement afXk1=zgpar la propriete de Markov CHA ^INES DE MARKOV 3 faible d'ou: P x(fxkg;fXk=yg;fXk1=zg) =Pz;yPx(fxkg;fXk1=zg): D'ou x(y) = =X z2E+1X k=1P z;yPx(fxkg;fXk1=zg) X z2EP z;y+1X k=1P x(fxkg;fXk1=zg) X z2EP z;y+1X l=0P x(fxl+ 1g;fXl=zg) X z2EP z;yEx +1X l=01 fxl+1g1fXl=zg! X z2EP z;yEx x1X l=01 fXl=zg! X z2E x(z)Pz;y = (xP)(y):Doncxest une mesure positive invariante parP!

Maintenant, montrons que pour toutx;y2E,

0< x(y)<+1:

En eet, d'une part,Petant irreductible, il existen1 tel quePnx;y>0 et x(y) = (xPn)(y) =X z2E i(z)Pnz;yx(x)Pnx;y=Pnx;y>0:D'autre part, il existem1 tel quePmy;;x>0 et

1 =x(x) = (xPm)(x) =X

z2E x(z)Pmz;xx(y)Pmy;x; donc x(y)1P my;x<+1:4 MICHEL BONNEFONT

De plus, on peut calculer la masse totale de la mesurex, elle est donnee par la formule: x(E) =X y2E x(y) X y2EE x x1X k=01 fXk=yg! =Ex x1X k=0X y2E1 fXk=yg! =Ex x1X k=01! =Ex(x) Il reste a prouver l'unicite de cette mesure positive invariante. Soit doncune autre mesure positive (non identiquement nulle) invariante pourP. Soiti2Etel quei6= 0. Montrons d'abord que: (1.5)jii(j):Cette partie n'utilise que l'irreductibilite.

Soitj6=i2E, on a

j= (P)j=X i 12E i1Pi1;j =iPi;j+X i12E;i16=i

i1Pi1;j:Et de m^emei1=P

i22Ei2Pi2;i1, donc,

j=iPi;j+X i1;i16=iX

i 22Ei2Pi2;i1Pi1;j =iPi;j+X i

1;i16=i

iPi;i1Pi1;j+X i1;i16=iX

i2;i26=i

i2Pi2;i1Pi1;j CHA ^INES DE MARKOV 5 Ainsi, en poursuivant le m^eme raisonnement, on a pourn1, j=iPi;j +X i12E;i16=i

iPi;i1Pi1;j X i12E;i16=iX

i2;i26=i

iPi;i2Pi2;i1Pi1;j +X i12E;i16=iX

i22E;i26=iX

i n12E;in16=i iPi;in1Pin1;in2Pin2;in3:::Pi2;i1Pi1;j X i12E;i16=iX

i22E;i26=iX

i n2E;in6=i inPin;in1Pin1;in2:::Pi2;i1Pi1;j: Donc, (1.6) ji0Pi;j+X

i12E;i16=iP

i;i1Pi1;j++X i12E;i16=iX

i22E;i26=iX

i n12E;in16=iP i;in1Pin1;in2:::Pi2;i1Pi1;j1 AEt on a par exemple,

X i12E;i16=iP

i;i1Pi1;j=X i12E;i16=iP

i(X2=j; X1=i1) =Pi(X2=j; X16=i) =Pi(X2=j; i2)Ainsi, on deduit de (1.6), que

ji(Pi(X1=j) +Pi(X2=j; i2) ++Pi(Xn=j; in)) =iEi nX k=11 fXk=jg1fikg! En faisant tendrenvers l'inni dans l'inegalite precedente, on obtient, jiEi +1X k=11 fXk=jg1fikg! =iEi i1X k=11 fXk=jg! =ii(j); c'est-a-dire, pour tout (i;j)2E2, (1.7)jii(j)0:Maintenant montrons que

(1.8)j=ii(j): Orest une mesure invariante etPetant irreductible et recurrente,iest aussi une mesure invariante, donciiest une mesure (positive) invariante. Par6 MICHEL BONNEFONT

irreductibilite deP, pour toutj2E, il existen1 tel quePnj;i>0, et,0 =iii(i) =(ii)Pn

i =X k2E(kii(k))Pnk;i (jii(j))Pnj;i Or, par (1.7) etPnj;i>0, il s'ensuit que pour toutj2E,jii(j) = 0, donc la mesureest proportionnelle a la mesurei. Ceci nit la preuve du theoreme?? Precisons les resultats precedents dans les cas nis et denombrables:Cas d'un espace d'etats ni:

Proposition 1.4.SiPest irreductible. Elle est recurrente positive.Padmet une unique mesure de probabilite invariante. De plus pour pour touti2E, on a (i) = 1=Ei(i):Cas d'un espace d'etats denombrable:

Proposition 1.5.SupposonsPirreductible. Les assertions suivantes sont equivalentes (1)Il existe une (unique) mesure de probabilite invariante. (2)La mesuredenie pour touti2Epar(i) = 1=Ei(i)est la mesure de probabilite invariante. (3)Tous les etats sont recurrents positifs. (4)Il existe un etat recurrent positif. Exemple: On considere la marche aleatoire asymetrique surZ. Sip=q= 1=2, la marche est recurrente nulle et il existe une unique mesure positive invariante: la mesure uniforme qui n'est pas de masse nie. Sip6= 1=2, la marche est transiente et il existe ue famille de mesure invairantes: +(pq n, pour;0.1.3.Mesure reversible.Une mesure invariante verieP=P. cela peut se

reecrire sous la forme:X y6=x(y)P(y;x) =(x)(1 {(x;x)) Cela signie que sous, la masse qui arrive (globalement) enxest la m^eme que celle qui part dex. Denition 1.6.On dit queest reversible si pour toutx;y2E (x)P(x;y) =(y)P(y;x): Cela signie que sous, pour chaque ar^ete (x;y), la masse allant dexayest la m^eme que celle allant deyax. Proposition 1.7.Siest une mesure reversible alors elle est invariante. CHA ^INES DE MARKOV 7Proof.Soitx2E,

(P)(x) =X y2E(y)P(y;x) X y2E(x)P(x;y) =(x)X y2EP(x;y) =(x): Remarque1.8.Une cha^ne de Markov n'admet pas forcement de mesure reversible mais si c'est le cas, il est facile de trouver les mesures reversible pour une chaine deMarkov.

2.Theoreme ergodique

Comme pour les suites de variables i.i.d., il existe pour les cha^nes de Markov une "loi forte des grands nombres" appelee theoreme ergodique. Commencons par rappeler la loi forte des grands nombres usuelle. Theoreme 2.1.Soit(Yn)nune suite de variables aleatoires independantes et de m^eme loi. On suppose qu'elles sont integrables i.e.E[jY1j]<+1. Notons alors m=E[Y1]. Alors Y1++Ynn

p:s:!n!+1m:Pourx2E, notonsVx(n) =Pn1

i=01fXk=xgle nombre de visite dexavantn. La quantiteVx(n)n

correspond a la proportion de temps passe dans l'etatxavantn. Theoreme 2.2(Theoreme ergodique).. SupposonsPirreductible et recurrente. Alors, pour toute mesure initiale, et pour toutx2E, V x(n)n =1n n1X k=01 fXk=xgp:s:!n!+11E x(x):Dans le cas recurrent positif, La quantite

1E x(x)est nulle dans le cas recurrent nul. Elle est positive et vaut(x) dans le cas recurrent positif oudesigne l'unique probabilite invariante. Theoreme 2.3.Supposons que la cha^ne est recurrente positive. Alors pour toute mesure initiale, et pour toute fonctionfdeEdansRbornee, 1n n1X k=0f(Xk)p:s:!n!+1Z E fd:=X x2E(x)f(x) ou(x) =1E x(x)designe l'unique mesure de probabilite invariante.8 MICHEL BONNEFONT

Pour la preuve, on utilisera le lemme suivant.

Lemme 2.4.SoitPune matrice stochastique irreductible et recurrente. Soitx2E et soitune mesure de probabilite surE. Alors: P (Tx<+1) = 1 avecTx:= inffn0;Xn=xgle temps d'atteinte dex. Ce lemme dit juste que partant de n'importe quele mesure initiale, on nira par toucher le pointxdans le cas irreductible et recurrent. Venons en a la demonstration du theoreme ergodique. Proof.Soitx2Exe. PuisqueP(Tx<+1) = 1 et que (XTx+n)nest une cha^ne de Markov partant dexet est independante de (X0;:::;XTx). PuiqueTxest ni, le comportement en temps long de la propotion de temps passe enxest la m^eme pour (XTx+n)net pour (Xn)n. On peut dnc considerer que la cha^ne part dex. Maintenant considerons les temps successifs de passage enx1x=inffp1;Xp=xg;

nx=inffpn1x;Xp=xg; n2 ainsi que les durees entre 2 vistes dex, S nx=nxn1x; n1 (avec0x= 0). On a montre (chapitre sur la recurrence et la transience) que les (Snx)n sont des variables aleatoires independantes et de m^eme loi. On a de plus clairement que E [Snx] =Ex[x]: MaintenantVx(n) designe le nombre de visite enxavantn. On part au temps 0 dex, doncnxcorrespond a l'instant ou la cha^ne est enxpour lan+ 1 eme fois. Donc:Vx(n)1xn < Vx(n)x:

Orkx=S1x++Skx, donc en divisant parVx(n),

S1x++SVx(n)1xV

x(n)nV x(n)Donc pour!2

appartenant aux 2 ensembles precedents de probabilite 1: S1x(!) ++Sx(!)Vx(n;!)1V

x(n;!)!n!+1Ex[x]: CHA ^INES DE MARKOV 9 d'ou par encadrement, on deduit que nV x(n)p:s:!n!+1Ex[x] et enn V x(n)n p:s:!n!+11E x[x]: Remarque2.5.Dans le cas transient, on a queVx(1) =P k01fXk=xgest ni presque s^urement. Donc avec probabilite 1, V x(n)nVx(1)n

p:s:!n!+10:Venons en a la preuve de la consequence.

Proof.Pour simpler, faisons la juste dans le cas ouEest ni. SoitPirreductible recurrente positive. Soitfbornee parMsurE. Le point cle est d'ecrire, avec les notations precedentes: 1n n1X k=0f(Xk) =X x2EV x(n)n f(x):Maintenant:

1n n1X k=0f(Xk)X x2E xf(x) X x2EVx(n)n

x)f(x) MX x2E V x(n)n x:quotesdbs_dbs29.pdfusesText_35[PDF] chaine de markov exemple

[PDF] chaine de markov irreductible exemple

[PDF] chaine de markov exercice corrigé

[PDF] chaine énergétique barrage hydraulique

[PDF] chaine énergétique d'une éolienne

[PDF] exercice corrigé centrale hydraulique

[PDF] chaine énergétique centrale thermique

[PDF] chaine énergétique pile

[PDF] chaine énergétique exercices

[PDF] chaine énergétique éolienne

[PDF] chaine énergétique panneau solaire

[PDF] chaine energetique definition

[PDF] chaine énergétique exemple

[PDF] cours de logistique de distribution pdf