Chaînes de Markov

Chaînes de Markov

Résumé. Une chaîne de Markov est un processus aléatoire (Xn)n2N dont les transitions sont données par une matrice stochastique P(XnXn+1).

Fiche résumée du cours de Processus de Markov par I.Kourkova 1

Fiche résumée du cours de Processus de Markov par I.Kourkova 1

Fiche résumée du cours de Processus de. Markov par I.Kourkova. 1 Chaînes de ii) i mène à j pour la chaîne de markov (Yn)n∈N. iii) Il existe i = i0

CHAÎNES DE MARKOV

CHAÎNES DE MARKOV

Les résultats principaux de tout ce chapitre peuvent être résumés dans le théorème suivant : Théorème 29. Soit (Xn) une chaîne de Markov à ensemble d'états fini

Modèles de Markov cachés

Modèles de Markov cachés

RÉSUMÉ . . . . . xi. INTRODUCTION. 1. CHAPITRE 1. THÉORIE ET INFÉRENCE SUR LES CHAÎNES l'étude est bel et bien u11e chaine de Markov de matrice de transition ...

Modèles de chaînes de Markov cachées et de chaînes de Markov

Modèles de chaînes de Markov cachées et de chaînes de Markov

3 дек. 2018 г. Il ne reste plus qu'à itérer entre les étapes E et M jusqu'à convergence du vecteur. Ô. Pour résumer l'algorithme EM se construit en deux étapes ...

Chaînes de Markov et martingales

Chaînes de Markov et martingales

Définition 5.6 Soit E un espace vectoriel réel et X une partie de E. L'en- veloppe convexe de X notée cv(x) est l'ensemble des points combinaisons linéaires d'

Les techniques Monte Carlo par chaînes de Markov appliquées à la

Les techniques Monte Carlo par chaînes de Markov appliquées à la

26 мар. 2018 г. En résumé les équations d'évolution des densités de quarks non singulets sont : ... approche basée sur les méthodes Monte Carlo par chaînes de ...

Chaînes de Markov.

Chaînes de Markov.

Alors conditionnellement à Xn = x le processus. Xn+ est une chaîne de Markov de matrice de transition P

Tricks espérance/conditionnelle

Tricks espérance/conditionnelle

0.5 Chaînes de Markov. Quelques notations: (Qf)(x) = ∑ y∈E. Q(x y)f(y). (µQ)(x) = ∑ y∈E. µ(y)Q(y

Chaînes de Markov cachées à bruit généralisé

Chaînes de Markov cachées à bruit généralisé

17 июн. 2022 г. Résumé – Les chaînes de Markov cachées sont des modèles très populaires pour le traitement non-supervisé du signal dans un contexte bayésien ...

Chaînes de Markov

Chaînes de Markov

Résumé. Une chaîne de Markov est un processus aléatoire (Xn)n2N dont les transitions sont données par une matrice stochastique P(XnXn+1).

Fiche résumée du cours de Processus de Markov par I.Kourkova 1

Fiche résumée du cours de Processus de Markov par I.Kourkova 1

1 Chaînes de Markov à temps continu sur un espace dénombrable. 1.1 loi exponentielle. Définition 1.1.1 (Loi exponentielle) Une variable aléatoire T suit une.

CHAÎNES DE MARKOV

CHAÎNES DE MARKOV

Soit Xn est une chaîne de Markov de matrice de transition P et soit ?0 la loi de X0. tout ce chapitre peuvent être résumés dans le théorème suivant :.

Chaînes de Markov.

Chaînes de Markov.

Alors conditionnellement à Xn = x le processus. Xn+ est une chaîne de Markov de matrice de transition P

IFT-3655 Modèles Stochastiques orange Chaînes de Markov en

IFT-3655 Modèles Stochastiques orange Chaînes de Markov en

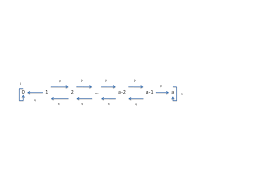

Chaˆ?ne de Markov en temps discret. On consid`ere un processus stochastique en temps discret {Xn n = 0

Modèles stochastiques Chaîne de Markov en temps continu

Modèles stochastiques Chaîne de Markov en temps continu

Dans le chapître précédent sur les chaînes de Markov les moments (temps) Le processus stochastique est alors u chaîne de Markov en temps co.

6 Chaînes de Markov - Etude dune classe particulière de processus

6 Chaînes de Markov - Etude dune classe particulière de processus

aléatoires : chaînes de Markov d'ordre1. 2. généralisation : chaîne d'ordre supérieur. 3. chaines de Markov non-homogène dans le temps. 4.

Introduction aux chaînes de Markov

Introduction aux chaînes de Markov

? Exercice 71. Soit (Xn)n?N une cha?ne de Markov homog`ene de matrice de transition Q et de loi initiale µ. On.

Chaînes de Markov (et applications)

Chaînes de Markov (et applications)

22 Feb 2021 Les coefficients d'une matrice stochastique sont dans [0 1]. Proposition 1. Si Q est la matrice de transition d'une chaîne de Markov

Chaînes de Markov et martingales

Chaînes de Markov et martingales

Définition 5.6 Soit E un espace vectoriel réel et X une partie de E. L'en- veloppe convexe de X notée cv(x) est l'ensemble des points combinaisons linéaires d'

[PDF] CHAÎNES DE MARKOV - Institut de Mathématiques de Bordeaux

[PDF] CHAÎNES DE MARKOV - Institut de Mathématiques de Bordeaux

Les résultats principaux de tout ce chapitre peuvent être résumés dans le théorème suivant : Théorème 29 Soit (Xn) une chaîne de Markov à ensemble d'états fini

[PDF] Chaînes de Markov

[PDF] Chaînes de Markov

Résumé Une chaîne de Markov est un processus aléatoire (Xn)n2N dont les transitions sont données par une matrice stochastique P(XnXn+1)

[PDF] CHAÎNES DE MARKOV - ceremade

[PDF] CHAÎNES DE MARKOV - ceremade

5 3 4 Graphe associé à une chaîne de Markov homogène recherche se situent dans le domaine de la théorie des nombres et en analyse ses recherches

[PDF] Chaînes de Markov - Institut Camille Jordan

[PDF] Chaînes de Markov - Institut Camille Jordan

est appelée une chaîne de Markov d'espace d'états S lorsqu'il existe une famille de noyaux de transitions (pn(··))n?0 sur S et une loi de probabilité ?

[PDF] Chapitre 8 Chaˆ?nes de Markov - DI ENS

[PDF] Chapitre 8 Chaˆ?nes de Markov - DI ENS

En fait les cha?nes de Markov sont des processus stochastiques dont l'évolution est régie par une équation de récurrence du type Xn+1 = f(XnZn+1) o`u {Zn}n?

[PDF] Chaînes de Markov (et applications)

[PDF] Chaînes de Markov (et applications)

22 fév 2021 · Xn est donc bien une chaîne de Markov homogène avec matrice de transition Q Exercice 4 Introduisons un facteur de fatigue f ? (0 1) et

[PDF] Fiche résumée du cours de Processus de Markov par IKourkova 1

[PDF] Fiche résumée du cours de Processus de Markov par IKourkova 1

Fiche résumée du cours de Processus de Markov par I Kourkova 1 Chaînes de Markov à temps continu sur un espace dénombrable 1 1 loi exponentielle

[PDF] Introduction aux chaines de Markov - CERMICS

[PDF] Introduction aux chaines de Markov - CERMICS

Soit P une matrice stochastique sur E Une suite de variables aléatoires (Xnn ? N) `a valeurs dans E est appelée cha?ne de Markov de matrice de transition P

[PDF] Chaînes de Markov et martingales - Index of /

[PDF] Chaînes de Markov et martingales - Index of /

Définition 5 6 Soit E un espace vectoriel réel et X une partie de E L'en- veloppe convexe de X notée cv(x) est l'ensemble des points combinaisons linéaires d'

[PDF] Chaînes de Markov - arthur charpentier

[PDF] Chaînes de Markov - arthur charpentier

École Nationale de la Statistique et d'Analyse de l'Information En 1907 Ehrenfest a introduit des chaînes de Markov pour étudier la diffusion d'un gaz

ChaînesdeMarkov

ArthurCharpentier

-nepasdiffuser,nepasciter-1Quelquesmotivations

1.1Lasentinelledelatourcarrée

n désignela transition, P= /N//E//S//O/ N E S O01/201/2

1/201/20

01/201/2

1/201/20

P= p00001-p p00001-p0p0001-p

00p001-p

000p01-p

0000p1-p

Proportion par classe en fonction de n, p=90%

0.0Proportion par classe en fonction de n, p=80%

0.0 k =P(N=k)=e k /k!,k?N,et p k =p 0 +...+p k P= p 0 p 1 p 2 p 3 p 4 1-p 4 p 0 0p 1 p 2 p 3 1-p 3 0p 0 0p 1 p 2 1-p 2 00p 0 0p 1 1-p 1 000p 0 01-p 0 0000p 0 1-p 0Proportion par classe en fonction de n, 10%

0.0Proportion par classe en fonction de n, 35%

0.01.3Laruined'unjoueur

0 etY 0 ,etlejeus'arrêtelorsqu'un joueurn'aplusd'argentpourpayer. 0 +Y 0 }.SilejoueurXpossède unefortuneX n =kàladaten,àladaten+1 X 0 +Y 0 •safortuneresteenX 0 +Y 0 avecprobabilité1sik=X 0 +Y 01.4Lemodèlesteppingstone

1 10'!#!(!$!

Le moldèle Stepping stone, Etape 0

0'!#!(!$!

Le moldèle Stepping stone, Etape 10 000

0'!#!(!$!

Le moldèle Stepping stone, Etape 1 000 000

1.5Uneapplicationéconomique

AAAAAABBBBBBCCCdéfaut

1.6Applicationslexicographiques

P=12,8%87,2%

66,3%33,7%

consonnesrespectivement.1.7Diffusiond'ungazeturne

denomsdefamille.1.8ChaînesdeMarkovetjeuxdecartes

mémentaléatoiredescartes. Urne d'Ehrenfest, étape 0Urne d'Ehrenfest, étape 1 Urne d'Ehrenfest, étape 2Urne d'Ehrenfest, étape 10 000Figure6:L'urned'Ehrenfest.

Urne d'Ehrenfest, étape 0Urne d'Ehrenfest, étape 1 Urne d'Ehrenfest, étape 2Urne d'Ehrenfest, étape 10 000Figure7:L'urned'Ehrenfest.

1#($)%*&+,-R

9,-.'#($)%*8

R'#($)%*&+,D

V-.'#($)%*&9

Figure8:Lebattagedecartes.

1#($)%*&+,-R

5'#($%*&+,-R

3)'#$%*&+,-R

9()'#$%*&,-R

4+()'#%*&,-R

9$()'#%*&,-R

2+$()'%*&,-R

4#+()'%*&,-R

Figure9:Lebattagedecartes.

1.9ChaînesdeMarkovetADN

exemplegactgaactctgag... decg. SoitX 1 a c g t où a =P(X 1 =a),λ c =P(X 1 =c),λ g =P(X 1 =g)etλ t =P(X 1 =t), avecλ a c g t =1etλ a c g t ≥0. n n?N n'estpasindépen- pourlevecteurX= a c g t estP=18,0%27,4%42,6%12,0%

17,1%36,8%27,4%18,8%

16,1%33,9%37,5%12,5%

7,9%35,5%38,4%18,6%

P=30,0%20,5%28,5%21,0%

32,2%29,8%7,8%30,2%

24,8%24,6%29,8%20,8%

17,7%23,9%29,2%29,2%

1.10ApplicationaujeudeMonopoly

"allezenprison"). zoneorangel'emportesurlazonerouge.0.0!"#!"$!"%!"&'"!

Probabilité de gagner un jeu au tennis

Probabilité de gagner une balle

/012324546789:8;3;<:08=<8>:=1.11Modélisationd'unepartiedetennis

lejeus'ilatteint50. (0,50)(15,50)(30,50) (0,40)(15,40)(30,40) (0,30)(15,30)(30,30)(40,30)(50,30) (0,15)(15,15)(30,15)(40,15)(50,15) (0,0)(15,0)(30,0)(40,0)(50,0)1.12Lesprocessusdefiled'attente

n lenombredeclientsprésents danslafileàladaten.(X n n?N estunechaînedeMarkov.Unprocessus(X

t t?Tω?Ω,lasuite(X

t (ω))seraappeléeunetrajectoire.Parmilesprocessususuels,ondistinguera

•lecasoùTestcontinu(RouR0)'!')#!

File d'attente p>q

Date ?1@20:89A=3;:0B893Modèle de file d'attente p>q

Dates ?1@20:89A=B3;:0B8930)'!')#!

File d'attente p>q

Date ?1@20:89A=3;:0B893Modèle de file d'attente p>q

Dates ?1@20:89A=B3;:0B8930)'!')#!

File d'attente p=q

Date ?1@20:89A=3;:0B8930)'!')#!

File d'attente p Date ?1@20:89A=3;:0B893Modèle de file d'attente p Dates ?1@20:89A=B3;:0B893Figure14:Evolutiondelafiled'attente,p Trajectoire d'une chaîne de MarkovTrajectoire d'une chaîne de Markov Trajectoire d'une chaîne de MarkovTrajectoire d'une chaîne de Markov 2468'!

4 2 Trajectoire d'une série temporelle

2468'!

4 2 Trajectoire d'une série temporelle

02468'!

Trajectoire d'un processus de comptage

02468'!

Trajectoire d'un processus de comptage

02468'!

4 2 Trajectoire d'un processus stochastique

02468'!

4 2 Trajectoire d'un processus stochastique

2Quelquespetitsrappelsdeprobabilité

n+1 sachantX n =x n 2.1Laloiconditionnelle

RappelonslaformuledeBayes:P(A|B)=

P(A∩B)

P(B) Aussi,P(X

n+1 =x n+1 |X n =x n P(X n =x n ,X n+1 =x n+1 P(X n =x n Laformuledesprobabilitéstotales:si(B

k k?K formeunepartitiondeE,alors P(A)= kK P(A∩B

k kK P(A|B k )×P(B k Aussi,P(X

n+1 =x n+1 xn?E P(X n+1 =xquotesdbs_dbs7.pdfusesText_13

2468'!

4 2Trajectoire d'une série temporelle

2468'!

4 2Trajectoire d'une série temporelle

02468'!

Trajectoire d'un processus de comptage

02468'!

Trajectoire d'un processus de comptage

02468'!

4 2Trajectoire d'un processus stochastique

02468'!

4 2Trajectoire d'un processus stochastique

2Quelquespetitsrappelsdeprobabilité

n+1 sachantX n =x n2.1Laloiconditionnelle

RappelonslaformuledeBayes:P(A|B)=

P(A∩B)

P(B)Aussi,P(X

n+1 =x n+1 |X n =x n P(X n =x n ,X n+1 =x n+1 P(X n =x nLaformuledesprobabilitéstotales:si(B

k k?K formeunepartitiondeE,alors P(A)= kKP(A∩B

k kK P(A|B k )×P(B kAussi,P(X

n+1 =x n+1 xn?E P(X n+1 =xquotesdbs_dbs7.pdfusesText_13[PDF] chaine d'acquisition de données

[PDF] chaine de mesure audioprothèse

[PDF] acquisition de données du capteur ? l ordinateur

[PDF] chaine de mesure pdf

[PDF] chaine d'acquisition capteur

[PDF] les capteurs exercices corrigés

[PDF] chaine de markov apériodique

[PDF] chaine de markov apériodique exemple

[PDF] chaine de markov reversible

[PDF] chaine de markov récurrente

[PDF] chaine de markov exemple

[PDF] chaine de markov irreductible exemple

[PDF] chaine de markov exercice corrigé

[PDF] chaine énergétique barrage hydraulique