Exercice 1 Considérons un échantillon de n = 5 individus où chaque

Exercice 1 Considérons un échantillon de n = 5 individus où chaque

Calculer les écarts types σj de chacune des variables. 4. Calculer la matrice Z des données centrées-réduites. 5. Calculer la matrice de variance-covariance Σ

Exercices corrigés

Exercices corrigés

2. En déduire les lois marginales de U et V . 3. Calculer les matrices de covariance de [X Y ]t et de [U V ]t

Exercices

Exercices

En général une matrice de variances-covariances inversible est la matrice d'un produit Les notations sont celles de l'exercice précédent. a) Pour quelle ...

Régression linéaire

Régression linéaire

vecteur aléatoire ˆβ ou matrice de variance-covariance

Corrigés des exercices

Corrigés des exercices

Exercice 4. Solution. 1 La matrice de variance-covariance est donnée par V =.. 0 01000 0

TD01- COUPLES DE VARIABLES ALEATOIRES DISCRETES ET

TD01- COUPLES DE VARIABLES ALEATOIRES DISCRETES ET

=2X – Y Montrer que (U

coefficient de corrélation Exercice 6 : Matrice de variance-covariance

coefficient de corrélation Exercice 6 : Matrice de variance-covariance

Exercice 6 : Matrice de variance-covariance. En Matlab il y a une commande « cov » pour calculer la matrice de variance-covariance pour des réalisations des

Sciences de gestion - Synthèse de cours exercices corrigés

Sciences de gestion - Synthèse de cours exercices corrigés

.... . La matrice de variance et de covariance de u est : Σu = E(uui) =..... σ2. 1 σ12. ··· σ1m σ21 σ2. 2. ··· σ2m ... ... ... .

Se familiariser avec les bases/notations Exercice 1. Soient une

Se familiariser avec les bases/notations Exercice 1. Soient une

Donnez la matrice de variance–covariance des variables indicatrices 1{kœS}. k = yk

Master 1 BEM MQEM T. D. n II . LACP pratique. Exercice n 1. Ent

Master 1 BEM MQEM T. D. n II . LACP pratique. Exercice n 1. Ent

2) Calculer la covariance entre x1 et x1. Que représente cette quantité? Exercice n? 2 ... et V la matrice de variance-covariance. Après calculs :.

Exercice 1 Considérons un échantillon de n = 5 individus où chaque

Exercice 1 Considérons un échantillon de n = 5 individus où chaque

Calculer les écarts types ?j de chacune des variables. 4. Calculer la matrice Z des données centrées-réduites. 5. Calculer la matrice de variance-covariance ?

Exercices corrigés

Exercices corrigés

Calculer la variance Var{X1} de X1 et la covariance Cov{X1X2} de (X1

Exercices et problèmes de statistique et probabilités

Exercices et problèmes de statistique et probabilités

Corrigés des exercices . Chapitre 5 Estimateur sans biais de variance minimale . ... f) Matrice des variances-covariances. M(XY) =.

1 Matrice de covariance

1 Matrice de covariance

Typiquement son espérance ou sa variance. Un estimateur de ? est une variable aléatoire ?? à valeurs dans Rd

Exercices

Exercices

Les variances et les covariances sont toutes égales. ? La matrice de corrélation est de rang 2. ? L'angle entre deux variables vaut au maximum 2.

TD 1 : Se familiariser avec les bases/notations Exercice 1. Soient

TD 1 : Se familiariser avec les bases/notations Exercice 1. Soient

Ce qui est logique puisque nous avons vu que le fi–estimateur était un estimateur sans biais ! Exercice 3. Soit la matrice de variance–covariance. = (k¸)k¸ des

Corrigés des exercices

Corrigés des exercices

Corrigés des exercices Note : Dans la note de l'exercice 1.1 on a établi que P(X < x) = FX(x ... La matrice des variances-covariances est :.

PC 5 – Calcul de lois & Vecteurs gaussiens

PC 5 – Calcul de lois & Vecteurs gaussiens

20 mai 2019 Exercice 1. ... Le calcul du déterminant de la matrice jacobienne donne ... matrice de variance-covariance est donnée par. Var(U) = Var.

coefficient de corrélation Exercice 6 : Matrice de variance-covariance

coefficient de corrélation Exercice 6 : Matrice de variance-covariance

Vos prévisions sont-elles vérifiées ? Exercice 6 : Matrice de variance-covariance. En Matlab il y a une commande « cov » pour calculer la

[PDF] Exercice 1 Considérons un échantillon de n = 5 individus où chaque

[PDF] Exercice 1 Considérons un échantillon de n = 5 individus où chaque

Calculer la matrice de variance-covariance ? de Z et la matrice de corrélation R de X Commenter 6 Effectuer une décomposition spectrale de la matrice de

[PDF] coefficient de corrélation Exercice 6 : Matrice de variance-covariance

[PDF] coefficient de corrélation Exercice 6 : Matrice de variance-covariance

Exercice 6 : Matrice de variance-covariance En Matlab il y a une commande « cov » pour calculer la matrice de variance-covariance pour des

[PDF] Exercices

[PDF] Exercices

La fiche donne des énoncés d'exercices d'algèbre et d'analyse des données En général une matrice de variances-covariances inversible est la matrice

[PDF] Exercices corrigés - IMT Atlantique

[PDF] Exercices corrigés - IMT Atlantique

Le lecteur trouvera ici les énoncés et corrigés des exercices proposés dans Calculer les matrices de covariance de [X Y ]t et de [U V ]t Solution

[PDF] Corrections des exercices - Pages personnelles Université Rennes 2

[PDF] Corrections des exercices - Pages personnelles Université Rennes 2

Exercice 5 1 (Questions de cours) A A C B Exercice 5 2 (Analyse de la covariance) Nous avons pour le modèle complet la matrice suivante : X =

[PDF] Leçon 14 Exercices corrigés

[PDF] Leçon 14 Exercices corrigés

Leçon 14 Exercices corrigés L'objet de l'exercice est d'obtenir un bon encadrement de la dans R3 de matrice de covariance

[PDF] 1 Matrice de covariance - Mathématiques

[PDF] 1 Matrice de covariance - Mathématiques

Typiquement son espérance ou sa variance Un estimateur de ? est une variable aléatoire ?? à valeurs dans Rd qui dépend de X1 Xn Il est consistant

[PDF] CORRIGÉ

[PDF] CORRIGÉ

CORRIGÉ TD 9 : Régression linéaire Exercice 1 : On reprend l'exemple des 5 Calculs effectués pour variances et covariance : Var(x) = µ(x2 ) ? µ(x)

[PDF] Synthèse de cours exercices corrigés - ACCUEIL

[PDF] Synthèse de cours exercices corrigés - ACCUEIL

Sciences de gestion Synthèse de cours Exercices corrigés Économétrie Q où Ln est la matrice de variance et de covariance de u (?u = Ln)(3) et où Q

Comment trouver la matrice des variances covariances ?

D'ailleurs, la covariance d'une variable avec elle-même (autocovariance) est tout simplement la variance. Cov(X,X) = V(X). Donc, faisons un parallèle avec le théorème de König : la covariance est la moyenne du produit des valeurs de deux variables moins le produit des deux moyennes.Comment montrer qu'une matrice est une matrice de covariance ?

Propriétés de la matrice de covariance

La matrice de covariance est symétrique ; ses éléments diagonaux sont les variances et les éléments extra-diagonaux sont les covariances des couples de variables. La matrice de covariance est semi-définie positive (ses valeurs propres sont positives ou nulles).Comment Calculer COV ?

On calcule Cov( ? X , ? Y ) = E( ? X ? Y ) ? E( ? X ) E( ? Y ) = ? ? E( X Y ) ? ? ? E( X ) E( Y ).- En termes simples, les deux termes mesurent la relation et la dépendance entre deux variables. “Covariance” = la direction de la relation linéaire entre les variables. La “corrélation”, en revanche, mesure à la fois la force et le sens de la relation linéaire entre deux variables.

Chapitre 1Corrections des exercices1.1 Régression linéaire simpleExercice 1.1 (Questions de cours)B, A, B, A.Exercice 1.2 (Biais des estimateurs)Lesˆβjsont fonctions deY(aléatoire), ce sont donc des variables aléatoires. Une autre

façon d"écrire ˆβ2en fonction deβ2consiste à remplaceryidans (??) par sa valeur soitβ2=?(xi-¯x)yi

?(xi-¯x)2=β1?(xi-¯x) +β2?xi(xi-¯x) +?(xi-¯x)εi?(xi-¯x)2 =β2+?(xi-¯x)εi ?(xi-¯x)2.Par hypothèseE(εi) = 0, les autres termes ne sont pas aléatoires, le résultat est démontré.

Le résultat est identique pourˆβ1carE(ˆβ1) =E(¯y)-¯xE(ˆβ2) =β1+ ¯xβ2-¯xβ2=β1, le

résultat est démontré.Exercice 1.3 (Variance des estimateurs)

Nous avons

V(ˆβ2) = V?

2+?(xi-¯x)εi

?(xi-¯x)2? Orβ2est inconnu mais pas aléatoire et lesxine sont pas aléatoires donc V(ˆβ2) = V?

?(xi-¯x)εi ?(xi-¯x)2? =V(?(xi-¯x)εi)[?(xi-¯x)2]2 i,j(xi-¯x)(xj-¯x)Cov(εi,εj) [?(xi-¯x)2]2.OrCov(εi,εj) =δijσ2donc

V(ˆβ2) =?

i(xi-¯x)2σ2 i(xi-¯x)2?2=σ2?(xi-¯x)2.2 Régression avecR

Plus les mesuresxisont dispersées autour de leur moyenne, plusV(ˆβ2)est faible et plusl"estimation est précise. Bien sûr, plusσ2est faible, c"est-à-dire plus lesyisont proches

de la droite inconnue, plus l"estimation est précise. Puisqueˆβ1= ¯y-ˆβ2¯x, nous avons V(ˆβ1) = V?

¯y-ˆβ2¯x?

= V(¯y) +V(¯xˆβ2)-2Cov(¯y,ˆβ2¯x) = V ?yi n? + ¯x2σ2?(xi-¯x)2-2¯xCov(¯y,ˆβ2) σ2 n+ ¯x2σ2?(xi-¯x)2-2¯x? iCov(¯y,ˆβ2).Calculons

Cov(¯y,ˆβ2) =1

nCov?? i(β1+β2xi+εi),? j(xj-¯x)εj? j(xj-¯x)2? 1 n? iCov? i,? j(xj-¯x)εj? j(xj-¯x)2? 1 j(xj-¯x)2? i1nCov? i,? j(xj-¯x)εj?σ21

n? i(xi-¯x)? j(xj-¯x)2= 0.Nous avons donc

V(ˆβ1) =σ2

n+ ¯x2σ2?(xi-¯x)2=σ2?x2in?(xi-¯x)2. Là encore, plusσ2est faible, c"est-à-dire plus lesyisont proches de la droite inconnue, plus l"estimation est précise. Plus les valeursxisont dispersées autour de leur moyenne, plus la variance de l"estimateur sera faible. De même, une faible moyenne¯xen valeur absolue contribue à bien estimerβ1.Exercice 1.4 (Covariance de

ˆβ1etˆβ2)

Nous avons

Cov(ˆβ1,ˆβ2) = Cov(¯y-ˆβ2¯x,ˆβ2) = Cov(¯y,ˆβ2)-¯xV(ˆβ2) =-σ2¯x

?(xi-¯x)2.La covariance entreβ1etβ2est négative. L"équation¯y=ˆβ1+ˆβ2¯xindique que la droite

des MC passe par le centre de gravité du nuage(¯x,¯y). Supposons¯xpositif, nous voyons bien que, si nous augmentons la pente, l"ordonnée à l"origine va diminuer et vice versa. Nous retrouvons donc le signe négatif pour la covariance entreˆβ1etˆβ2.Exercice 1.5 (Théorème de Gauss-Markov)

L"estimateur des MC s"écrit

ˆβ2=?ni=1piyi,avecpi= (xi-¯x)/?(xi-¯x)2.Considérons un autre estimateur

˜β2linéaire enyiet sans biais, c"est-à-direβ2=n?

i=1λ iyi.Chapitre 1. Corrections des exercices 3

Montrons que?λi= 0et?λixi= 1. L"égalitéE(˜β2) =β1?λi+β2?λixi+?λiE(εi)

est vraie pour toutβ2et˜β2est sans biais doncE(˜β2) =β2pour toutβ2, c"est-à-dire que?λi= 0et?λixi= 1.

Montrons queV(˜β2)≥V(ˆβ2).

V(˜β2) = V(˜β2-ˆβ2+ˆβ2) = V(˜β2-ˆβ2) + V(ˆβ2) + 2Cov(˜β2-ˆβ2,ˆβ2).

Cov( ?(xi-¯x)2-σ2?(xi-¯x)2=0, et donc V( ˜β2) = V(˜β2-ˆβ2) + V(ˆβ2).Une variance est toujours positive et donc

V(˜β2)≥V(ˆβ2).

Le résultat est démontré. On obtiendrait la même chose pourˆβ1.

Exercice 1.6 (Somme des résidus)

Il suffit de remplacer les résidus par leur définition et de remplacerˆβ1par son expression

iˆεi=? i(yi-¯y+ˆβ2¯x-ˆβ2xi) =? i(yi-¯y)-ˆβ2? i(xi-¯x) = 0.Exercice 1.7 (Estimateur de la variance du bruit)

Récrivons les résidus en constatant que

ˆβ1= ¯y-ˆβ2¯xetβ1= ¯y-β2¯x-¯ε, = ¯y-β2¯x-¯ε+β2xi+εi-¯y+ˆβ2¯x-ˆβ2xi = (β2-ˆβ2)(xi-¯x) + (εi-¯ε). En développant et en nous servant de l"écriture deˆβ2donnée dans la solution de l"exercice

??, nous avons?ˆε2i= (β2-ˆβ2)2?(xi-¯x)2+?(εi-¯ε)2+2(β2-ˆβ2)?(xi-¯x)(εi-¯ε)

= (β2-ˆβ2)2?(xi-¯x)2+?(εi-¯ε)2-2(β2-ˆβ2)2?(xi-¯x)2.Prenons en l"espérance

E??ˆεi2?

=E??(εi-¯ε)2? -?(xi-¯x)2V(ˆβ2) = (n-2)σ2.Exercice 1.8 (Variance deˆyp

n+1)Calculons la variance

V ?ˆyp n+1?= V?ˆβ1+ˆβ2xn+1? = V(ˆβ1) +x2n+1V(ˆβ2) + 2xn+1Cov?ˆβ1,ˆβ2? σ2 ?(xi-¯x)2? ?x2in+x2n+1-2xn+1¯x? σ2 ?(xi-¯x)2?? (xi-¯x)2n+ ¯x2+x2n+1-2xn+1¯x? =σ2?1 n+(xn+1-¯x)2?(xi-¯x)2?4 Régression avecR

Plus la valeur à prévoir s"éloigne du centre de gravité, plusla valeur prévue sera variable

(i.e. de variance élevée). Exercice 1.9 (Variance de l"erreur de prévision) Nous obtenons la variance de l"erreur de prévision en nous servant du fait queyn+1est fonction deεn+1seulement, alors queˆyp n+1est fonction des autresεi,i= 1,···,n. Les deux quantités ne sont pas corrélées. Nous avons alorsV(ˆεpn+1)=V?y

n+1-ˆyp n+1?=V(yn+1)+V(ˆyp n+1)=σ2? 1 +1 n+(xn+1-¯x)2?(xi-¯x)2? Exercice 1.10 (R2et coefficient de corrélation)Le coefficientR2s"écrit

R 2=? n i=1?ˆβ1+ˆβ2xi-¯y? 2 ?ni=1(yi-¯y)2=? n i=1?¯y-ˆβ2¯x+ˆβ2xi-¯y?

2?ni=1(yi-¯y)2

ˆβ22?ni=1(xi-¯x)2

?ni=1(yi-¯y)2=? ?ni=1(xi-¯x)(yi-¯y)?2Exercice 1.11 (Les arbres)

Le calcul donne

β1=6.26

28.29= 0.22ˆβ0= 18.34-0.22×34.9 = 10.662.

Nous nous servons de la propriété

?ni=1ˆεi= 0pour obtenir R 2=? 20 i=1(ˆyi-¯y)2 ?20i=1(yi-¯y)2=? 20 i=1(ˆβ1xi-ˆβ1¯x)2?20i=1(yi-¯y)2= 0.222×28.292.85= 0.48. Les statistiques de test valent 5.59 pourβ0et 4.11 pourβ1. Elles sont à comparer à un fractile de la loi de Student admettant 18 ddl, soit 2.1. Nousrejetons dans les deux cas l"hypothèse de nullité du coefficient. Nous avons modélisé lahauteur par une fonction affine de la circonférence, il semblerait évident que la droite passe par l"origine (un arbre admettant un diamètre proche de zéro doit être petit), or nous rejetons l"hypothèse0= 0. Les données mesurées indiquent des arbres dont la circonférence varie de 26 à 43

cm, les estimations des paramètres du modèle sont valides pour des données proches de [26;43].Exercice 1.12 (Modèle quadratique)

Les modèles sont

O3=β1+β2T12+εmodèle classique,

O3=γ1+γ2T122+?modèle demandé.

L"estimation des paramètres donne

O3= 31.41 + 2.7T12R2= 0.28modèle classique,

O3= 53.74 + 0.075T122R2= 0.35modèle demandé.Les deux modèles ont le même nombre de paramètres, nous préférons le modèle quadra-

tique car leR2est plus élevé.Chapitre 1. Corrections des exercices 5

1.2 Régression linéaire multiple

Exercice 2.1 (Questions de cours)

A, A, B, B, B, C.

Exercice 2.2 (Covariance deˆεet deˆY)

Les matricesX,PXetPX?sont non aléatoires. Nous avons alors Cov(ˆε,ˆY) =E(ˆεˆY?)-E(ˆε)E(ˆY?) =E?PX?ε(PX(Xβ+ε))?? =E(PX?εβ?X?) +E(PX?εε?PX) = 0 +PX?σ2PX= 0.Exercice 2.3 (Théorème de Gauss-Markov)

Nous devons montrer que, parmi tous les estimateurs linéaires sans biais, l"estimateur de MC est celui qui a la plus petite variance. La linéarité deˆβest évidente. Calculons sa

variance : V( ˆβ) = V((X?X)-1X?Y) = (X?X)-1X?V(Y)X(X?X)-1=σ2(X?X)-1. Nous allons montrer que, pour tout autre estimateur ˜βdeβlinéaire et sans biais,V(˜β)≥ V(ˆβ). Décomposons la variance de˜β V(˜β) = V(˜β-ˆβ+ˆβ) = V(˜β-ˆβ) + V(ˆβ)-2Cov(˜β-ˆβ,ˆβ).

Les variances étant définies positives, si nous montrons queCov(˜β-ˆβ,ˆβ) = 0, nous

aurons fini la démonstration.Puisque˜βest linéaire,˜β=AY. De plus, nous savons qu"il est sans biais, c"est-à-dire

E(˜β) =βpour toutβ, doncAX=I. La covariance devient : Cov( ˜β-ˆβ,ˆβ) = Cov(AY,(X?X)-1X?Y)-V(ˆβ) =σ2AX(X?X)-1-σ2(X?X)-1= 0.Exercice 2.4 (Représentation des variables)

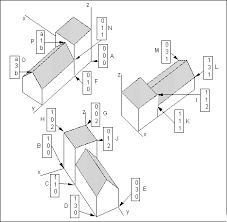

Nous représentons les données dansR2pour le premier jeu et dansR3pour le second. OY OX Oyy x O xz y OY Oy OXOZFig. 2.1- Représentation des données.

6 Régression avecR

Dans le premier modèle, nous projetonsYsur l"espace engendré parX, soit la droite de vecteur directeur--→OX. Nous trouvons par le calculˆβ= 1.47, résultat que nous aurions pu trouver graphiquement car--→OˆY=ˆβ.--→OX.ConsidéronsR3muni de la base orthonormée(?i,?j,?k). Les vecteurs--→OXet-→OZengendrent

le même plan que celui engendré par(?i,?j). La projection deYsur ce plan donne--→OˆY. Il est quasiment impossible de trouverˆβetˆγgraphiquement mais nous trouvons par le calculˆβ=-3.33etˆγ= 5.Exercice 2.5 (Modèles emboîtés)

Nous obtenons

Yp=XˆβetˆYq=Xqˆγ.

Par définition duR2, il faut comparer la norme au carré des vecteursˆYpetˆYq. Notons les espaces engendrés par les colonnes deXqetX,?Xqet?X, nous avons?Xq? ?X.Nous obtenons alors

Yp=PXpY= (PXq+PX?q)PXpY=PXqPXpY+PX?qPXpY

=PXqY+PX?q∩XpYˆYq+PX?q∩XpY.

En utilisant le théorème de Pythagore, nous avons ˆYp?2=?ˆYq?2+?PX?q∩XpY?2≥ ?ˆYq?2, d"où R2(p) =?ˆYp?2

?Y?2≥?ˆYq?2?Y?2= R2(q). En conclusion, lorsque les modèles sont emboîtés?Xq? ?X, leR2du modèle le plus grand (ayant le plus de variables) sera toujours plus grand que leR2du modèle le plus petit.Exercice 2.6

La matriceX?Xest symétrique,nvaut 30 et¯x= ¯z= 0. Le coefficient de corrélation x,z=? 30i=1(xi-¯x)(zi-¯z) ??30i=1(xi-¯x)2?30i=1(zi-¯z)2=? 30

i=1xizi??30i=1x2i? 30

i=1z2i=7⎷150= 0.57.

Nous avons

y i=-2 +xi+zi+ ˆεi et la moyenne vaut alors¯y=-2 + ¯x+ ¯z+1

n? iˆεi.Chapitre 1. Corrections des exercices 7

La constante étant dans le modèle, la somme des résidus est nulle car le vecteurˆεest orthogonal au vecteur1. Nous obtenons donc que la moyenne deYvaut 2 car¯x= 0et¯z= 0. Nous obtenons en développant

ˆY?2=30?

i=1(-2 +xi+ 2zi)2 = 4 + 10 + 60 + 14 = 88. Par le théorème de Pythagore, nous concluons queSCT = SCE+SCR = 88 + 12 = 100.

Exercice 2.7 (Régression orthogonale)

Les vecteurs étant orthogonaux, nous avons?X=?U?? ?V. Nous pouvons alors écrire

YX=PXY= (PU+PU?)PXY

=PUPXY+PU?PXY=PUY+PU?∩XYˆYU+ˆYV.

La suite de l"exercice est identique. En conclusion, effectuer une régression multiple sur des variables orthogonales revient à effectuerprégressions simples. Exercice 2.8 (Centrage, centrage-réduction et coefficient constant)1. Comme la dernière colonne deX, notéeXpvaut1nsa moyenne empirique vaut1

et la variable centrée issue deXpest doncXp-1×1n=0n.2. Nous avons le modèle sur variable centrée

Y=˜X˜β+ε

Y-¯Y1n=p-1?

j=1(Xj-¯Xj1n)˜βj+εY=p-1?

j=1˜βjXj+?¯Y-p-1?

j=1¯Xj˜βj?

1 n+ε.En identifiant cela donne

j=˜βj,?j? {1,...,p-1},quotesdbs_dbs6.pdfusesText_11[PDF] exercice aire et périmètre 3eme

[PDF] exercices corrigés arithmétique 3eme

[PDF] relations interspécifiques exercices

[PDF] relations interspécifiques exemples

[PDF] exercice sur les facteurs biotiques

[PDF] démontrer que deux triangles sont isométriques

[PDF] triangles isométriques démonstrations

[PDF] triangles isométriques exercices corrigés

[PDF] figures isométriques et semblables exercices

[PDF] triangles isométriques exercices corrigés 4ème

[PDF] figures isométriques exercices

[PDF] isométrie exercices corrigés

[PDF] exercices corrigés dioptre sphérique

[PDF] exercice sur le pluriel des noms composés