Analyse Numérique - Exercices Corrigés

Analyse Numérique - Exercices Corrigés

de l'itération dans l'intervalle de convergence puis trouver x limite de la suite. Donner l'ordre de la méthode. Exercice 6 On veut calculer les solutions de l

Analyse Numérique

Analyse Numérique

et les exercices. 1.2.2 Perte de chi res signi catifs. Pour faciliter la compréhension nous nous placerons dans l'environnement rassurant de la base 10

Exercices corrigés

Exercices corrigés

enseignant d'analyse numérique pour lui poser une question. Il n'y a donc qu'une seule équation pour relier les variables x1 et x2 d'où l'infinité de ...

ANALYSE NUMERIQUE Mazen SAAD

ANALYSE NUMERIQUE Mazen SAAD

solutions sont les couples (u P) avec. P = (kπ)2

Analyse Numérique : SMA-SMI S4 Cours exercices et examens

Analyse Numérique : SMA-SMI S4 Cours exercices et examens

1.3 Exercices . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 19. 2 Approximations des solutions de l'équation f(x) = 0. 22. 2.1

Analyse Numérique

Analyse Numérique

le problème en un grand nombre de micro-problèmes puis de superposer les solutions de ces micro- exercice 82 avec une démonstration différente de celle qui ...

Exercices Corrigés - Analyse numérique et optimisation Une

Exercices Corrigés - Analyse numérique et optimisation Une

27 jan. 2011 Correction. Dans un premier temps nous allons vérifier formellement que l'ex- pression de θ(t

Exercices et problèmes dAnalyse numérique avec Matlab

Exercices et problèmes dAnalyse numérique avec Matlab

solutions approchées sont très différents quand i devient grand avec n suffisamment grand. 2. Les solutions de y (t) = −b2y(t) forment un sous-espace

Chapitre 1 : Introduction à LAnalyse Numérique

Chapitre 1 : Introduction à LAnalyse Numérique

Utiliser une approximation numérique de la solution ! Page 5. 5/18. Quelques exemples. Calculer les racines du polynôme p(x) = ax2 + bx + c. Page 6. 6/18.

Université Aix Marseille Licence de mathématiques Cours dAnalyse

Université Aix Marseille Licence de mathématiques Cours dAnalyse

Schatzman Analyse numérique

Analyse Numérique

Analyse Numérique

1.5 Exercices du chapitre 1 . Un des buts de l'analyse numérique consiste ... Les zéros de f2 sont exactement les solutions de (2.2). D'autre.

ANALYSE NUMERIQUE Mazen SAAD

ANALYSE NUMERIQUE Mazen SAAD

Devoir surveillé d'Analyse Numérique (2010) et son corrigé. Exercice 1. ... (exacte ou approchée) de la solution d'une équation ou d'un syst`eme ...

M33 Analyse numérique

M33 Analyse numérique

On a inclus dans ce texte nombreux exercices corrigés. Ceux-ci de difficulté variée

Université Aix Marseille Licence de mathématiques Cours dAnalyse

Université Aix Marseille Licence de mathématiques Cours dAnalyse

17 nov. 2021 M. Schatzman Analyse numérique

Analyse numérique : Résolution de systèmes linéaires

Analyse numérique : Résolution de systèmes linéaires

18 mars 2013 Analyse numérique (Pagora 1A). Résolution de ... Exercice introductif (correction) ... Le système précédent admet une infinité de solution.

Exercices Corrigés - Analyse numérique et optimisation Une

Exercices Corrigés - Analyse numérique et optimisation Une

9 janv. 2011 d'introduction `a l'analyse numérique et l'optimisation de Grégoire Allaire [1] ... de la solution dans l' exercice précédent on montre que.

Université Aix Marseille Licence de mathématiques Cours dAnalyse

Université Aix Marseille Licence de mathématiques Cours dAnalyse

17 nov. 2021 M. Schatzman Analyse numérique

Analyse Numérique 0 0

Analyse Numérique 0 0

Les uii étant non nuls l'inconnue x solution du syst`eme linéaire (1.3) est donnée par On revient sur la premi`ere matrice donnée dans l'exercice 2 :.

Exercices corrigés

Exercices corrigés

Analyse numérique. 1ère année. Exercices corrigés. NB : Les exercices corrigés ici sont les exercices proposés durant les séances de cours.

Analyse Numérique

Analyse Numérique

Ce document propose un recueil d'exercices corrigés d'analyse numérique. Le mathématique de l'analyse numérique consiste à modéliser une solution à un.

Analyse Numérique - univ-toulousefr

Analyse Numérique - univ-toulousefr

sance raisonnable de l’analyse des fonctions d’une variable réelle disons du théorème des valeurs intermédiaires jusqu’à la formule de Taylor (qui sera rappelée) et une cer-taine familiarité avec les bases de l’algèbre linéaire (systèmes linéaires applications linéaires matrices et déterminants)

Analyse Numérique

Analyse Numérique

Solutions Exercice 1 (a) g(x) = 1 1 5 sin(4x);x2R Montrons que gest contractante sur R on a : g0(x) = 4 5 cos(4x) et jg0(x)j 4 5; donc d'après le cours gest contractante de rapport de contraction inférieur ou égal à 4 5 (b) g(x) = 2+ 1 2 jxj;x2[ 1;1] Soient x;y2[ 1;1] montrons que jg(x) g(y)j 1 2 jx yjet le rapport de contraction est

Université Aix Marseille

Licence de mathématiques

Cours d"Analyse numérique

Raphaèle Herbin

17 novembre 2021

Table des matières1 Systèmes linéaires5

1.1 Objectifs . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .. . . . . . . . . 5

1.2 Pourquoi et comment? . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .. . . . . . . . . . 5

1.2.1 Quelques rappels d"algèbre linéaire . . . . . . . . . . . . . .. . . . . . . . . . . . . . . 5

1.2.2 Discrétisation de l"équation de la chaleur . . . . . . . . .. . . . . . . . . . . . . . . . . 11

1.2.3 Exercices (matrices, exemples) . . . . . . . . . . . . . . . . . .. . . . . . . . . . . . . . 16

1.2.4 Suggestions pour les exercices . . . . . . . . . . . . . . . . . . .. . . . . . . . . . . . . 22

1.2.5 Corrigés des exercices . . . . . . . . . . . . . . . . . . . . . . . . . .. . . . . . . . . . 23

1.3 Les méthodes directes . . . . . . . . . . . . . . . . . . . . . . . . . . . . .. . . . . . . . . . . . 29

1.3.1 Définition . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .. . . . . . 29

1.3.2 Méthode de Gauss, méthodeLU. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 29

1.3.3 Méthode de Choleski . . . . . . . . . . . . . . . . . . . . . . . . . . . . .. . . . . . . . 39

1.3.4 Quelques propriétés . . . . . . . . . . . . . . . . . . . . . . . . . . . .. . . . . . . . . 45

1.3.5 Exercices (méthodes directes) . . . . . . . . . . . . . . . . . . .. . . . . . . . . . . . . 47

1.3.6 Suggestions . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .. . . . . . . 52

1.3.7 Corrigés . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .. . . . . . 53

1.4 Normes et conditionnement d"une matrice . . . . . . . . . . . . .. . . . . . . . . . . . . . . . . 63

1.4.1 Normes, rayon spectral . . . . . . . . . . . . . . . . . . . . . . . . . .. . . . . . . . . . 63

1.4.2 Le problème des erreurs d"arrondis . . . . . . . . . . . . . . . .. . . . . . . . . . . . . 69

1.4.3 Conditionnement et majoration de l"erreur d"arrondi. . . . . . . . . . . . . . . . . . . . 69

1.4.4 Discrétisation d"équations différentielles, conditionnement efficace" . . . . . . . . . . . 73

1.4.5 Exercices (normes et conditionnement) . . . . . . . . . . . .. . . . . . . . . . . . . . . 73

1.4.6 Suggestions pour les exercices . . . . . . . . . . . . . . . . . . .. . . . . . . . . . . . . 80

1.4.7 Corrigés . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .. . . . . . 81

1.5 Méthodes itératives . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .. . . . . . . . . . . . 90

1.5.1 Définition et propriétés . . . . . . . . . . . . . . . . . . . . . . . . .. . . . . . . . . . . 90

1.5.2 Quelques exemples de méthodes itératives . . . . . . . . . .. . . . . . . . . . . . . . . . 92

1.5.3 Les méthodes par blocs . . . . . . . . . . . . . . . . . . . . . . . . . . .. . . . . . . . . 98

1.5.4 Exercices (méthodes itératives) . . . . . . . . . . . . . . . . .. . . . . . . . . . . . . . . 101

1.5.5 Exercices, suggestions . . . . . . . . . . . . . . . . . . . . . . . . .. . . . . . . . . . . 111

1.5.6 Exercices, corrigés . . . . . . . . . . . . . . . . . . . . . . . . . . . .. . . . . . . . . . 112

1.6 Valeurs propres et vecteurs propres . . . . . . . . . . . . . . . . .. . . . . . . . . . . . . . . . . 121

1.6.1 Méthode de la puissance et de la puissance inverse . . . .. . . . . . . . . . . . . . . . . 121

1.6.2 Méthode QR . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .. . . . 122

1.6.3 Exercices (valeurs propres, vecteurs propres) . . . . .. . . . . . . . . . . . . . . . . . . 123

1.6.4 Suggestions . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .. . . . . . . 127

1.6.5 Corrigés . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .. . . . . . 128

1TABLE DES MATIÈRESTABLE DES MATIÈRES

2 Systèmes non linéaires134

2.1 Rappels et notations de calcul différentiel . . . . . . . . . .. . . . . . . . . . . . . . . . . . . . 134

2.1.1 Différentielle . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .. . . . . . . . . 134

2.1.2 Différentielle d"ordre 2, matrice hessienne. . . . . . .. . . . . . . . . . . . . . . . . . . 136

2.1.3 Exercices (calcul différentiel) . . . . . . . . . . . . . . . . .. . . . . . . . . . . . . . . 137

2.2 Les méthodes de point fixe . . . . . . . . . . . . . . . . . . . . . . . . . . .. . . . . . . . . . . 138

2.2.1 Point fixe de contraction . . . . . . . . . . . . . . . . . . . . . . . . .. . . . . . . . . . 138

2.2.2 Point fixe de monotonie . . . . . . . . . . . . . . . . . . . . . . . . . . .. . . . . . . . 142

2.2.3 Vitesse de convergence . . . . . . . . . . . . . . . . . . . . . . . . . .. . . . . . . . . . 144

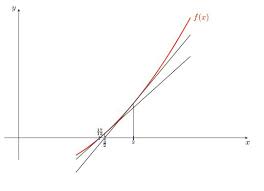

2.2.4 Méthode de Newton dansIR. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 146

2.2.5 Exercices (méthodes de point fixe) . . . . . . . . . . . . . . . . .. . . . . . . . . . . . . 147

2.3 Méthode de Newton dansIRn. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 154

2.3.1 Construction et convergencede la méthode . . . . . . . . . .. . . . . . . . . . . . . . . 154

2.3.2 Variantes de la méthode de Newton . . . . . . . . . . . . . . . . . .. . . . . . . . . . . 156

2.3.3 Exercices (méthode de Newton) . . . . . . . . . . . . . . . . . . . .. . . . . . . . . . . 159

3 Optimisation184

3.1 Définitions et rappels . . . . . . . . . . . . . . . . . . . . . . . . . . . . .. . . . . . . . . . . . 184

3.1.1 Extrema, points critiques et points selle. . . . . . . . . .. . . . . . . . . . . . . . . . . . 184

3.1.2 Convexité . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .. . . . . . 185

3.1.3 Exercices (extrema, convexité) . . . . . . . . . . . . . . . . . .. . . . . . . . . . . . . . 187

3.2 Optimisation sans contrainte . . . . . . . . . . . . . . . . . . . . . .. . . . . . . . . . . . . . . 189

3.2.1 Définition et condition d"optimalité . . . . . . . . . . . . . .. . . . . . . . . . . . . . . 189

3.2.2 Résultats d"existence et d"unicité . . . . . . . . . . . . . . .. . . . . . . . . . . . . . . . 190

3.2.3 Exercices (optimisation sans contrainte) . . . . . . . . .. . . . . . . . . . . . . . . . . . 193

3.3 Algorithmes d"optimisation sans contrainte . . . . . . . . .. . . . . . . . . . . . . . . . . . . . 199

3.3.1 Méthodes de descente . . . . . . . . . . . . . . . . . . . . . . . . . . . .. . . . . . . . 199

3.3.2 Algorithme du gradient conjugué . . . . . . . . . . . . . . . . . .. . . . . . . . . . . . 202

3.3.3 Méthodes de Newton et Quasi-Newton . . . . . . . . . . . . . . . .. . . . . . . . . . . 206

3.3.4 Résumé sur les méthodes d"optimisation . . . . . . . . . . . .. . . . . . . . . . . . . . . 209

3.3.5 Exercices (algorithmes pour l"optimisation sans contraintes) . . . . . . . . . . . . . . . . 209

3.4 Optimisation sous contraintes . . . . . . . . . . . . . . . . . . . . .. . . . . . . . . . . . . . . . 230

3.4.1 Définitions . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .. . . . . . 230

3.4.2 Existence - Unicité - Conditions d"optimalité simple. . . . . . . . . . . . . . . . . . . . 230

3.4.3 Conditions d"optimalité dans le cas de contraintes égalité . . . . . . . . . . . . . . . . . . 232

3.4.4 Contraintes inégalités . . . . . . . . . . . . . . . . . . . . . . . . .. . . . . . . . . . . . 234

3.4.5 Exercices (optimisation avec contraintes) . . . . . . . .. . . . . . . . . . . . . . . . . . 235

3.5 Algorithmes d"optimisation sous contraintes . . . . . . . .. . . . . . . . . . . . . . . . . . . . . 239

3.5.1 Méthodes de gradient avec projection . . . . . . . . . . . . . .. . . . . . . . . . . . . . 239

3.5.2 Méthodes de dualité . . . . . . . . . . . . . . . . . . . . . . . . . . . . .. . . . . . . . 242

3.5.3 Exercices (algorithmes pour l"optimisation avec contraintes) . . . . . . . . . . . . . . . . 244

3.5.4 Corrigés . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .. . . . . . 247

4 Equations différentielles249

4.1 Introduction . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .. . . . . . . . . . 249

4.2 Consistance, stabilité et convergence . . . . . . . . . . . . . .. . . . . . . . . . . . . . . . . . . 252

4.3 Théorème général de convergence . . . . . . . . . . . . . . . . . . . .. . . . . . . . . . . . . . 254

4.4 Exemples . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .. . . . . . . 256

4.5 Explicite ou implicite? . . . . . . . . . . . . . . . . . . . . . . . . . . .. . . . . . . . . . . . . 257

4.5.1 L"implicite gagne... . . . . . . . . . . . . . . . . . . . . . . . . . . .. . . . . . . . . . . 257

4.5.2 L"implicite perd... . . . . . . . . . . . . . . . . . . . . . . . . . . . .. . . . . . . . . . . 258

4.5.3 Match nul . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .. . . . . 258

Analyse numérique I, télé-enseignement, L32Université d"Aix-Marseille, R. Herbin, 17 novembre 2021

TABLE DES MATIÈRESTABLE DES MATIÈRES

4.6 Etude du schéma d"Euler implicite . . . . . . . . . . . . . . . . . . .. . . . . . . . . . . . . . . 258

4.7 Exercices . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .. . . . . . . . 260

4.8 Corrigés . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .. . . . . . . . 267

5 Quelques problèmes supplémentaires276

5.1 Méthode de Jacobi et optimisation . . . . . . . . . . . . . . . . . . .. . . . . . . . . . . . . . . 276

5.2 Assemblage de matrices EF . . . . . . . . . . . . . . . . . . . . . . . . . .. . . . . . . . . . . . 278

5.2.1 Notations et rappels . . . . . . . . . . . . . . . . . . . . . . . . . . . .. . . . . . . . . . 278

5.2.2 Méthode des éléments finis et matrices d"assemblage . .. . . . . . . . . . . . . . . . . . 278

5.2.3 Un exemple 1D simple . . . . . . . . . . . . . . . . . . . . . . . . . . . . .. . . . . . . 279

5.2.4 Propriétés de la matriceA. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 281

5.2.5 Deux cas particuliers . . . . . . . . . . . . . . . . . . . . . . . . . . .. . . . . . . . . . 284

5.2.6 Un peu d"optimisation pour terminer... . . . . . . . . . . . .. . . . . . . . . . . . . . . . 287

Analyse numérique I, télé-enseignement, L33Université d"Aix-Marseille, R. Herbin, 17 novembre 2021

IntroductionL"objet de l"analyse numérique est de concevoir et d"étudier des méthodes de résolution de certains problèmes

mathématiques, en général issus de la modélisation de problèmes réels", et dont on cherche à calculer la solution

à l"aide d"un ordinateur.

Le cours est structuré en quatre grands chapitres : Systèmes linéaires

Systèmes non linéaires

Optimisation

Equations différentielles.

On pourra consulter les ouvrages suivants pour ces différentes parties (ceci est une liste non exhaustive!) :

A. Quarteroni,R. Sacco et F. Saleri, MéthodesNumériques:Algorithmes,Analyseet Applications,Springer

2006. P.G. Ciarlet, Introduction à l"analyse numérique et à l"optimisation, Masson, 1982, (pour les chapitre 1 à 3

de ce polycopié). M. Crouzeix, A.L. Mignot, Analyse numérique des équationsdifférentielles, Collection mathématiques ap-

pliquées pour la maitrise, Masson, (pour le chapitre 4 de ce polycopié). J.P. Demailly, Analyse numérique et équations différentielles Collection Grenoble sciences Presses Univer-

sitaires de Grenoble L.Dumas,Modélisationà l"oraldel"agrégation,calculscientifique,CollectionCAPES/Agrégation,Ellipses,

1999. E. Hairer, polycopié du cours "Analyse Numérique", http ://www.unige.ch/ hairer/polycop.html

J. Hubbard, B. West, Equations différentielles et systèmes dynamiques, Cassini. J. Hubbard et F. Hubert, Calcul Scientifique, Vuibert. P. Lascaux et R. Théodor, Analyse numérique matricielle appliquée à l"art de l"ingénieur, tomes 1 et 2,

Masson, 1987

L. Sainsaulieu, Calcul scientifique cours et exercices corrigés pour le 2ème cycle et les éécoles d"ingénieurs,

Enseignement des mathématiques, Masson, 1996.

M. Schatzman, Analyse numérique, cours et exercices, (chapitres 1,2 et 4). D. Serre, Les matrices, Masson, (2000). (chapitres 1,2 et 4). P. Lascaux et R. Theodor, Analyse numérique sappliquée auxsciences de l"ingénieur, Paris, (1994)

R. Temam, Analyse numérique, Collection SUP le mathématicien, Presses Universitaires de France, 1970.

Et pour les anglophiles...

M. Braun, Differential Equations and their applications,Springer, New York,1984 (chapitre 4).Englewood Cliffs, NJ.

4TABLE DES MATIÈRESTABLE DES MATIÈRES

R. Fletcher, Practical methods of optimization, J. Wiley,New York, 1980 (chapitre 3). G. Golub and C. Van Loan, Matrix computations, The John Hopkins University Press, Baltimore (chapitre

1). R.S. Varga, Matrix iterative analysis, Prentice Hall, Englewood Cliffs, NJ 1962.Pour des rappels d"algègre linéaire :

Polyd"algèbrelinéairedepremièreannée,P.Bousquet,R.HerbinetF.Hubert,https://www.i2m.univ-amu.fr/perso/rapha

Introduction to linear algebra, Gilbert Strang, Wellesley Cambridge Press, 2008Analyse numérique I, télé-enseignement, L35Université d"Aix-Marseille, R. Herbin, 17 novembre 2021

Chapitre 1Systèmes linéaires1.1 ObjectifsOn noteMn(IR)l"ensemble des matrices carrées d"ordren. SoitA?Mn(IR)une matrice inversible etb?IRn,

l"objectif est de résoudre le système linéaireAx=b, c"est-à-dire de trouverxsolution de :

?x?IRnAx=b(1.1)

CommeAest inversible, il existe un unique vecteurx?IRnsolution de (1.1). Nous allons étudier dans les deux

paragraphes suivants des méthodes de calcul de ce vecteurx: la première partie de ce chapitre sera consacrée

aux méthodes directes" et la deuxième aux méthodes itératives". Nous aborderonsensuite en troisième partie les

méthodes de résolution de problèmes aux valeurs propres.Un des points essentiels dans l"efficacité des méthodes envisagées concerne la taille des systèmes à résoudre. La

taille de la mémoire des ordinateurs a augmenté de façon drastique de 1980 à nos jours.Le développement des méthodes de résolution de systèmes linéaires est liée à l"évolution des machines infor-

matiques. C"est un domaine de recherche très actif que de concevoir des méthodes qui permettent de profiter au

mieuxdel"architecturedesmachines(méthodesdedécompositionensous domainespourprofiterdesarchitectures

parallèles, par exemple).Dans la suite de ce chapitre, nous verrons deux types de méthodes pour résoudre les systèmes linéaires : les

méthodes directes et les méthodes itératives. Pour faciliter la compréhension de leur étude, nous commençons par

quelques rappels d"algèbre linéaire.1.2 Pourquoi et comment?

Nous donnons dans ce paragraphe un exemple de problème dont la résolution numérique recquiert la résolution

d"un système linéaire, et qui nous permet d"introduire des matrices que nous allons beaucoup étudier par la suite.

Nous commençons par donner ci-après après quelques rappelssuccincts d"algèbre linéaire, outil fondamentalpour

la résolution de ces systèmes linéaires.1.2.1 Quelques rappels d"algèbre linéaire

Quelques notions de base

Ce paragraphe rappelle des notions fondamentales que vous devriez connaître à l"issue du cours d"algèbre linéaire

de première année. On va commencer par revisiter leproduit matriciel, dont la vision combinaison linéaire de

lignes est fondamentale pour bien comprendre la forme matricielle de la procédure d"élimination de Gauss.

61.2. POURQUOI ET COMMENT? CHAPITRE 1. SYSTÈMES LINÉAIRES

SoientAetBdeux matrices carrées d"ordren, etM=AB. Prenons comme exemple d"illustrationA=?1 20 1?

,B=?-1 0 3 2? etM=?5 43 2? On noteai,j,bi,jetmi,j,i,j= 1,...nles coefficients respectifs deA,BetM. Vous savez bien sûr que m i,j=n? k=1a i,kbk,j.(1.2) On peut écrire les matricesAetBsous forme de lignes (notées?i) et colonnes (notéescj) : A=??? 1(A) n(A)?? etB=?c1(B)...cn(B)?Dans nos exemples, on a donc

1(A) =?1 2?,?2(A) =?0 1?,c1(B) =?-1

3? c2(B) =?02?

L"expression (1.2) s"écrit encore

m i,j=?i(A)cj(B),qui est le produit d"une matrice1×npar une matricen×1, qu"on peut aussi écrire sous forme d"un produit

scalaire : m i,j= (?i(A))t·cj(B)où(?i(A))tdésigne la matrice transposée, qui est donc maintenant une matricen×1qu"on peut identifier à un

vecteur deIRn. C"est la technique habituelle" de calcul du produit de deux matrices. On a dans notre exemple :

m1,2=?1(A)c2(B) =?1(A)c2(B) =?1 2??02?

= (?i(A))t·cj(B) =?12?·?02?

= 4.Mais de l"expression (1.2), on peut aussi avoir l"expression des lignes et des colonnes deM=ABen fonction

des lignes deBou des colonnes deA: i(AB) =n? k=1a i,k?k(B)(1.3) c j(AB) =n?k=1b k,jck(A)(1.4)Dans notre exemple, on a donc :

1(AB) =?-1 0?+ 2?3 2?=?5 4?

ce qui montre que la ligne 1 deABest une combinaison linéaire des lignes deB. Le colonnes deAB, par contre,

sont des combinaisons linéaires de colonnes deA. Par exemple : c2(AB) = 0?10?

+ 2?21? =?42? Il faut donc retenir que dans un produit matricielAB,Analyse numérique I, télé-enseignement, L37Université d"Aix-Marseille, R. Herbin, 17 novembre 2021

1.2. POURQUOI ET COMMENT? CHAPITRE 1. SYSTÈMES LINÉAIRES

les colonnes deABsont des combinaisons linéaires des colonnes deA les lignes deABsont des combinaisons linéaires des lignes deB.Cette remarque est très importante pour la représentation matricielle de l"élimination de Gauss : lorqu"on calcule

des systèmes équivalents, on effectue des combinaisons linéaires de lignes, et donc on multiplie à gauche par une

matrice d"élimination.Il est intéressant pour la suite de ce cours de voir ce que donne la multiplication d"une matrice par une matrice de

permutation. Commençons par une exemple. SoitPetAdes matrices carrées d"ordre 2 définies parP=?0 11 0?

, A=?a b c d? , PA=?c d a b? , AP=?b a d c?La multiplication deApar la matricePéchange les lignes deAlorqu"on multiplieAparPà gauche, et elle

échangeles colonnesdeAlorqu"onmultiplieAparPà droite.Noter que ceci montred"ailleurs bienque le produit

matriciel n"est pas commutatif...La matricePs"appelle matrice de permutation. Les matrices de permutation

auront un fort rôle à jouer dans l"élaboration d"algorithmes de résolution des systèmes linéaires (voir l"algorithme

de Gauss avec pivot partiel).De manière plus générale, on peut définir une matrice de permutation de la façon suivante :

Définition 1.1(Matrice de permutation).Soitn?INet soienti,j? {1,...,n}. On noteraP(i↔j)?Mn(IR)la

matrice telle que :1. Sii=j,P(i↔j)= Idn,

2. Sii?=j,p(i↔j)

i,i=p(i↔j) j,j= 0,p(i↔j) i,j=p(i↔j) j,i= 1, et pour toutk,l? {1,...,n}tel que(k,l)/? {(i,i),(i,j),(j,i),(j,j)}, sik=l,p(i↔j) k,l= 1sinonp(i↔j) k,l= 0.La matriceP(i↔j)est alors appelée matrice de permutation élémentaire. Une matrice de permutation est définie

comme le produit d"un nombre fini de permutations élémentaires.Remarquons qu"une matrice de permutation possède alorsntermes égaux à1, et tous les autres égaux à 0, tels

que chaque ligne et chaque colonne comprenne exactement l"un des termes égaux à1(pour les amateurs de jeu

d"échecs, ces termes sont disposés commentours sur un échiquier de taillen×ntelles qu"aucune tour ne peut en

prendre une autre).Pour toute matriceA?Mn(IR)et toute matrice de permutationP, la matricePAest obtenue à partir deApar

permutation des lignes deA, et la matriceAPest obtenue à partir deApar permutation des colonnes deA. Dans

un système linéaireAx=b, on remarque qu"on ne change pas la solutionxsi on permute des lignes, c"est à

dire si l"on résoutPAx=Pb. Notons que le produit de matrices de permutation est évidemment une matrice de

permutation, et que toute matrice de permutationPest inversible etP-1=Pt(voir exercice 2).Le tableau 1.1 est la traduction littérale de Linear algebra in a nutshell", par Gilbert Strang1Pour une matrice

carréeA, on donne les caractérisations du fait qu"elle est inversible ou non.On rappelle pour une bonne lecture de ce tableau les quelquesdéfinitions suivantes (pour le cas ou il y aurait des

notions que vous avez oubliées ou que vous ne maîtrisez pas bien).Définition 1.2(Pivot).SoitA?Mn(IR)une matrice carrée d"ordren. On appelle pivot deAle premier élément

non nul de chaque ligne dans la forme échelonnée deAobtenue par élimination de Gauss. Si la matrice est

inversible, elle a doncnpivots (non nuls).1. Voir la page web de Strangwww.mit.edu/~gspour une foule d"informations et de cours sur l"algèbre linéaire.

Analyse numérique I, télé-enseignement, L38Université d"Aix-Marseille, R. Herbin, 17 novembre 2021

1.2. POURQUOI ET COMMENT? CHAPITRE 1. SYSTÈMES LINÉAIRES

AinversibleAnon inversible

Les vecteurs colonne sont indépendants Les vecteurs colonne sont liés Les vecteurs ligne sont indépendants Les vecteurs ligne sont liés Le déterminant est non nul Le déterminant est nul Ax= 0a une unique solutionx=0Ax=0a une infinité de solutions Le noyau deAest réduit à{0}Le noyau deAcontient au moins un vecteur non nul Ax=ba une solution uniquex=A-1bAx=ba soit aucune solution, soit une infinitéAanpivots (non nuls)Aar < npivots

Aest de rang maximal : rang(A) =n. rang(A) =r < n

La forme totatement échelonnéeRdeAest la matrice identitéRa au moins une ligne de zéros L"image deAest toutIRnL"image deAest strictement incluse dansIRn L"espaceL(A)engendré par les lignes deAest toutIRnL(A)est de dimensionr < n Toutes les valeurs propres deAsont non nulles Zéro est valeur propre deA A tAest symétrique définie positiveAtAn"est que semi-définie TABLE1.1: Extrait de Linear algebra in a nutshell", G. StrangDéfinition 1.3(Valeurs propres).SoitA?Mn(IR)une matrice carrée d"ordren. On appelle valeur propre deA

toutλ?Cltel qu"il existex?Cln,x?= 0tel queAx=λx. L"élémentxest appelé vecteur propre deAassocié à

Définition 1.4(Déterminant).Il existe une unique application, notéedetdeMn(IR)dansIRqui vérifie les pro-

priétés suivantes (D1) Le déterminant de la matrice identité est égal à 1. (D2) Si la matrice ˜Aest obtenue à partir deApar échange de deux lignes, alorsdet˜A=-detA. (D3) Le déterminant est une fonction linéaire de chacune deslignes de la matriceA. (D3a) (multiplication par un scalaire) si ˜Aest obtenue à partir deAen multipliant tous les coefficientsd"une ligne parλ?IR, alorsdet(˜A) =λdet(A). 1(A) k(A) 1(A) .˜?k(A) 1(A) k(A) +˜?k(A) , alors det(B) = det(A) + det(˜A).On peut déduire de ces trois propriétés fondamentales un grand nombre de propriétés importantes, en particulier

le fait quedet(AB) = detAdetBet que le déterminant d"une matrice inversible est le produit des pivots : c"est

de cette manière qu"on le calcule sur les ordinateurs. En particulier on n"utilise jamais la formule de Cramer,

beaucoup trop coûteuse en termes de nombre d"opérations.On rappelle que siA?Mn(IR)une matrice carrée d"ordren, les valeurs propres sont les racines dupolynôme

caractéristiquePAde degrén, qui s"écrit : PA(λ) = det(A-λI).

Analyse numérique I, télé-enseignement, L39Université d"Aix-Marseille, R. Herbin, 17 novembre 2021

1.2. POURQUOI ET COMMENT? CHAPITRE 1. SYSTÈMES LINÉAIRES

matrice carrée d"ordren.On dit que la matriceAest symétrique définie positive (s.d.p.) si elle est symétrique et si elle vérifie de plus

Ax·x≥0pour toutx?IRnet[Ax·x= 0 =?x=0pour toutx?IRn].OnditquelamatriceAestsymétriquesemi-définiepositive(s.d.p.)si elle estsymétriqueet si ellevérifieAx·x≥0

pour toutx?IRn.Matrices diagonalisables

Un point important de l"algèbre linéaire, appelé réduction des endomorphismes" dans les programmes français,

consiste à se demander s"il existe une base de l"espace dans laquelle la matrice de l"application linéaire est diago-

nale ou tout au moins triangulaire (on dit aussi trigonale).Définition 1.6(Matrice diagonalisable dansIR).SoitAune matrice réelle carrée d"ordren. On dit queAest

diagonalisable dansIRs"il existe une base(u1,...,un)deIRnet des réelsλ1,...,λn(pas forcément distincts)

tels queAui=λiuipouri= 1,...,n. Les réelsλ1,...,λnsont les valeurs propres deA, et les vecteurs

u1,...,unsont des vecteurs propres associés.

Vous connaissez sûrement aussi la diagonalisation dansCl: une matrice réelle carrée d"ordrenadmet toujoursn

valeurs propres dansCl, qui ne sont pas forcément distinctes. Une matrice est diagonalisable dansCls"il existe une

base(u1,...,un)deClnet des nombres complexesλ1,...,λn(pas forcément distincts) tels queAui=λiui

pouri= 1,...,n. Ceci est vérifié si la dimension de chaque sous espace propreEi= ker(A-λiId)(appelée

multiplicité géométrique) est égale a la multiplicité algébrique deλi, c"est-à-dire son ordre de multiplicité en tant

que racine du polynôme caractéristique.Par exemple la matriceA=?0 01 0?

n"est pas diagonalisable dansCl(ni évidemment, dansIR). Le polynômecaractéristique deAestPA(λ) =λ2, l"unique valeur propre est donc 0, qui est de multiplicité algébrique 2, et de

multiplicité géométrique 1, car le sous espace propre associé à la valeur propre nulle estF={x?IR2;Ax=

0}={x= (0,t),t?IR}, qui est de dimension 1.

Ici et dans toute la suite, comme on résout des systèmes linéaires réels, on préfère travailler avec la diagonalisation

dansIR; cependant il y a des cas où la diagonalisation dansClest utile et même nécessaire (étude de stabilité des

systèmes diférentiels, par exemple). Par souci de clarté, nous préciserons toujours si la diagonalisation considérée

est dansIRou dansCl. Lemme 1.7.SoitAune matrice réelle carrée d"ordren, diagonalisable dansIR. AlorsA=Pdiag(λ1,...,λn)P-1,

oùPest la matrice dont les vecteurs colonnes sont égaux à des vecteurs propresu1,...,unassociées aux valeurs

propresλ1,...,λn.Analyse numérique I, télé-enseignement, L310Université d"Aix-Marseille, R. Herbin, 17 novembre 2021

1.2. POURQUOI ET COMMENT? CHAPITRE 1. SYSTÈMES LINÉAIRES

DÉMONSTRATION- Par définition d"un vecteur propre, on aAui=λiuipouri= 1,...n, et donc, en notantPla

matrice dont les colonnes sont les vecteurs propresui,?Au1... Aun?=A?u1...un?=AP

et doncAP=?λ

1u1... λnun?=?u

1...un??????λ

10...0

0λ2......

0...0λn?????

=Pdiag(λ1,...,λn).Notons que dans ce calcul, on a fortement utilisé la multiplication des matrices par colonnes, c.à.d.

c i(AB) =n? j=1a i,jcj(B).Remarquons quePest aussi la matrice définie (de manière unique) parPei=ui, où(ei)i=1,...,nest la base canonique

deIRn, c"est-à-dire que(ei)j=δi,j. La matricePest appelée matrice de passage de la base(ei)i=1,...,nà la base

(ui)i=1,...,n; (il est bien clair que lai-ème colonne dePest constituée des composantes deuidans la base canonique

(e1,...,en).La matricePest inversible car les vecteurs propres forment une base, eton peut donc aussi écrire :

P -1AP= diag(λ1,...,λn)ouA=Pdiag(λ1,...,λn)P-1.La diagonalisation des matrices réelles symétriques est unoutil qu"on utilisera souvent dans la suite, en particulier

dans les exercices. Il s"agit d"un résultat extrêmement important.Lemme 1.8(Une matrice symétrique est diagonalisable dansIR).SoitEun espace vectoriel surIRde dimension

finie :dimE=n,n?IN?, muni d"un produit scalaire i.e. d"une applicationE×E→IR,

(x,y)→(x|y)E, qui vérifie : ?x?E,(x|x)E≥0et(x|x)E= 0?x= 0, ?(x,y)?E2,(x|y)E= (y|x)E, ?y?E,l"application deEdansIR,définie parx→(x|y)Eest linéaire. Ce produit scalaire induit une norme surEdéfinie par?x?=? (x|x)E.SoitTune application linéaire deEdansE. On suppose queTest symétrique, c.à.d. que(T(x)|y)E= (x|

T(y))E,?(x,y)?E2. Alors il existe une base orthonormée(f1,...,fn)deE(c.à.d. telle que(fi|fj)E= i,j) etλ1,...,λndansIRtels queT(fi) =λifipour touti? {1...n}.Conséquence immédiate :Dans le cas oùE= IRn, le produit scalaire canonique dex= (x1,...,xn)tet

y= (y1,...,yn)test défini par(x|y)E=x·y=?ni=1xiyi. SiA?Mn(IR)est une matrice symétrique, alors

l"applicationTdéfinie deEdansEpar :T(x) =Axest linéaire, et : (T(x)|y) =Ax·y=x·Aty=x·Ay= (x|T(y)).DoncTest linéaire symétrique. Par le lemme précédent, il existe(f1,...,fn)et(λ1...λn)?IRtels que

T(fi) =Afi=λifi?i? {1,...,n}etfi·fj=δi,j,?(i,j)? {1,...,n}2.Interprétation algébrique :Il existe une matrice de passagePde(e1,...,en)base canonique deIRndans la

base(f1,...,fn)dontlai-èmecolonnedePest constituéedes coordonnéesdefidans la base(e1...en). On a :

Analyse numérique I, télé-enseignement, L311Université d"Aix-Marseille, R. Herbin, 17 novembre 2021

quotesdbs_dbs48.pdfusesText_48[PDF] analyse numérique exercices et problèmes corrigés

[PDF] analyse numérique interpolation polynomiale exercices corrigés

[PDF] analyse numérique matricielle exercices corrigés pdf

[PDF] analyse numérique matricielle pdf

[PDF] analyse numérique pour ingénieurs

[PDF] analyse physico chimique du lait cru pdf

[PDF] analyse physico chimique du lait de vache pdf

[PDF] analyse physico chimique du lait en poudre

[PDF] analyse physico chimique du lait ppt

[PDF] analyse physico chimique du miel

[PDF] analyse physico-chimique des dattes

[PDF] analyse psychologique gratuite

[PDF] analyse séquentielle des politiques publiques

[PDF] analyse sociologique film ressources humaines